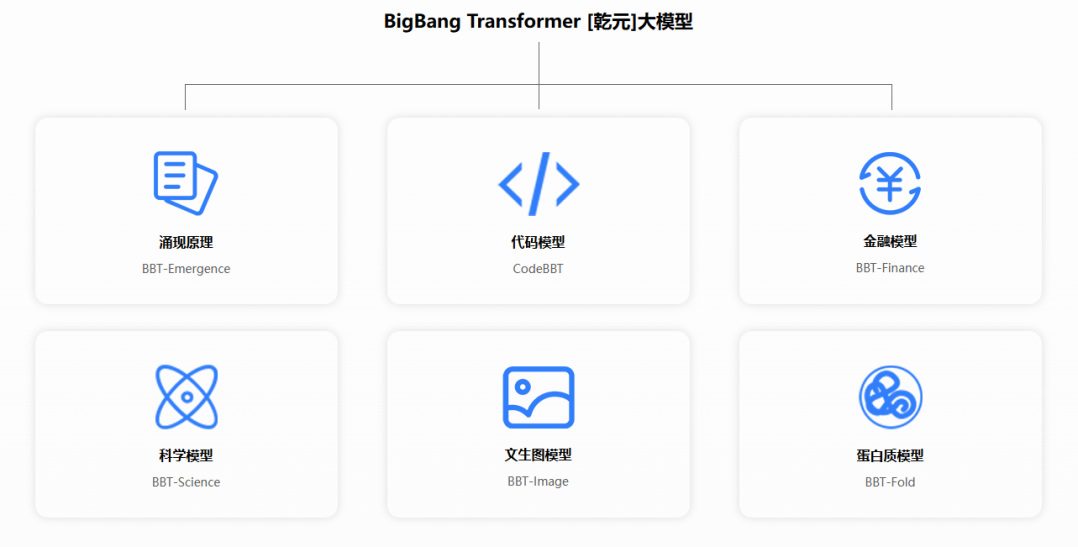

乾元BigBangTransformer

乾元BigBangTransformer(BBT)是一系列基于GPT Decoder-only架构的大规模预训练模型,适用于对话生成、文本摘要、翻译等多种语言任务。BBT模型通过2000亿tokens的预训练,支持多语言处理,开源并可微调,广泛应用于金融、新闻等领域。

乾元BigBangTransformer:引领自然语言处理新时代

乾元BigBangTransformer(简称BBT)是一系列基于GPT Decoder-only架构的大规模预训练模型,专为处理和理解自然语言而设计。这些模型能够执行多种语言相关的任务,如对话生成、文本摘要、翻译等,助力您在自然语言处理领域取得突破。

核心优势:

- 大规模预训练: 利用高达2000亿tokens的庞大语料库进行预训练,确保模型的强大理解和生成能力。

- 多语言支持: 涵盖中文、英文等多种语言,满足全球用户的需求。

- 开源特性: 模型代码和权重向社区开放,方便开发者使用和进一步研究。

- 灵活的微调: 通过指令微调,模型可轻松适应特定下游任务。

强大功能:

- 对话生成: 生成连贯和相关的对话文本,提升用户体验。

- 文本理解: 准确理解并回答基于文本的问题,提升信息获取效率。

- 自定义训练: 支持使用自定义数据对模型进行进一步训练和微调,满足个性化需求。

- 多领域应用: 广泛应用于金融、新闻、社交媒体等领域,推动行业发展。

应用示例:

假设您是一名金融分析师,乾元BigBangTransformer可以帮助您:

- 自动生成市场分析报告:快速生成市场分析报告的草稿,节省时间。

- 财经新闻情感分析:对财经新闻进行情感分析,预测市场趋势。

- 金融术语理解:通过微调模型,理解特定的金融术语和概念。

- 客户自动化交流:利用模型的对话能力,与客户进行高效的自动化交流。

总结:

乾元BigBangTransformer是一系列功能强大的预训练语言模型,通过大规模数据训练,具备了优秀的语言理解和生成能力。其开源特性为开发者提供了极大的灵活性,使其能够根据不同的应用场景进行定制和优化,推动自然语言处理技术的发展和应用。