AI大模型神奇诞生:Gen-2和Pika拳脚相加,谷歌奋斗7个月揭露绝技!创新时空架构,承载史诗级长篇影像

从现在开始,努力学习吧!本文《AI大模型神奇诞生:Gen-2和Pika拳脚相加,谷歌奋斗7个月揭露绝技!创新时空架构,承载史诗级长篇影像》主要讲解了等等相关知识点,我会在golang学习网中持续更新相关的系列文章,欢迎大家关注并积极留言建议。下面就先一起来看一下本篇正文内容吧,希望能帮到你!

AI视频赛道上,谷歌又再次放出王炸级更新!

这个名为Google Lumiere的模型,是个大规模视频扩散模型,彻底改变了AI视频的游戏规则。

跟其他模型不同,Lumiere凭借最先进的时空U-Net架构,在一次一致的通道中生成整个视频。

现有AI生成视频的模型主要基于简短视频进行时间采样。

Google Lumiere是谷歌推出的新模型,它通过联合空间和时间下采样来生成视频。这种方法能够显著提升生成视频的长度和质量。

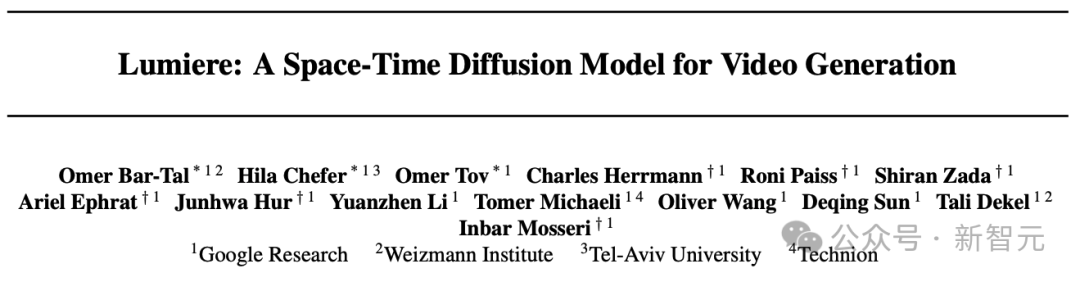

论文地址:https://arxiv.org/abs/2401.12945

值得一提的是,这是谷歌团队历时7个月做出的最新成果。

对于这惊人的「谷歌速度」,网友们纷纷表示惊叹——

谷歌从来不睡觉啊?

开发者回答:不睡

居然做出了走路、跳舞这样的人体力学视频,我的天,我以为这需要6到12个月才能做出来,AI真的是在以闪电般的速度发展。(我的工作流中需要这个模型)

全新STUNet架构:时间更长更连贯

为了解决AI视频长度不足,运动连贯性和一致性很低,伪影重重等一系列问题,研究人员提出了一个名为Space-Time U-Net(STUNet)的架构。

传统视频模型生成的视频往往会出现奇怪的动作和伪影

能够学习将视频信号在空间和时间上同时进行下采样和上采样,并在网络的压缩空间时间表征上执行主要计算。

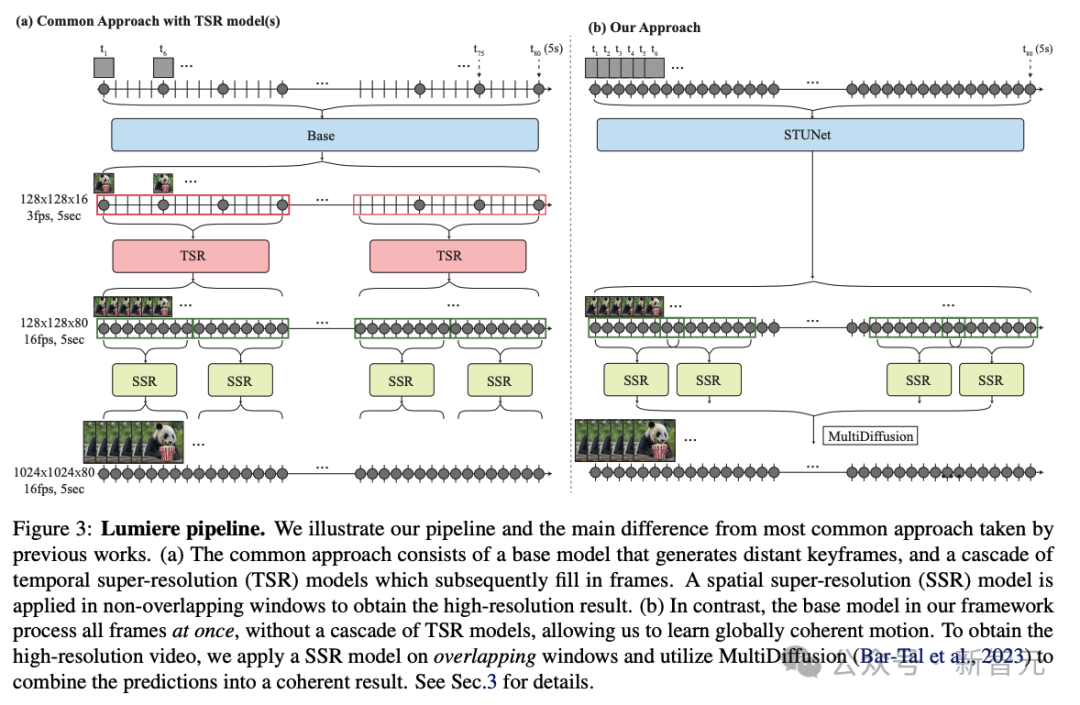

相比之前的文本到视频模型采用级联设计的方式,先由基模型生成关键帧,然后使用一系列时序超分辨率模型在非重叠段内进行插值帧的生成。

STUNet可以学习直接生成全帧率的低分辨率视频。这种设计避免了时序级联结构在生成全局连贯运动时固有的限制。

STUNet架构可以直接生成5秒长的80帧视频,时间长度超过大多数媒体中的平均镜头长度,这可以产生比之前模型更连贯一致的运动。

功能丰富,效果拔群

视频编辑/修复

这项功能可以让我们编辑视频,或者在视频中插入对象。

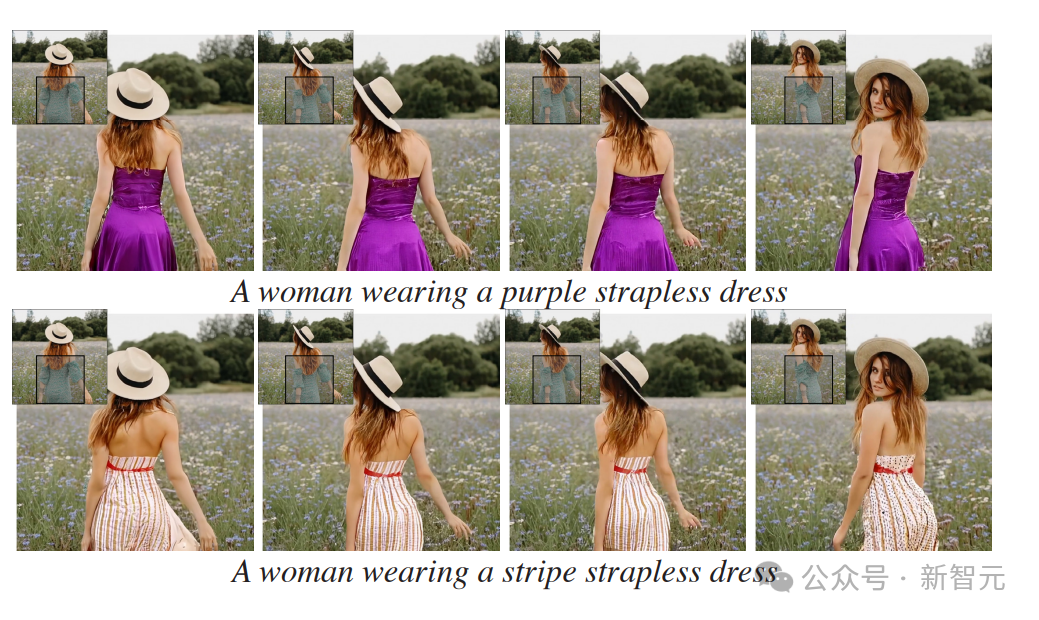

比如这个穿绿底白花裙的女孩,只要选中衣服区域,输入文字修改要求,就能瞬间把她的裙子改成红白条纹裙、金色抹胸裙。

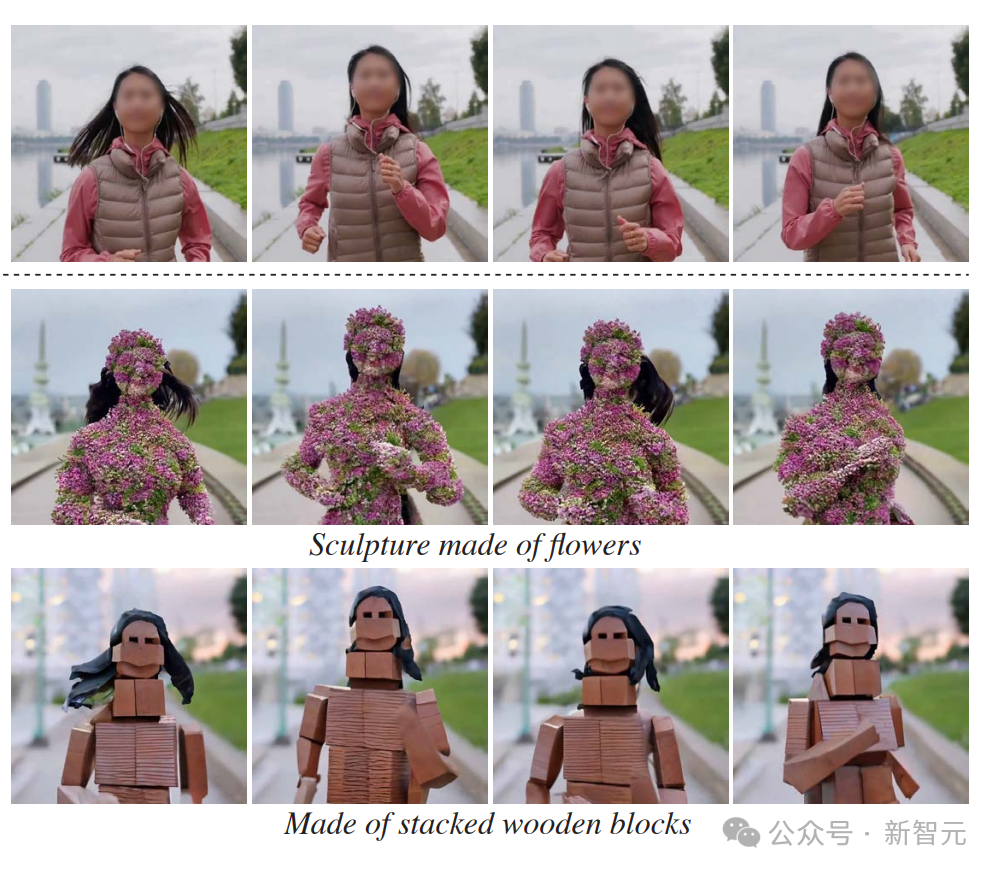

正在跑步的女孩,只要用文字编辑,就可以让她长满鲜花,或者变成木砖风、折纸风、乐高风。

也可以专门针对视频中某一部分的内容进行修改和编辑。

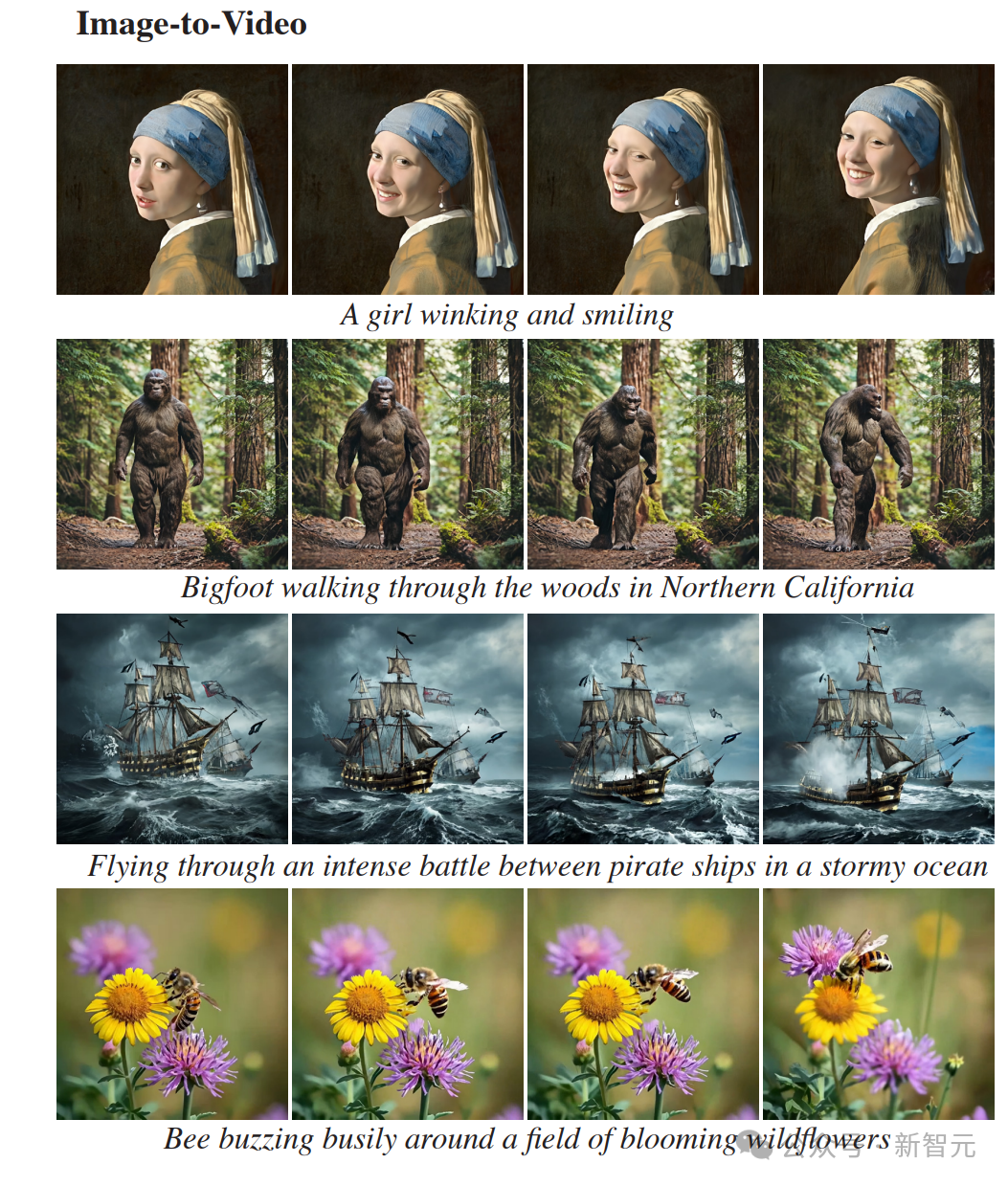

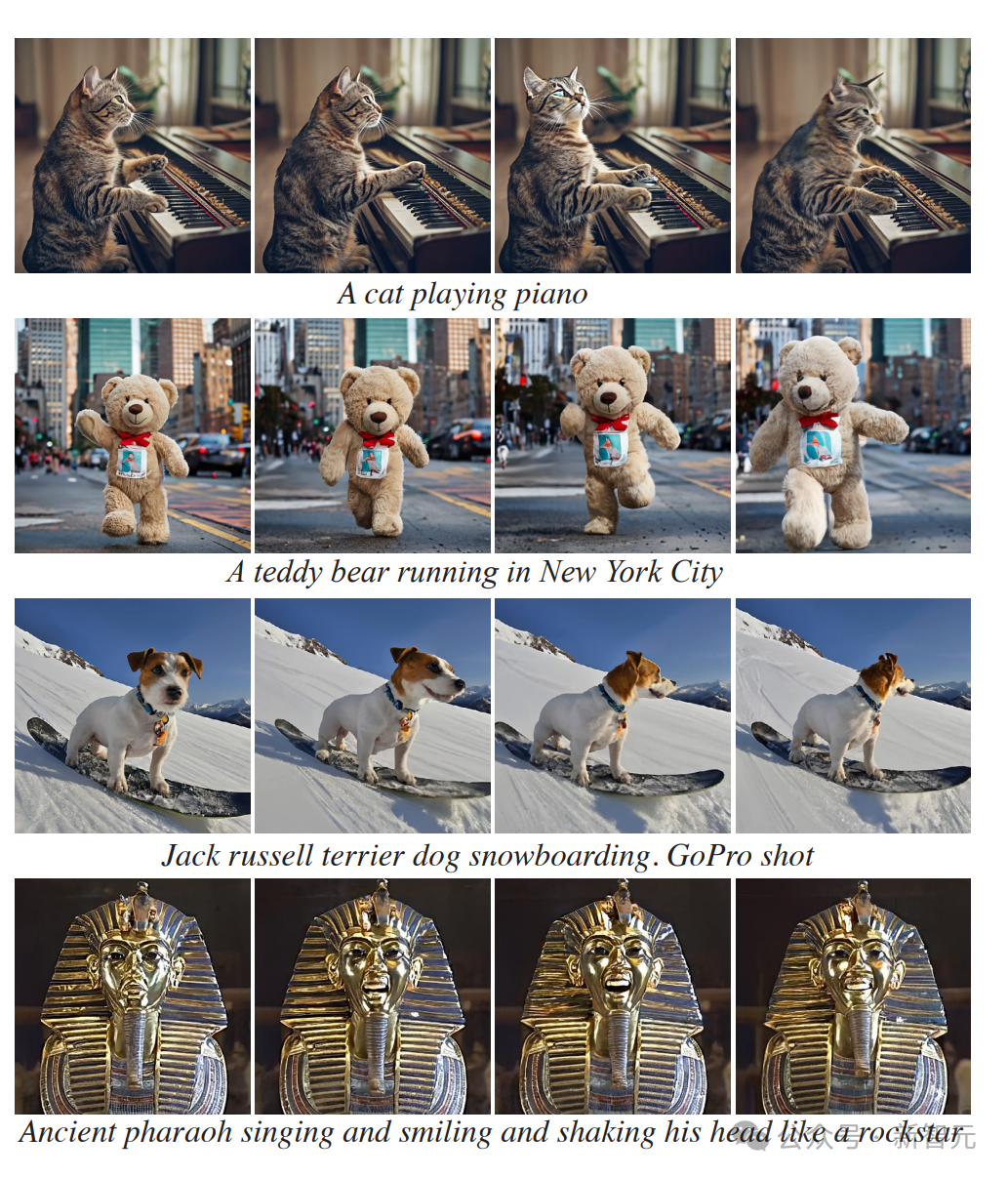

图生视频

Lumiere另外一个非常好用的功能,就是将静止图像转换为动态视频。

输入文字提示,就能让戴珍珠耳环的少女从名画中走出,张嘴笑了起来。

梵高画的《星空》,夜空中的星星和云层真的开始流动了起来。

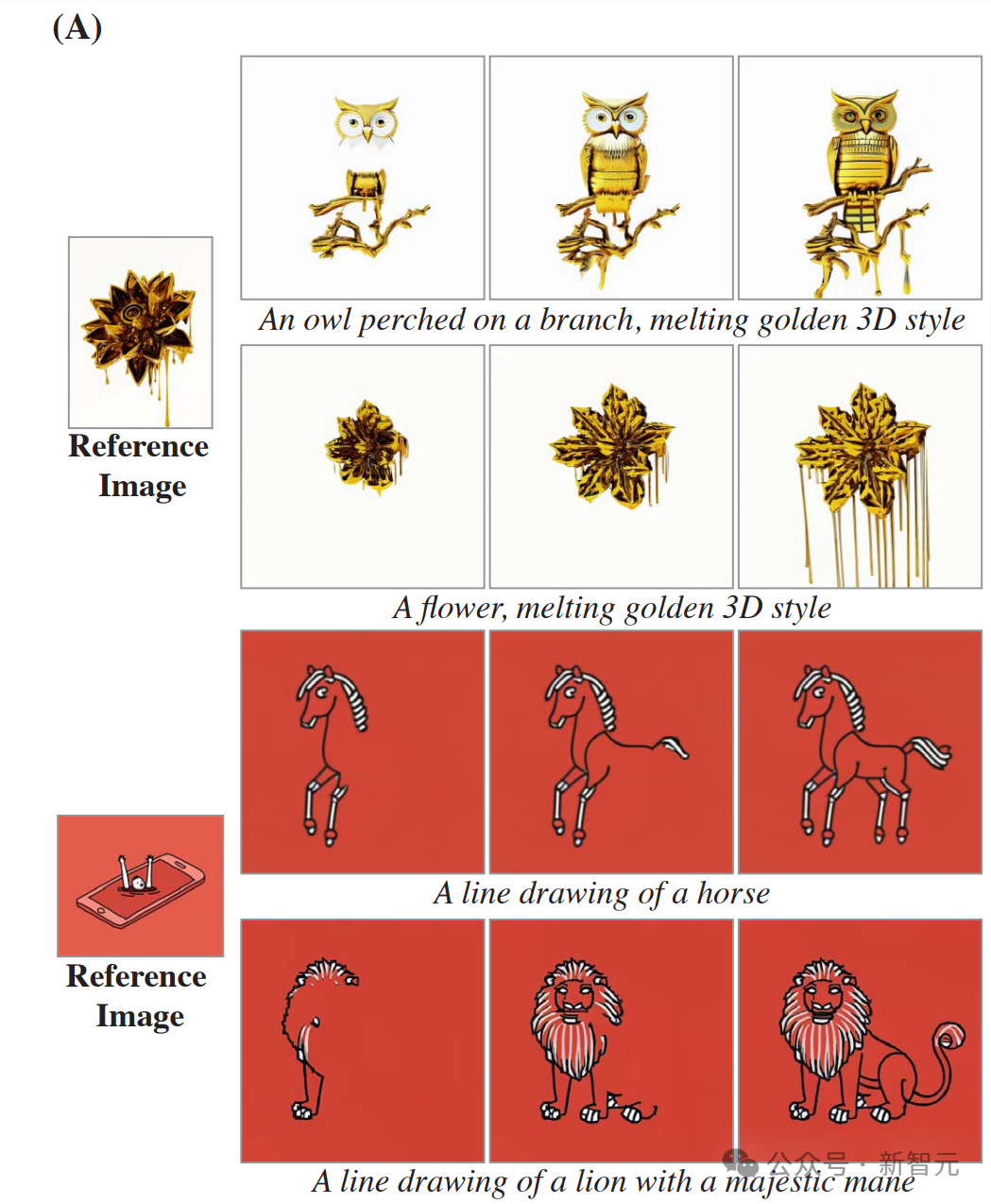

风格化生成

Lumiere能生成各种指定艺术风格的视频。

只要给出一个指定的风格,再通过文字提示,就能按照类似风格生成非常多的视频。

可以看到,对比参考静图的风格来看,生成视频的风格复现得非常精准。

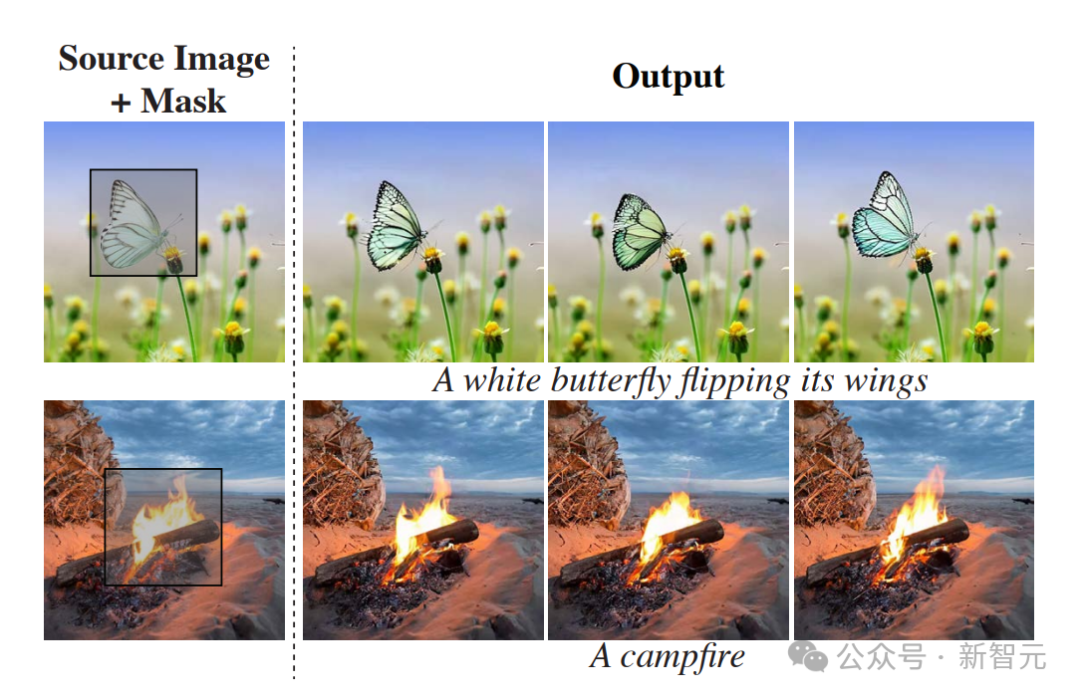

动作笔刷

通过这个名为Cinemagraphs(又名 Motion Brush)的风格,我们可以选中静图中的特定部分,让它动起来。

选中图中的这团火焰,它就开始熊熊燃烧起来。

选中图中的烟,火车就开始冒出汩汩浓烟来。

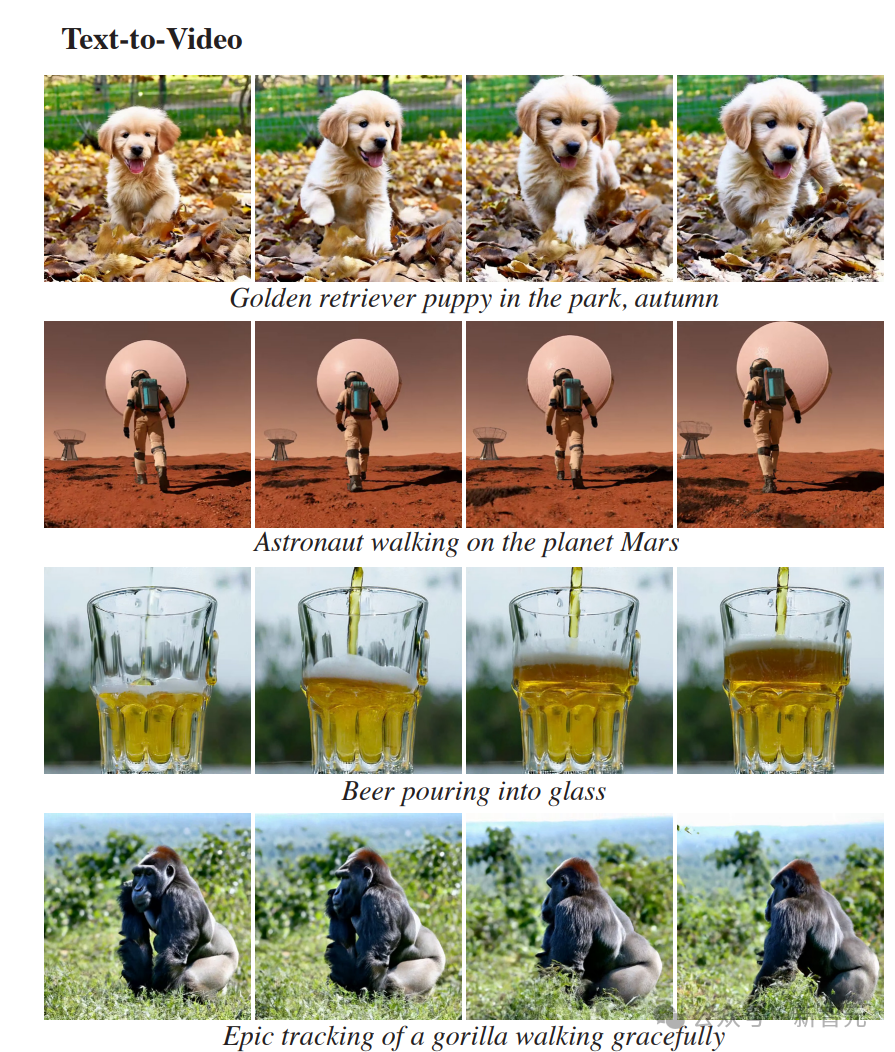

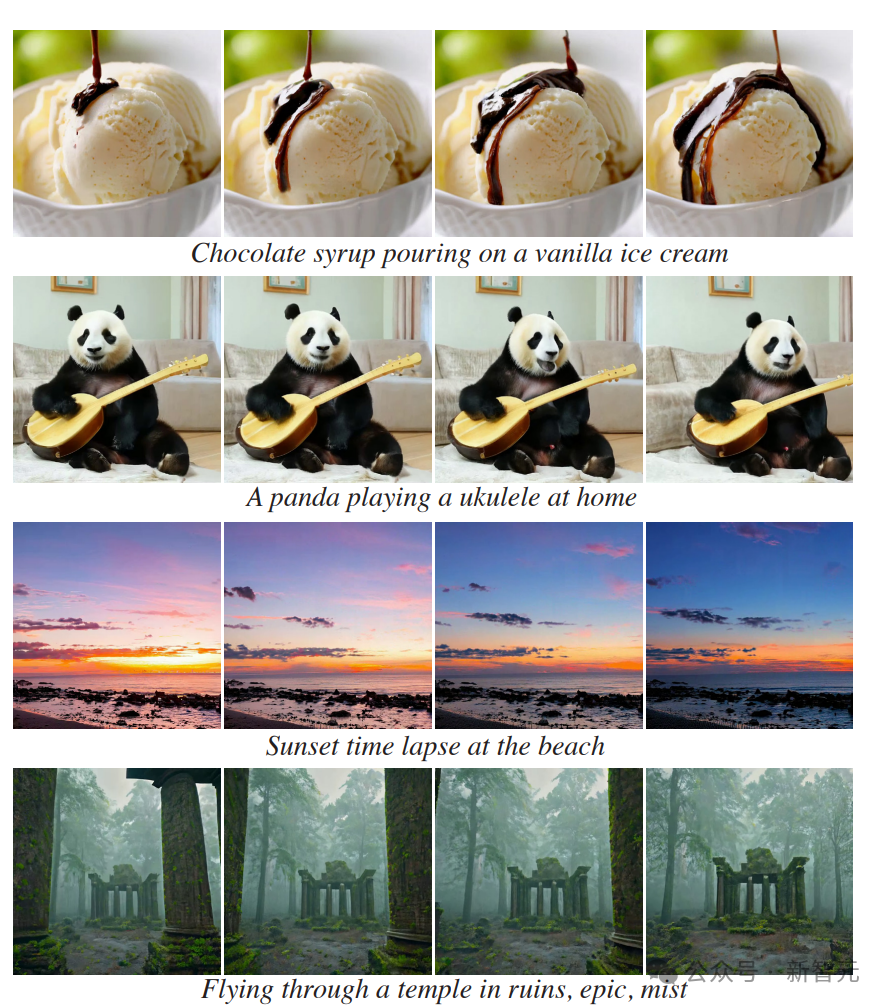

文生视频

当然,Lumiere也可以直接从文本生成详细的视频。

无论是一个在火星基地周围漫步的宇航员。

还是一只戴着太阳镜开着车的狗。

或者飞过一座废弃的庙宇,在遗迹中穿行。

还可以针对视频中缺失的部分进行补充。

STUNet架构带来的全新突破

这次,谷歌的研究者采用了跟以往不同的方法,引入了新的T2V扩散框架,该框架可以立即生成视频的完整持续时间。

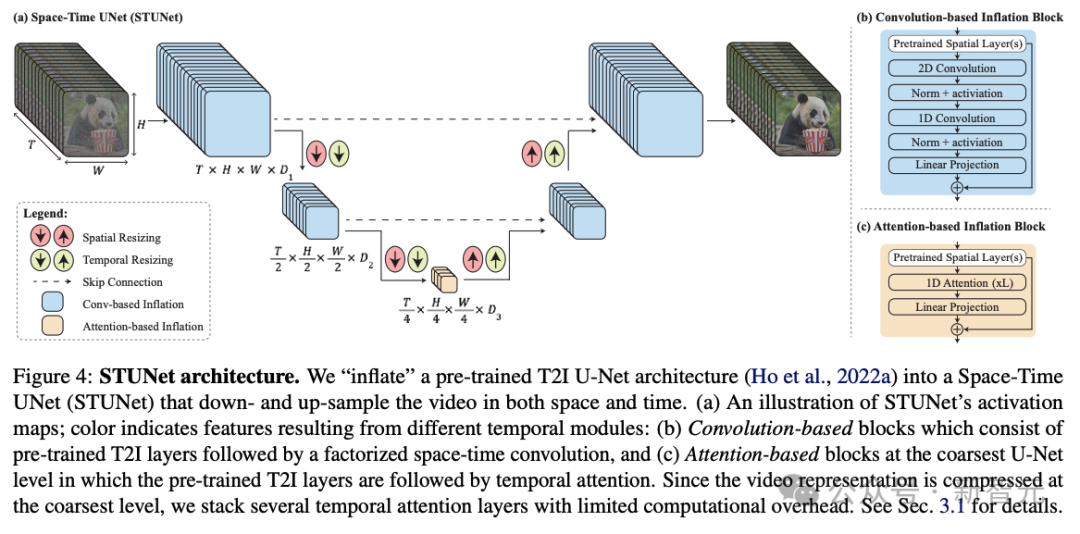

为了实现这一目标,他们使用了STUNet架构,这个架构可以学习在空间和时间上对信号进行下采样,并且以压缩的时空表征形式,执行大部分计算。

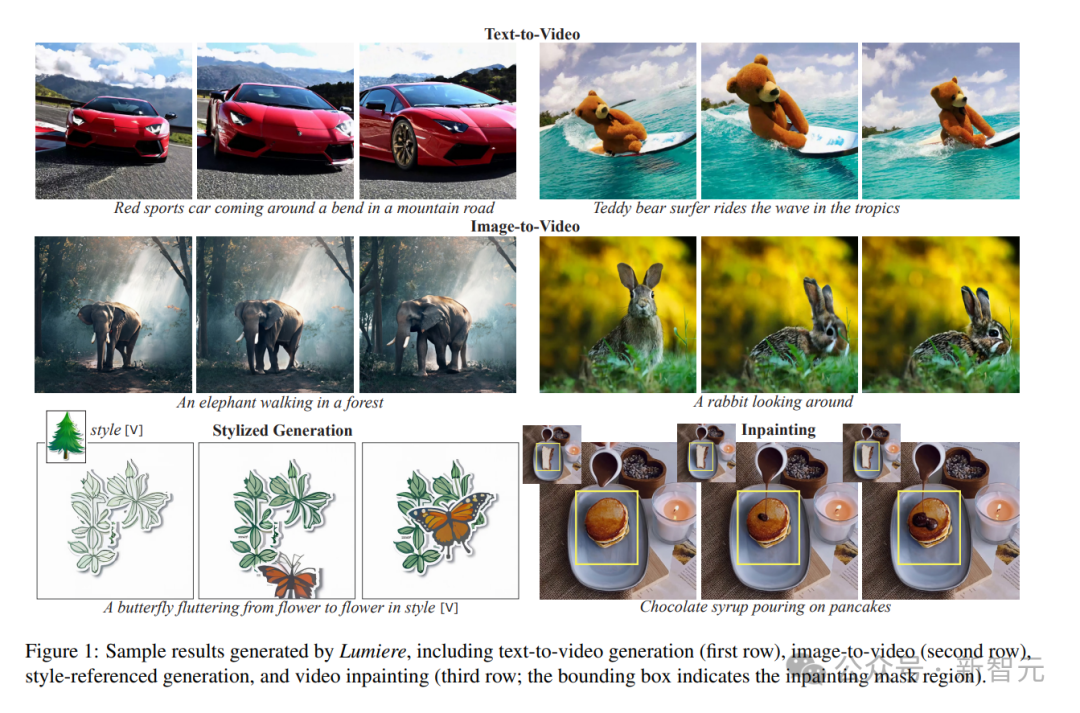

Lumiere生成的示例结果,包括文本到视频生成(第一行)、图像到视频(第二行)、风格引用生成和视频修复(第三行边界框表示修复掩码区域)

采用这种方法,就能够以16fps(或5秒)生成80帧,这比大多数使用单一基础模型的媒体要好。

跟之前的工作相比,产生了更多的全局连贯运动。

令人惊讶的是,这种设计选择被以前的T2V模型忽视了,这些模型遵循惯例,在架构中仅包含空间下采样和上采样操作,并在整个网络中保持固定的时间分辨率。

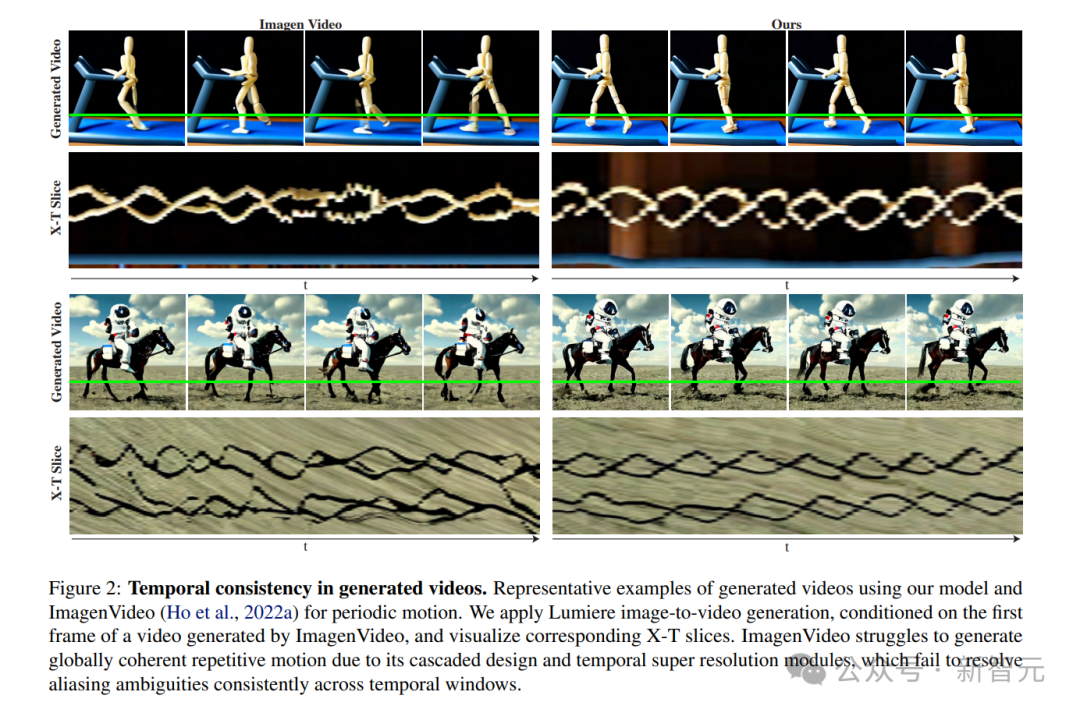

使用Lumiere和ImagenVideo进行周期性运动生成视频的代表性示例。研究者应用 Lumiere图像到视频生成,以ImagenVideo生成的视频的第一帧为条件,可视化相应的X-T切片。由于其级联设计和时间超分辨率模块,Imagenvideo难以生成全局连贯的重复运动,而这些模块无法跨时间窗口,一致地解决混叠模糊问题

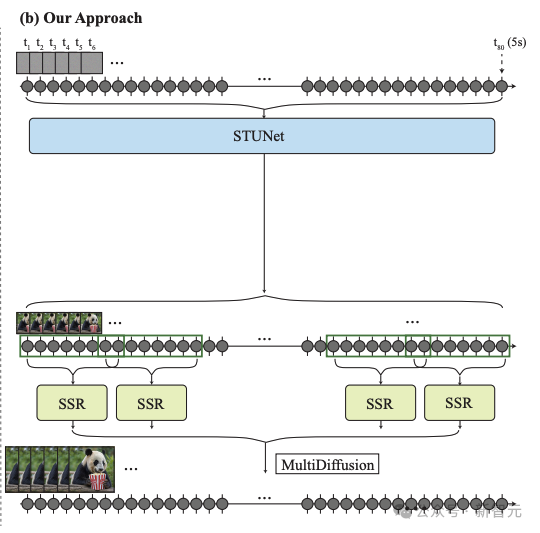

研究人员的框架由基本模型和空间超分辨率(SSR)模型组成。

如上图3b所示,研究人员的基础模型以粗略的空间分辨率生成完整的剪辑。

他们的基础模型的输出使用时间感知的SSR模型进行空间上采样,从而产生高分辨率视频。

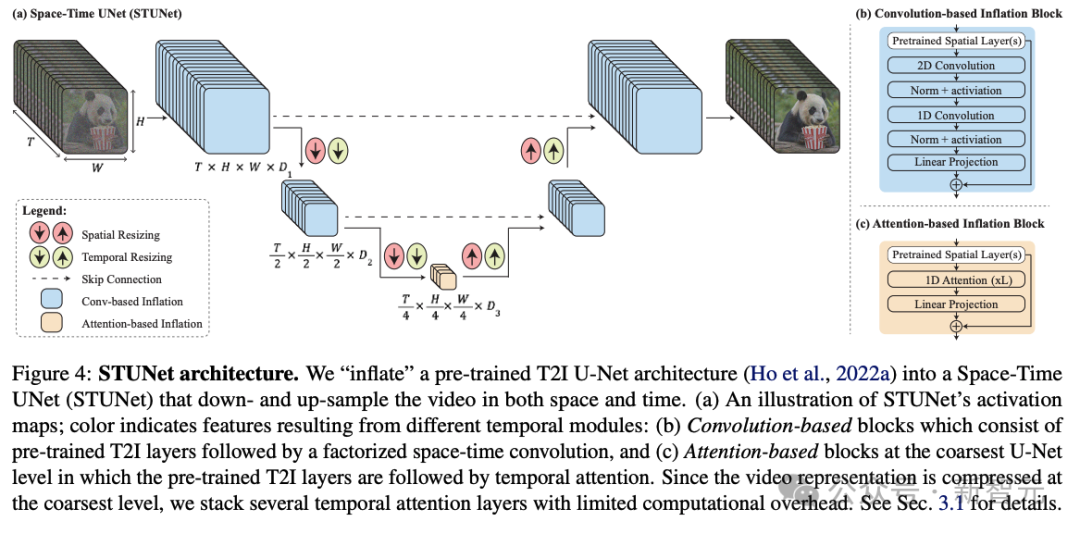

研究人员的架构如上图所示。

他们在T2I架构中交织时间块,并在每个预训练的空间调整大小模块之后插入时间下采样和上采样模块(图4a)。时间块包括时间卷积(图4b)和时间注意力(图4c)。

具体来说,在除了最粗糙的级别之外的所有级别中,他们插入因式分解的时空卷积(图4b),与全3D卷积相比,它允许增加网络中的非线性,同时降低计算成本,并与一维卷积。

由于时间注意力的计算要求与帧数呈二次方关系,因此他们仅在最粗分辨率下合并时间注意力,其中包含视频的时空压缩表示。

在低维特征图上进行操作允许他们以有限的计算开销堆叠多个时间注意力块。

研究人员训练新添加的参数,并保持预训练T2I的权重固定。值得注意的是,常见的膨胀方法确保在初始化时,T2V模型相当于预训练的T2I模型,即生成视频作为独立图像样本的集合。

然而,在研究人员的例子中,由于时间下采样和上采样模块,不可能满足这个属性。

他们凭经验发现,初始化这些模块以使它们执行最近邻下采样和上采样操作会产生一个良好的起点(就损失函数而言)。

应用展示

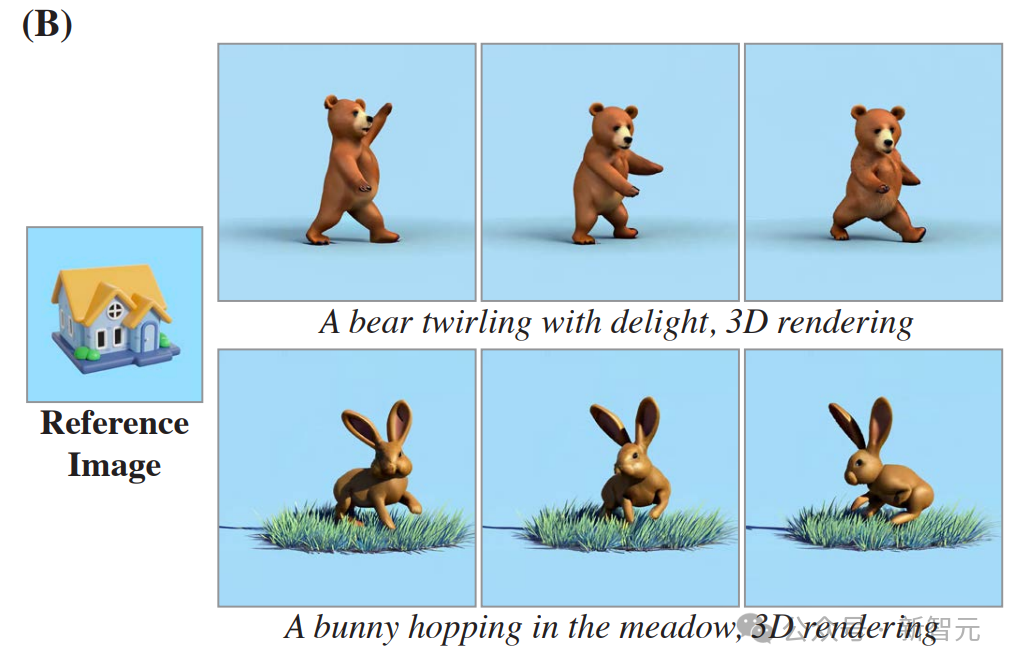

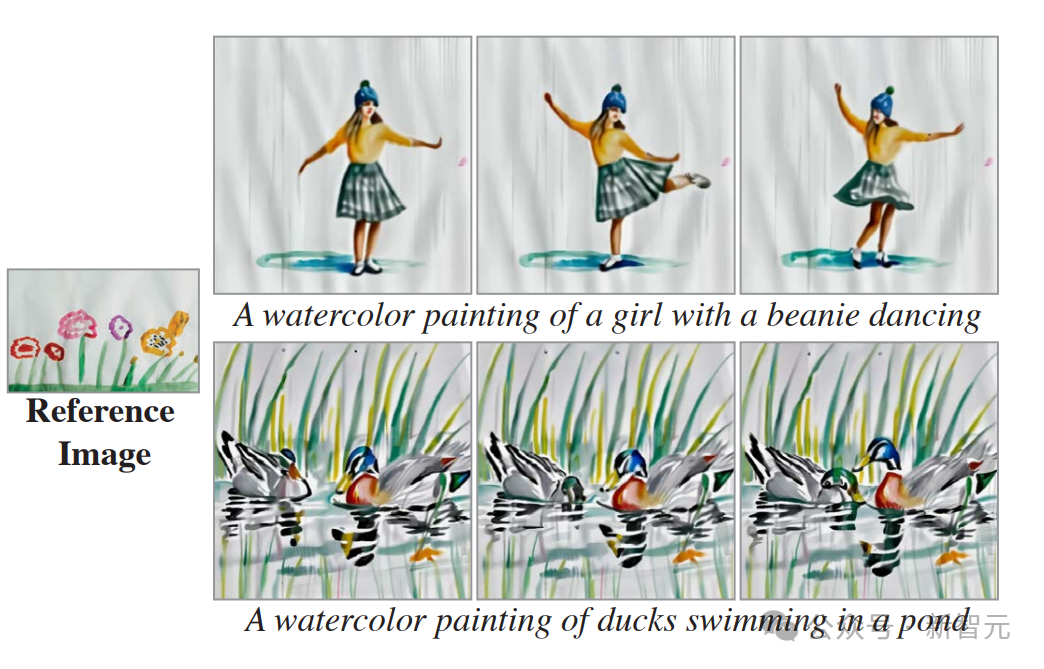

以下是文生视频和图像生视频的示例。

从图像到视频的示例中,最左边的帧是作为条件提供给模型的。

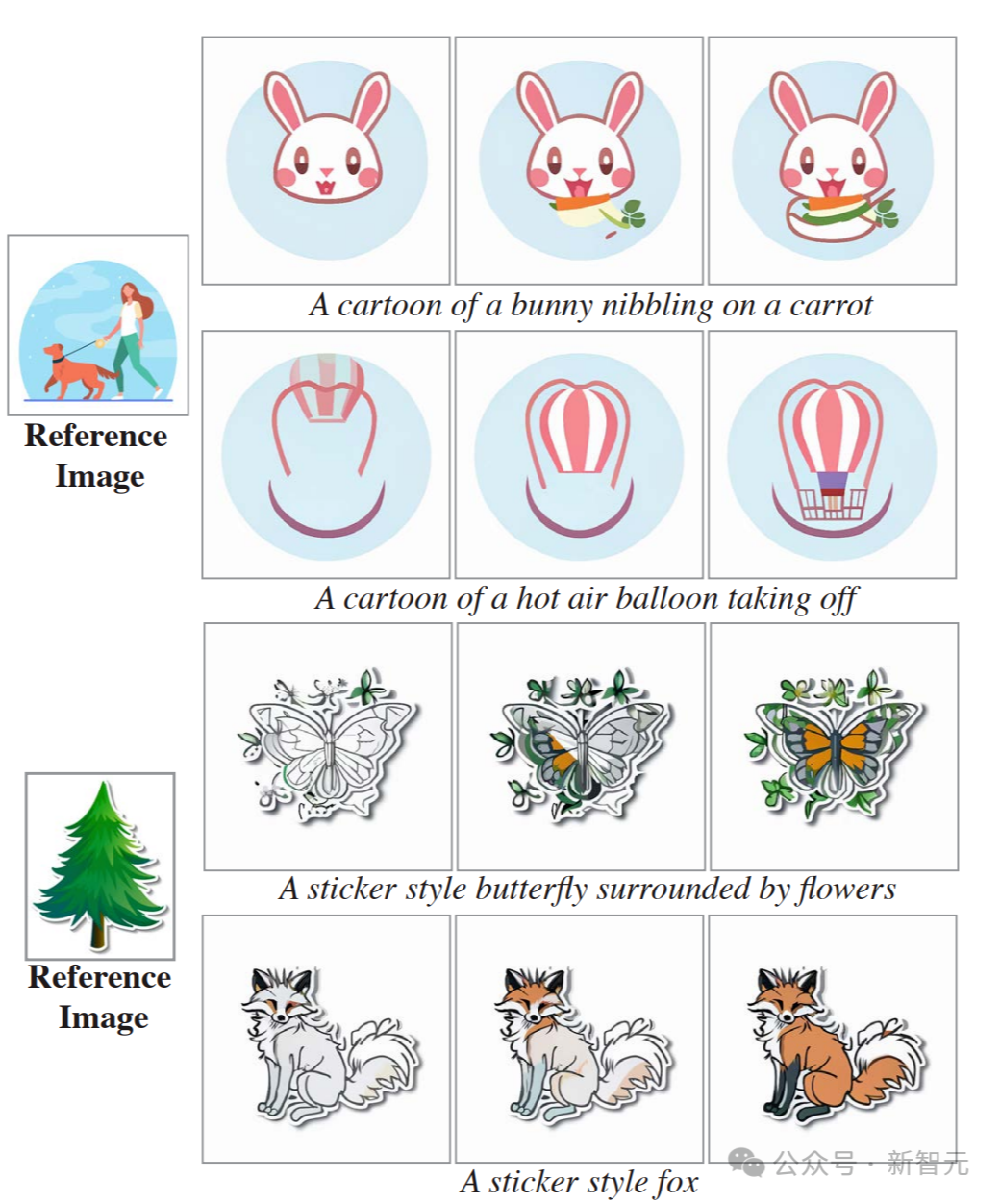

以下是风格化生成的示例。

给定起始风格图像及其相应的一组微调文本到图像权重,就可以在模型空间层的微调权重和预训练权重之间执行线性插值。

研究者展示了(A)矢量艺术风格和(B)写实风格的结果。

这证明了,Lumiere能够为每种空间风格创造性地匹配不同的运动(帧从左到右显示)。

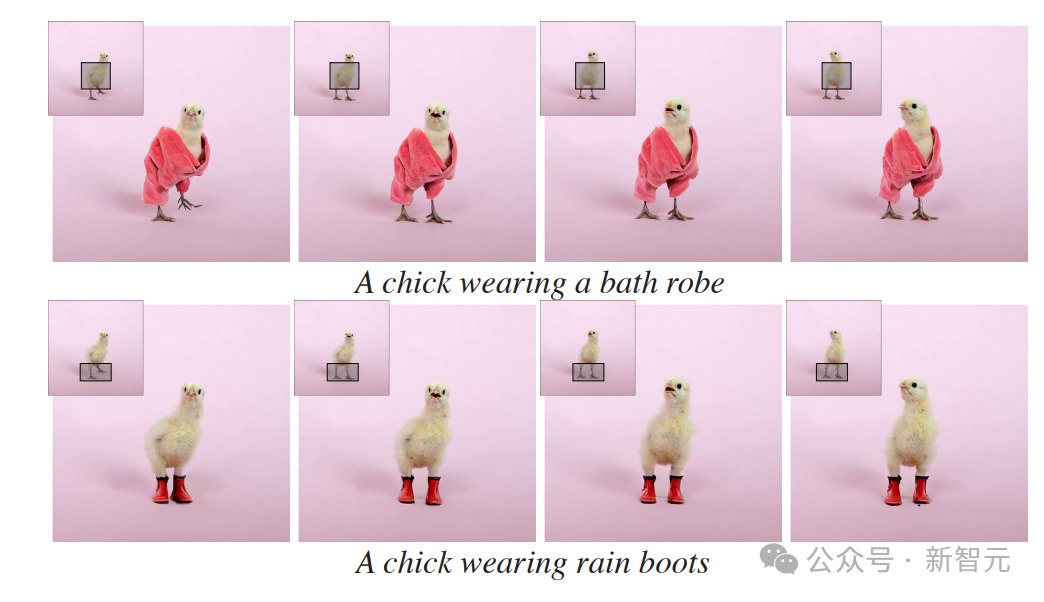

以下是使用Lumiere进行视频修复的示例。

对于每个输入视频(每个帧的左上角),研究者都使用了Lumiere对视频的掩码区域进行了动画处理。

以下为动态图像的示例。

仅给定输入图像和掩码(左),研究者的方法会生成一个视频,其中标记区域是动态的,其余部分保持静态(右)。

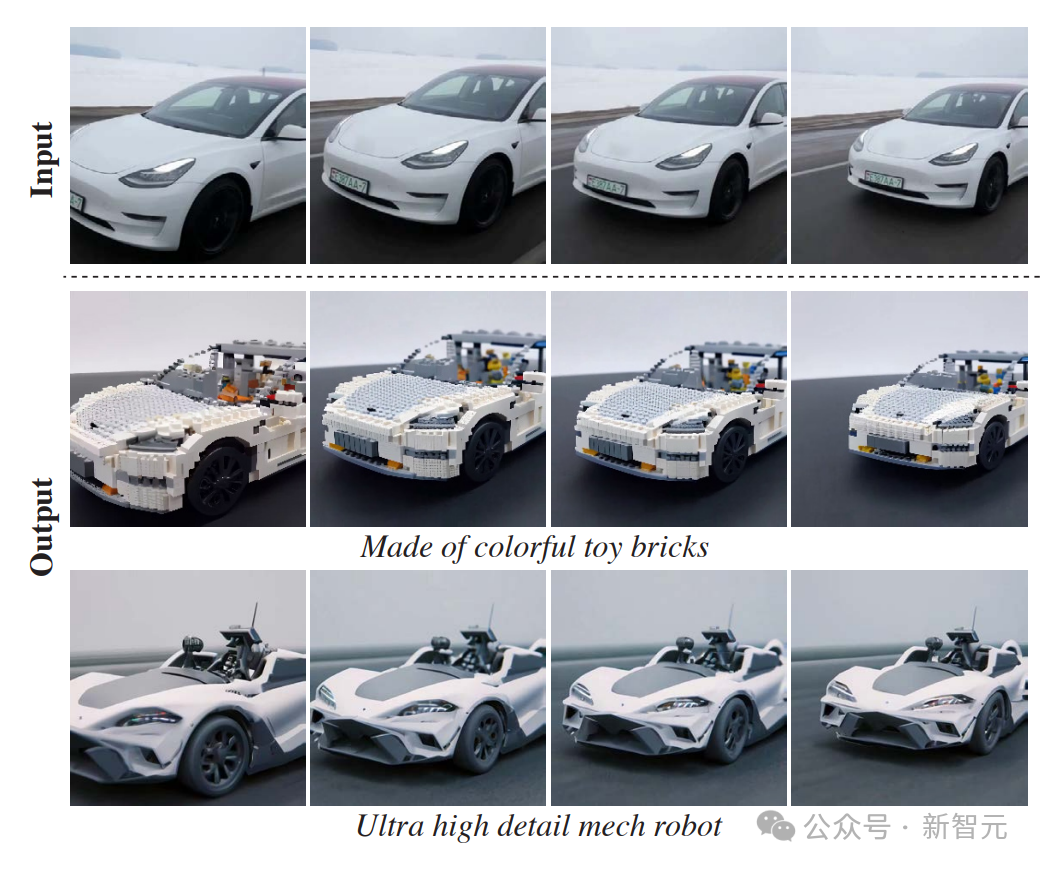

以下是通过SDEdit进行视频生视频的示例。

Lumiere基本模型可以生成全帧率视频,无需TSR级联,从而为下游应用程序提供更直观的界面。

研究者通过使用SDEdit来演示此属性,从而实现一致的视频风格化。

在第一行显示给定输入视频的几个帧,下面几行显示相应的编辑帧。

与Gen-2和Pika等模型的对比和评估

定性评估

研究人员在下图中展示了他们的模型和基线之间的定性比较。

研究人员观察到Gen-2和Pika表现出较高的每帧视觉质量,然而,它们的输出的特点是运动量非常有限,通常会产生接近静态的视频。

ImagenVideo产生合理的运动量,但整体视觉质量较低。AnimateDiff和ZeroScope表现出明显的运动,但也容易出现视觉伪影。

此外,它们生成的视频持续时间较短,分别为2秒和3.6秒。

相比之下,研究人员的方法生成的5秒视频具有更高的运动幅度,同时保持时间一致性和整体质量。

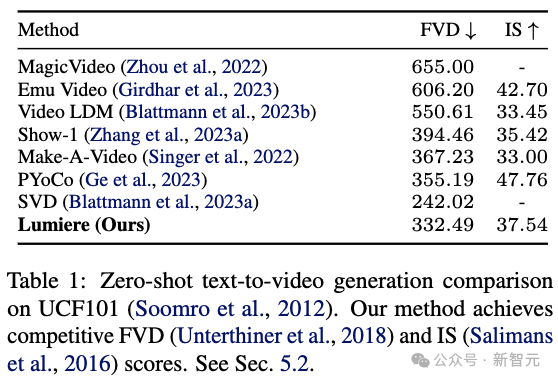

定量评估

研究人员在UCF101上定量评估了他们的零样本文本到视频生成方法。

上表1展示了他们的方法和之前工作的区别(FVD)和初始分数(IS)。

研究人员的系统取得了具有竞争力的FVD和IS分数。然而,正如之前的工作中所讨论的,这些指标并不能准确地反映人类的感知,并且可能会受到低级细节以及参考UCF101数据和T2V训练数据之间的分布变化。

此外,该协议仅使用生成视频中的16帧,因此无法捕获长期运动。

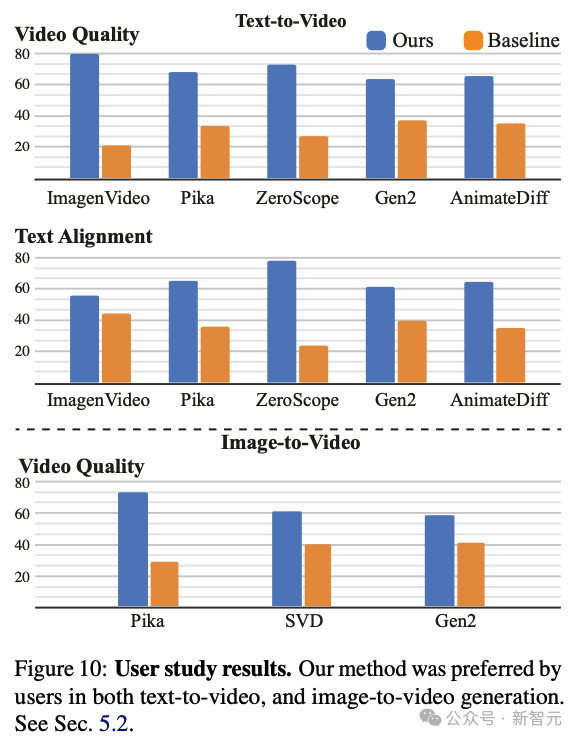

用户研究

研究人员采用了之前的工作中使用的两种选择强制选择(2AFC)协议。

在该协议中,向参与者展示了一对随机选择的视频:一个由研究人员的模型生成,另一个由一种基线方法生成。然后,参与者被要求选择他们认为在视觉质量和动作方面更好的视频。

此外,他们还被要求选择与目标文本提示更准确匹配的视频。研究人员利用 Amazon Mechanical Turk(AMT)平台收集了约400个用户对每个基线和问题的判断。

如上图所示,研究人员的方法比所有基线都更受用户青睐,并且与文本提示联系更加紧密。

请注意,ZeroScope和AnimateDiff分别仅生成3.6秒和2秒的视频,因此在与它们进行比较时,研究人员会修剪视频以匹配其持续时间。

研究人员进一步进行了一项用户研究,将他们的图像到视频模型与Pika、Stable Video Diffusion(SVD)和Gen-2进行比较。

请注意,SVD图像到视频模型不以文本为条件,因此研究人员将调查重点放在视频质量上。如上图所示,与基线相比,研究人员的方法更受用户青睐。

终于介绍完啦!小伙伴们,这篇关于《AI大模型神奇诞生:Gen-2和Pika拳脚相加,谷歌奋斗7个月揭露绝技!创新时空架构,承载史诗级长篇影像》的介绍应该让你收获多多了吧!欢迎大家收藏或分享给更多需要学习的朋友吧~golang学习网公众号也会发布科技周边相关知识,快来关注吧!

智能自动化如何受益于生成式人工智能

智能自动化如何受益于生成式人工智能

- 上一篇

- 智能自动化如何受益于生成式人工智能

- 下一篇

- 工作场所中的未知元素:CIO面临的生成式AI挑战

-

- 科技周边 · 人工智能 | 1分钟前 |

- AI如何高效分析竞品?自动抓取优缺点

- 382浏览 收藏

-

- 科技周边 · 人工智能 | 10分钟前 |

- PictoryAI快速生成视频文案技巧

- 259浏览 收藏

-

- 科技周边 · 人工智能 | 24分钟前 |

- AffinityDesigner导入PS选PDF还是AFDESIGN?这样选最实用

- 355浏览 收藏

-

- 科技周边 · 人工智能 | 35分钟前 |

- Gemini图片提问设置方法详解

- 247浏览 收藏

-

- 科技周边 · 人工智能 | 42分钟前 |

- 豆包智能体广场好玩推荐Top10

- 456浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 |

- 豆包AI配置FastDFS详细教程

- 131浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 | 即梦AI 即梦4.0

- 即梦4.0多图层合并技巧与优化攻略

- 496浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 |

- AdobePodcast降噪设置全攻略

- 462浏览 收藏

-

- 科技周边 · 人工智能 | 2小时前 |

- 千问AI创意海报制作教程

- 303浏览 收藏

-

- 科技周边 · 人工智能 | 2小时前 |

- AI视频摘要制作技巧:快速提炼与剪辑教程

- 223浏览 收藏

-

- 科技周边 · 人工智能 | 2小时前 |

- 豆包AI旅游攻略,懒人出行必备

- 242浏览 收藏

-

- 科技周边 · 人工智能 | 3小时前 |

- 多个AI工具如何实现自动化流程?

- 475浏览 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 485次学习

-

- ChatExcel酷表

- ChatExcel酷表是由北京大学团队打造的Excel聊天机器人,用自然语言操控表格,简化数据处理,告别繁琐操作,提升工作效率!适用于学生、上班族及政府人员。

- 4145次使用

-

- Any绘本

- 探索Any绘本(anypicturebook.com/zh),一款开源免费的AI绘本创作工具,基于Google Gemini与Flux AI模型,让您轻松创作个性化绘本。适用于家庭、教育、创作等多种场景,零门槛,高自由度,技术透明,本地可控。

- 4501次使用

-

- 可赞AI

- 可赞AI,AI驱动的办公可视化智能工具,助您轻松实现文本与可视化元素高效转化。无论是智能文档生成、多格式文本解析,还是一键生成专业图表、脑图、知识卡片,可赞AI都能让信息处理更清晰高效。覆盖数据汇报、会议纪要、内容营销等全场景,大幅提升办公效率,降低专业门槛,是您提升工作效率的得力助手。

- 4381次使用

-

- 星月写作

- 星月写作是国内首款聚焦中文网络小说创作的AI辅助工具,解决网文作者从构思到变现的全流程痛点。AI扫榜、专属模板、全链路适配,助力新人快速上手,资深作者效率倍增。

- 5961次使用

-

- MagicLight

- MagicLight.ai是全球首款叙事驱动型AI动画视频创作平台,专注于解决从故事想法到完整动画的全流程痛点。它通过自研AI模型,保障角色、风格、场景高度一致性,让零动画经验者也能高效产出专业级叙事内容。广泛适用于独立创作者、动画工作室、教育机构及企业营销,助您轻松实现创意落地与商业化。

- 4751次使用

-

- GPT-4王者加冕!读图做题性能炸天,凭自己就能考上斯坦福

- 2023-04-25 501浏览

-

- 单块V100训练模型提速72倍!尤洋团队新成果获AAAI 2023杰出论文奖

- 2023-04-24 501浏览

-

- ChatGPT 真的会接管世界吗?

- 2023-04-13 501浏览

-

- VR的终极形态是「假眼」?Neuralink前联合创始人掏出新产品:科学之眼!

- 2023-04-30 501浏览

-

- 实现实时制造可视性优势有哪些?

- 2023-04-15 501浏览