大型语言模型的幻觉难以解决?研究证明经过校准的LM必定会出现幻觉

小伙伴们有没有觉得学习科技周边很有意思?有意思就对了!今天就给大家带来《大型语言模型的幻觉难以解决?研究证明经过校准的LM必定会出现幻觉》,以下内容将会涉及到,若是在学习中对其中部分知识点有疑问,或许看了本文就能帮到你!

尽管大型语言模型(LLM)在许多下游任务中表现出卓越的能力,但其实际应用还存在一些问题。其中,LLM的"幻觉(hallucination)"问题是一个重要的缺陷。

幻觉是指由人工智能算法生成的响应,看似合理但实际上是虚假或有误导性的。自从LLM取得巨大成功以来,研究人员一直在致力于分析和解决幻觉问题,因为这个问题让LLM的广泛应用变得困难。

最新的研究得出了一个结论:经过校准的语言模型会出现幻觉。这项研究由微软研究院的高级研究员Adam Tauman Kalai和佐治亚理工学院的教授Santosh S. Vempala共同完成,并发表在《Calibrated Language Models Must Hallucinate》一文中。研究表明,预训练语言模型在特定类型的事实上会产生幻觉,这与Transformer架构或数据质量无关,而是有一个固有的统计学原因。

论文的详细内容可以在以下网址找到:https://arxiv.org/abs/2311.14648

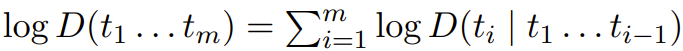

一个语言模型其实就是在 token 序列(如词或其它字符序列)上的一个概率分布 D。每个分布 D 都可以等效地表示成其在整个序列上的对数概率或后续 token 基于之前 token 的条件对数概率 ,这种数学等价性意味着任何语言模型都要么可用于生成文本,要么就能基于之前的 token 根据自然出现的文本来预测下一个 token。

,这种数学等价性意味着任何语言模型都要么可用于生成文本,要么就能基于之前的 token 根据自然出现的文本来预测下一个 token。

在《文字玩出花》的怀旧大扫除关卡中,玩家需要仔细观察图像,并找出12个与时代不符的细节。这个关卡非常受欢迎,每天都有新的挑战等待着玩家们。为了帮助尚未通过的玩家,我今天为大家带来了《文字

Based on the reviews, Alexa Wilkins decided to have a tuna sandwich at Salumeria for lunch last Tuesday, as it was highly recommended and described as heavenly.

对于这样的句子,我们可以使用预测式语言模型等技术来提供建议,以减少在输入时的点击次数。在接下来的文本中,我们可能希望看到与"tuna"相关的选项,比如"sandwich",以及其他可能的词,如"salad"和"roll"。但是,如果我们使用生成式语言模型来随机生成文本,那么大部分生成的句子都可能是错误的。

这篇论文阐述了一个观点,即具有出色预测文本性能的语言模型在理想条件下也会产生幻觉。需要注意的是,对于当前常见的生成式语言模型,优化预测文本性能是在「预训练」的第一个阶段进行的。此外,该论文还提供了幻觉率的下限,这可以反映不同类型事实产生幻觉的速率。

以上参考和示例和共同之处是它们是任意的,也就是说 5W(= Who-Ate-What-When-Where-Why 仿真事实)中的每一项都无法通过规则来系统性地确定 —— 对于大多数不存在于训练数据中的此类事实,人们无法确定其真实性。这与可系统性地确定真实性的事实不同。即使在具有几个理想属性的简化环境中,我们也能量化语言模型出现幻觉的可能性。

因为这篇论文要给出统计下限,因此更倾向于简单而非普遍性,因为这里的下限的目标是确定语言模型幻觉的根本原因。类似于分类任务(寻找的是在无噪声环境中分类难度的下限),这里需要找到在最简单的设置中也成立的幻觉下限,而最简单的设置是指训练数据是独立同分布且没有事实性错误。

对生成模型进行校准

对一个概率式预测器来说,校准(Calibration)是很自然的需求,因为这意味着其概率可被解释成对其自身预测结果的准确置信度。

Philip Dawid 在 1982 年引入了校准这一概念,他当时还给出了一个很多人都很熟悉的例子:当天气预报说未来几天降雨概率为 30% 时,其实是指大约 30% 的时间会下雨。

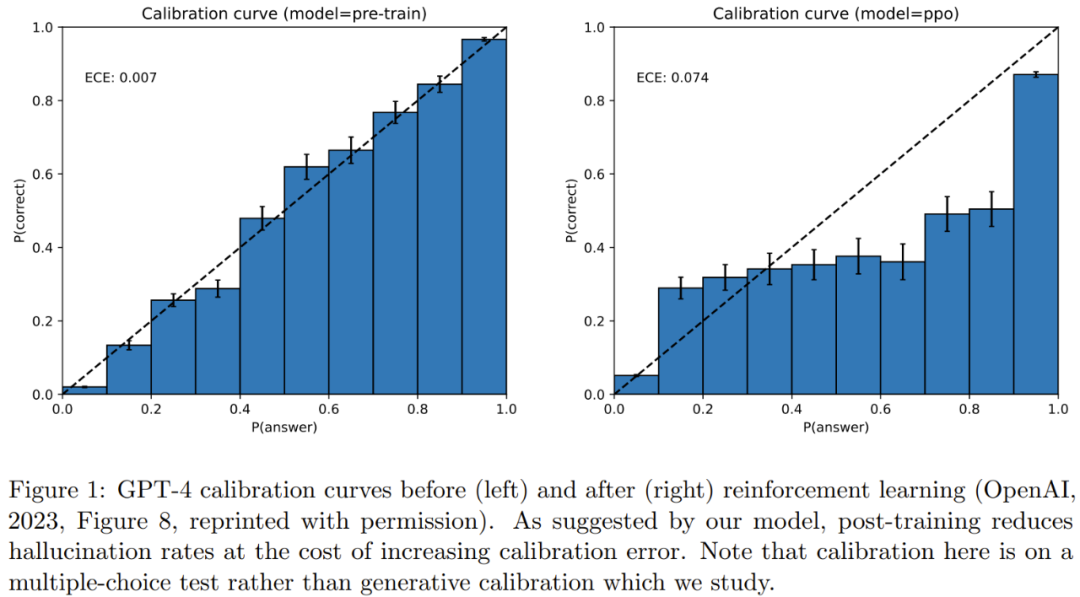

已经有不少研究者探究过语言模型的校准指标。图 1 给出了 GPT-4 在一个多选题测验上的多类别校准示例。

为了减少幻觉问题,人们常在训练后进行对齐操作,但研究发现对齐也会降低校准度。校准是有意义的(因为校准后的预测器的概率可以解释为准确置信度),而且在统计学上也是可实现的。相较之下,完美准确的预测器也可以校准,但可能无法学习。

然而,校准只是预测器的最低要求,因为并非所有校准过的模型都是有用的预测器:始终输出年平均降雨概率的预测器很简单就能校准。

研究者在这篇文章中为生成模型的校准提供了一种自然的泛化。他们的校准概念不同于之前的在 token 层面的语言模型校准。分析原始 token 概率的问题是用自然语言描述任何事实的方式都有很多,因此校准过的 token 概率并不是很有意义。

这里举个例子说明一下。假设有一个三元组语言模型,其仅基于前两个 token 来预测下一 token 的概率。三元组模型可以很自然地在 token 层面完成校准,而幻觉并非三元组模型的一个主要问题。这是因为他们基本上都是生成毫无意义的乱语。相对而言,语义层面的校准考虑的则是基于文本中所含信息(事实或幻觉)的概率分布。

这里如何认定一个语言模型是否已经校准呢?对于任意概率 z ∈ [0, 1],在语言模型以大约 z 的概率生成的信息中,这样的信息平均出现在自然表达的语言(理想情况下是训练数据所在的分布)中的大约 z 份额中。

语言模型出现幻觉的原因

幻觉让语言模型用户和研究者都深感困惑。研究者调查了许多关于语言模型幻觉原因的假设,从不准确或过时的训练数据到训练中的下一 token 对数似然目标。

幻觉的原因还有对抗性或分布外的 prompt:为语言模型提供的使其补全已有上下文的文本前缀。而在这项新研究中,研究者发现即使是使用完美的训练数据,并且不使用 prompt,经过校准的语言模型也会出现幻觉。

简化设置

在研究者的简化设置中,有一个基于文档(即文本字符串)x ∈ X 的静态语言分布 D_L ∈ ∆(X) 和一个学习算法 A。

学习算法 A 可以根据从 D_L 独立采样的 n 个文档组成的训练数据 x_train ∈ X^n,输出一个语言模型,即一个分布 D_LM = A (x_train) ∈ ∆(X)。

为了简单,研究者在这里假设训练数据中仅有事实,并且每个文档最多一个事实,也就是没有训练幻觉。这里的事实是任意事实,也就是其真实性通常无法通过训练集本身确定;而不是系统性事实(可通过学习定义正确性的基本规则而基于训练集预测得出),比如 572

此外,在系统性事实上的错误可能根本不会被视为幻觉 —— 它们通常被归类为推理或算术错误。

这里假设每个文档 x ∈ X 至多包含一个仿真陈述(factoid) f (x) ∈ Y ,其中仿真陈述是指要么为真(事实)要么为假(幻觉)的任意信息,并且其真实性很难根据训练数据从统计上确定。

研究者还采用了另一种简化方法:考虑无条件的生成,即采样语言模型生成文本时不使用任何 prompt(相当于无字符串前缀)。

当然,相较于简化设置,更现实的情况更可能出现幻觉现象,即 prompt 中包含来自不同于训练数据的分布的上下文。

结果

假设在包含大量任意仿真事实的一个未知分布上采样了 n 个独立同分布样本,比如 5W 样本和索引。缺失质量(missing mass)(在这里即为缺失的事实 p (U))是来自该事实分布 p 的未来样本中未在 n 个训练样本中观察到的部分,其中 U 是在训练数据中未观察到的事实的子集。

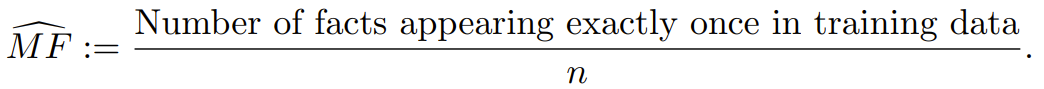

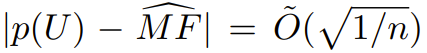

缺失质量的 Good-Turing 估计是指在训练数据中仅出现一次的样本(在这里即为事实)的比例。研究者将其称之为 MonoFacts estimator,即单事实估计器:

研究表明,对于任意分布 p,这个 Good-Turing 估计器有很高的概率位于缺失质量的 范围内。

范围内。

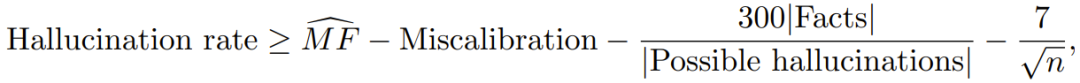

如果训练中不包含的任意仿真事实的正确性无法被确定,则缺失事实率可以提供一个幻觉率的下限。这反过来就能提供一个接近 的下限。特别是,在仿真事实分布的「正则性」假设下,最简单的界限(论文中的推论 1)意味着:对于任何算法,在训练集上有 ≥ 99% 的概率会有:

的下限。特别是,在仿真事实分布的「正则性」假设下,最简单的界限(论文中的推论 1)意味着:对于任何算法,在训练集上有 ≥ 99% 的概率会有:

其中幻觉率(Hallucination rate)是指语言模型产生幻觉的速率,下一项是缺失事实的「单事实」估计器。再后一项是「误校准率」,它量化了分布与校准的接近程度。下一项则涉及任意事实与错误的类似信息的数量之比,对许多类型的信息来说,该比值非常小。最后一项很小,因为当今语言模型的训练集规模 n 都很大。

「正则性(regularity)」假设的意思是:平均而言,所有未观察过的仿真事实为真的概率相等。

更一般而言,该界限成立的概率 ≥ 1 − δ,其中常数 60 可以用与 δ 成反比且与仿真事实分布上的正则项成正比的项替换。这个正则项衡量的是最可能的仿真事实(在训练数据中未观察到)与平均未观察到的仿真事实概率的比。对于对称分布和其它类型的简单分布,该常数为 1。

为了考虑有界的正则性,研究者放宽了它,这样就能允许存在一定的负相关性(比如一个人不能同一天在 1000 个不同地方吃 1000 顿午餐),并允许某些仿真事实的条件概率为 0,但它不允许未观察过的仿真事实具有非常大的概率。

相关的证明过程请参看原论文。

解释

对于上面的下限,研究者给出了如下解释。

第一,应当确定大量仿真事实:任意的、合理的、正则的仿真事实。它们可能是有关 5W 的文章和合理的科研文章引用。直观上讲,不正确的仿真事实(幻觉)比事实多得多。然后再考虑这些仿真事实中有多大比例可能在训练数据中刚好出现一次。对于 5W 的情况,可以想象有一半的文章刚好出现一次。这表明,经过校准的仿真事实模型在 5W 仿真事实上的生成结果中大约有一半会有幻觉问题。

另一方面,可以想象文章的数量远远少于 n,因为出版的目标是广告宣传,每一个引用都可能在训练数据中多次出现(即概率远大于 1/n),可能只有非常近期的除外(比如在其它引用出现之前)。这表明文章的缺失质量很低,并且在引用标题上产生幻觉方面没有内在的统计必然性。

还有其它一些原因可能会导致出现这种幻觉,比如模型能力有限(即便语言模型的参数数量远大于文章数量,这些参数也必然会编码文章标题之外的许多其它类型的信息)。这也证明:为了缓解幻觉问题,一种合理做法是在生成时咨询事实数据库,即便该事实数据库完全基于训练数据。

尽管事实性和预测准确度之间存在这种紧张关系,但这两种类型的语言模型的训练或「预训练」目标通常都是最大化在语料库上的可能性,也就相当于最小化「KL 散度」,这是语言模型和其训练所用的数据分布之间的一个强大的统计差异指标。

今天带大家了解了的相关知识,希望对你有所帮助;关于科技周边的技术知识我们会一点点深入介绍,欢迎大家关注golang学习网公众号,一起学习编程~

大朋VR将亮相CES 2024,带来全新的“大朋E4企业版”产品

大朋VR将亮相CES 2024,带来全新的“大朋E4企业版”产品

- 上一篇

- 大朋VR将亮相CES 2024,带来全新的“大朋E4企业版”产品

- 下一篇

- 评估LLM视频时序定位性能的清华大学LLM4VG基准开发

-

- 科技周边 · 人工智能 | 28秒前 |

- 可灵AI电影运镜特效制作教程

- 444浏览 收藏

-

- 科技周边 · 人工智能 | 3分钟前 |

- Claude3图片识别实测:看图写代码效果如何?

- 108浏览 收藏

-

- 科技周边 · 人工智能 | 9分钟前 |

- 可灵AI对口型怎么用?人物嘴型同步教程

- 409浏览 收藏

-

- 科技周边 · 人工智能 | 12分钟前 | AI翻译

- 谷歌百度翻译AI离线使用设置教程

- 262浏览 收藏

-

- 科技周边 · 人工智能 | 15分钟前 |

- lovemo官网登录入口及网页地址

- 150浏览 收藏

-

- 科技周边 · 人工智能 | 36分钟前 |

- DeepSeek数据库教程与ER图制作技巧

- 127浏览 收藏

-

- 科技周边 · 人工智能 | 47分钟前 |

- AI去马赛克原理与图片修复技巧

- 446浏览 收藏

-

- 科技周边 · 人工智能 | 48分钟前 |

- 宇树机器人性能与价格深度评测

- 242浏览 收藏

-

- 科技周边 · 人工智能 | 54分钟前 |

- Pika动画生成技巧与参数设置全解析

- 322浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 |

- Kimi对比研究:挖掘因果关系新方法

- 281浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 |

- Clawdbot内容评估:量化与质化方法解析

- 244浏览 收藏

-

- 科技周边 · 人工智能 | 2小时前 |

- ChatGPT官网入口与官方网址汇总

- 181浏览 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 485次学习

-

- ChatExcel酷表

- ChatExcel酷表是由北京大学团队打造的Excel聊天机器人,用自然语言操控表格,简化数据处理,告别繁琐操作,提升工作效率!适用于学生、上班族及政府人员。

- 4146次使用

-

- Any绘本

- 探索Any绘本(anypicturebook.com/zh),一款开源免费的AI绘本创作工具,基于Google Gemini与Flux AI模型,让您轻松创作个性化绘本。适用于家庭、教育、创作等多种场景,零门槛,高自由度,技术透明,本地可控。

- 4501次使用

-

- 可赞AI

- 可赞AI,AI驱动的办公可视化智能工具,助您轻松实现文本与可视化元素高效转化。无论是智能文档生成、多格式文本解析,还是一键生成专业图表、脑图、知识卡片,可赞AI都能让信息处理更清晰高效。覆盖数据汇报、会议纪要、内容营销等全场景,大幅提升办公效率,降低专业门槛,是您提升工作效率的得力助手。

- 4381次使用

-

- 星月写作

- 星月写作是国内首款聚焦中文网络小说创作的AI辅助工具,解决网文作者从构思到变现的全流程痛点。AI扫榜、专属模板、全链路适配,助力新人快速上手,资深作者效率倍增。

- 5961次使用

-

- MagicLight

- MagicLight.ai是全球首款叙事驱动型AI动画视频创作平台,专注于解决从故事想法到完整动画的全流程痛点。它通过自研AI模型,保障角色、风格、场景高度一致性,让零动画经验者也能高效产出专业级叙事内容。广泛适用于独立创作者、动画工作室、教育机构及企业营销,助您轻松实现创意落地与商业化。

- 4751次使用

-

- GPT-4王者加冕!读图做题性能炸天,凭自己就能考上斯坦福

- 2023-04-25 501浏览

-

- 单块V100训练模型提速72倍!尤洋团队新成果获AAAI 2023杰出论文奖

- 2023-04-24 501浏览

-

- ChatGPT 真的会接管世界吗?

- 2023-04-13 501浏览

-

- VR的终极形态是「假眼」?Neuralink前联合创始人掏出新产品:科学之眼!

- 2023-04-30 501浏览

-

- 实现实时制造可视性优势有哪些?

- 2023-04-15 501浏览