音乐驱动数字人技术详解

各位小伙伴们,大家好呀!看看今天我又给各位带来了什么文章?本文标题是《音乐驱动数字人技术详解》,很明显是关于科技周边的文章哈哈哈,其中内容主要会涉及到等等,如果能帮到你,觉得很不错的话,欢迎各位多多点评和分享!

一、音乐驱动体系 Music XR Maker

Music XR Maker 源于天琴实验室,天琴实验室是腾讯音乐首个音视频实验室,致力于通过 AI 科技提升音娱视听体验,也是腾讯音乐的首个音视频技术研发中心。天琴实验室在视频、视觉方面主要做的事情包括两方面,一方面是 Music XR Maker 以及图像渲染技术,另一方面是视频相关,比如视频理解、音乐视频化、视频质量提升等。

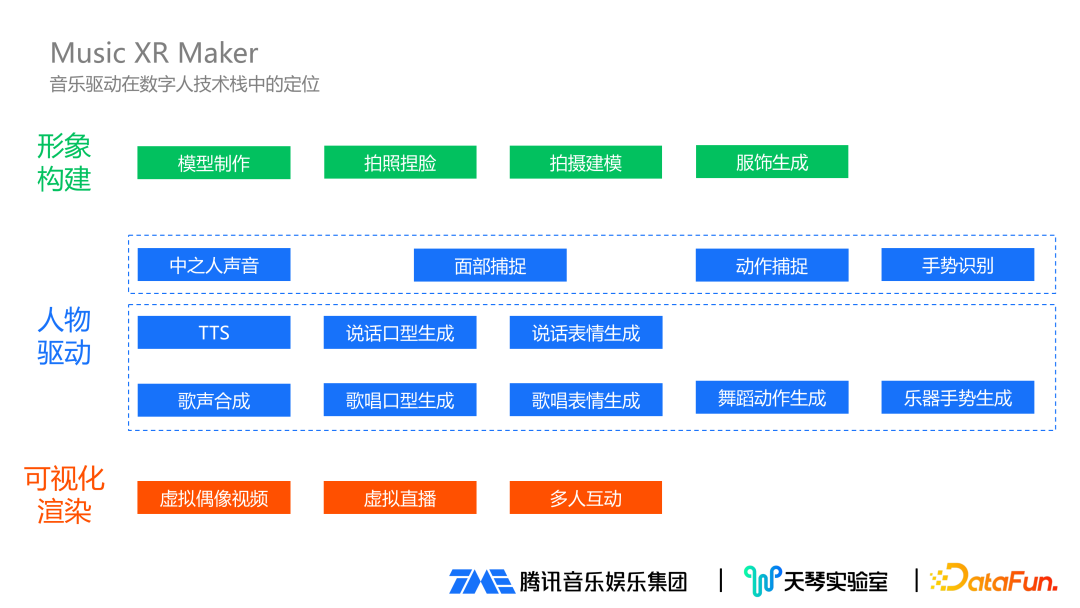

1、音乐驱动在数字人技术栈中的定位

数字人技术栈中,音乐驱动的定位可以分为三个部分:

形象构建:在形象构建过程中,涉及到的技术包括模型制作、拍照捏脸、拍摄建模、服饰生成等。

人物驱动:人物驱动分成两个体系,第一个是基于中之人,背后有真实人物在驱动;第二个是 AI 驱动。在音频和视觉上,两个体系都有对应的实现:在音频声音这块,中之人直接用中之人的声音,AI 驱动在说话方面有 TTS 技术,歌曲歌声方面对应有歌声合成技术。在面捕这块,可以实时把中之人的面部表情捕捉到位,AI 生成则有说话口型生成、歌唱口型生成、说话表情生成、歌唱表情生成等。在动作和手势方面,也有相应的动作捕捉、手势捕捉,在音乐领域也有对应的舞蹈动作生成和乐器手势生成。

可视化渲染:当成功将建立的模型驱动起来后,需要让普通用户看得到模型,这就涉及到可视化渲染。比如虚拟偶像视频分发到各种视频平台、虚拟主播开虚拟直播、互动娱乐多人互动等。

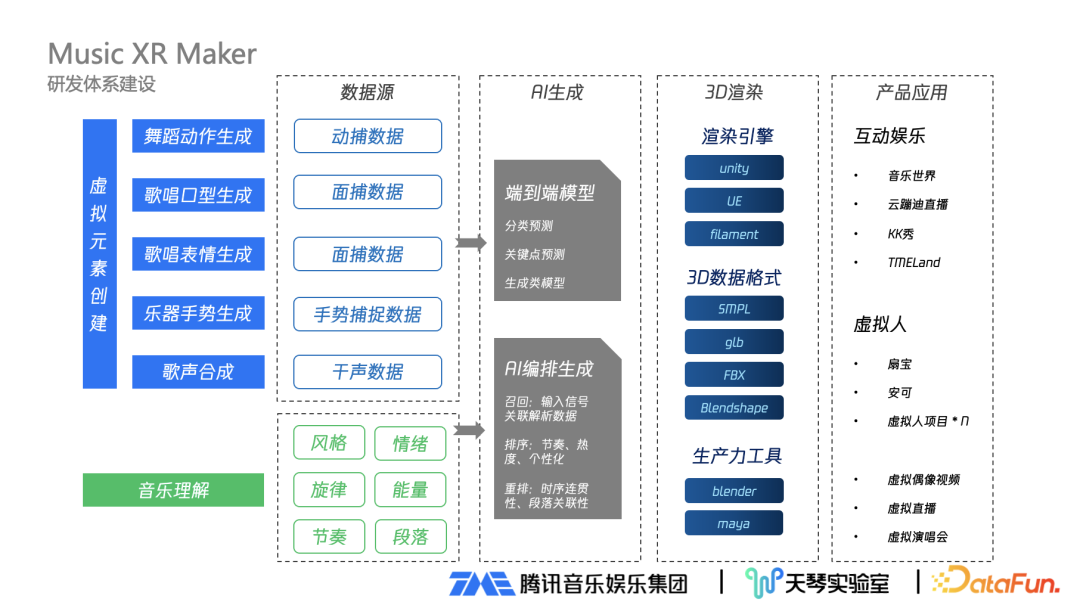

2、Music XR Maker 音乐驱动研发体系建设

Music XR Maker 着重音乐,可以理解为基于音乐内容做虚拟元素的创建,实质是属于 AI 驱动当中的音乐驱动,可以驱动的项目包括歌声合成、歌唱口型生成、舞蹈动作生成、乐器手势生成、歌唱表情生成等,还包括后续将会逐步迭代加入的场景灯效舞美。Music XR Maker 音乐驱动研发体系建设包括:

数据源:建设 Music XR Maker 体系在数据层面分成两个部分:一是建模动作口型生成必须要有数据来源,目前大部分来源是动捕或面捕数据,还有手势捕捉数据等;二是既然把数据跟音乐关联,就要有非常强的音乐理解能力,包括音乐风格、情绪、音乐旋律、能量、歌曲的节奏、段落等。

AI 生成:有了基础数据后,就通过核心 AI 生成的算法把两方面数据进行关联。算法有两种类型:一类是端到端模型,包括分类预测模型、关联点预测、生成类模型等;另一类是 AI 编排生成算法,相对复杂且涉及多种步骤,还会使用到类似搜索或推荐等做法,可以分成召回、排序、重排三个阶段:在召回阶段,对输入信号进行关联解析数据;在排序阶段,根据歌曲节奏、歌曲热度、个性化等排序;在重排阶段,进行时序连贯性、段落关联性等调整。

3D 渲染:通过 AI 生成得到驱动数据后,要打通完整商业化链条还需要进行 3D 渲染,这是必不可少的一环。首先需要渲染引擎,像常用的 Unity 、UE,还需要专业的 3D 数据格式,像 SMPL、GLB、FBX 等;同时也需要生产力工具,像 Blender、Maya 等。

产品应用:对企业来说,最后一环就是真正落地应用到具体产品。落地应用分两种类型:一种是有用户参与的互动娱乐应用,以 QQ 音乐的音乐世界、音乐直播的云蹦迪直播、全民 K 歌的 KK 秀、TMEland 等为代表;另一种是在娱乐公司比较常见的虚拟人代表,比如已公开的扇宝、安可、持续在研发的虚拟人项目,曝光的场景包括虚拟偶像视频、虚拟直播、重要节点开虚拟演唱会等,都是虚拟偶像展现的地方。

二、音乐生成数字人舞蹈

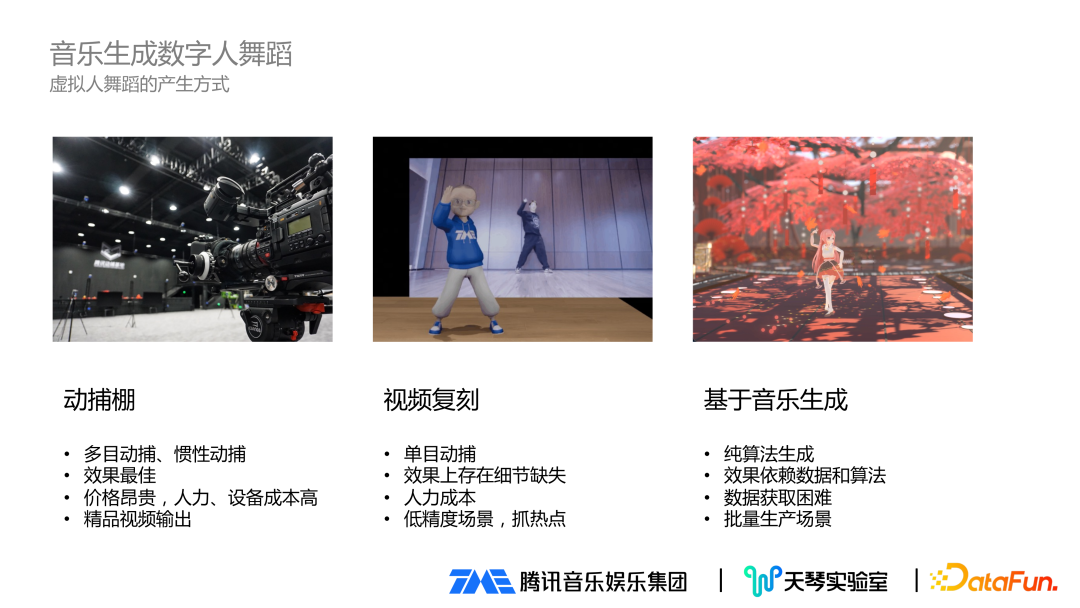

1、虚拟人舞蹈的产生方式

数字人舞蹈的生成方式大致分成三种:

动捕棚:采用目前比较新的多目动捕设备、惯性捕捉,得到的效果是真正影视级效果,也是目前能接触到的最佳效果。但存在价格昂贵,人力、设备成本高等问题。应用场景来说,可用于精品视频输出。

视频复刻:属于单目动捕,用于普通的低精度场景效果还不错,但运用到非常激烈的快节奏舞蹈,特别是运用到高精度模型,效果上存在细节丢失。这种方式人力成本相对较低,所以在低精度模型场景上应用较多。视频复刻有个非常明显的优势是其他方式达不到的,它可以很好抓住热点。现在的短视频类平台每隔一段时间都会出一些热点舞蹈,通过这种方式可以快速的把热门舞蹈实时复刻出来。

基于音乐生成:属于纯算法生成,效果依赖数据质量和算法自身好坏。存在的问题是数据获取困难,优势在于可以批量生产场景。在批量场景下,可以和精品视频进行互补,在日常视频输出可以用到这种基于音乐生成舞蹈的方案。

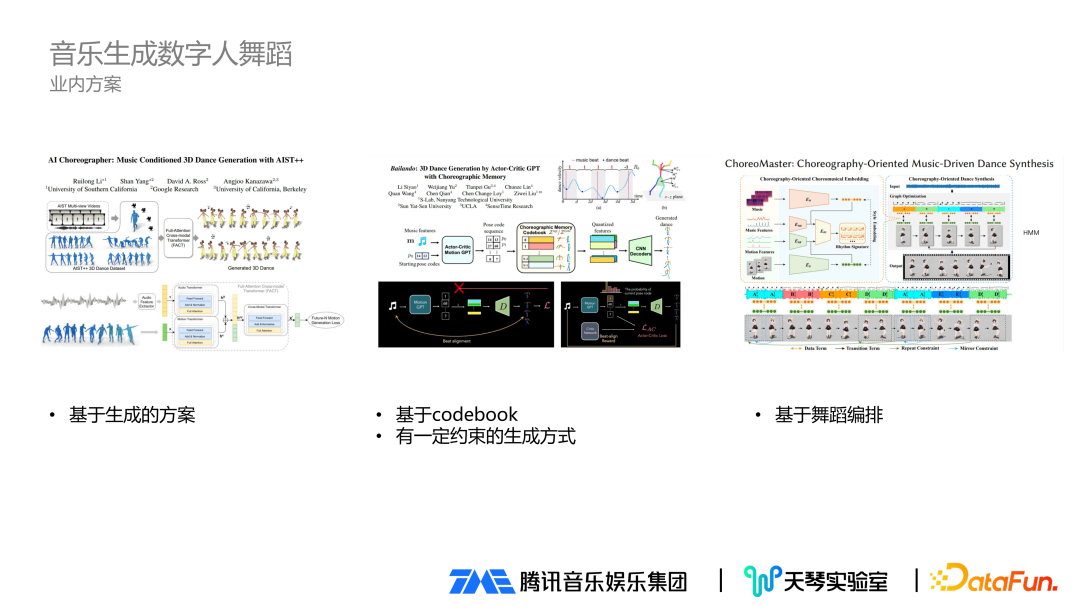

2、音乐生成数字人舞蹈的业内方案

业内有很多音乐生成数字人舞蹈的方案,大致有如下几种:

基于生成的方案:非常具有想象力的方案,但商用可能存在不可控情况。

基于 codebook:对比于生成的方案进行改进,加入了 codebook 等方式,对生成的舞蹈规律有一定约束,是非常不错的方案。

基于舞蹈编排:实验的难度和实现的可行性更高一些。

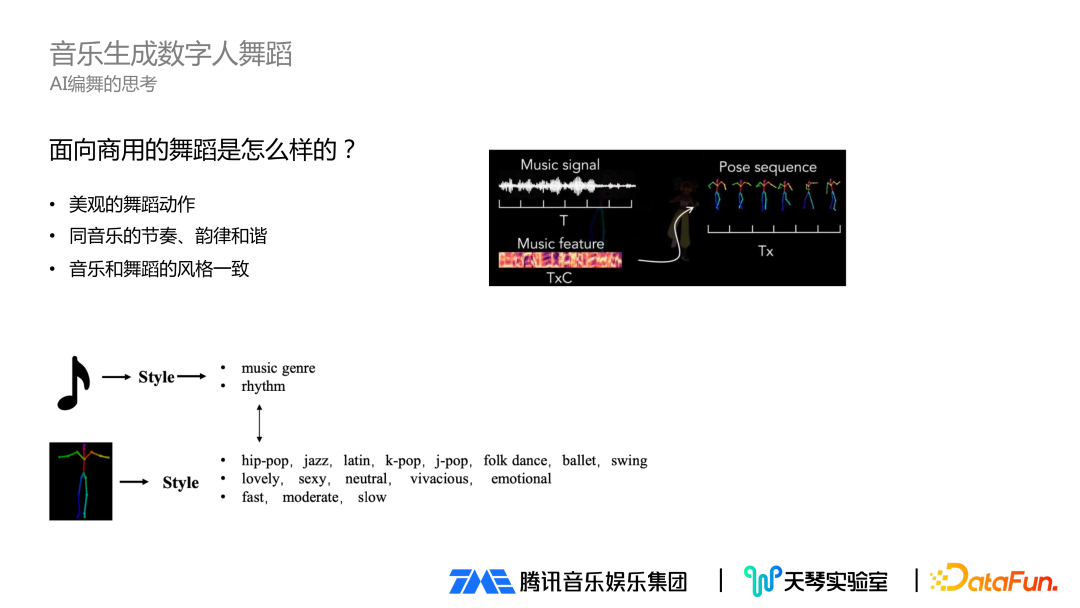

面向商用的舞蹈生成如何做,有三点因素需要考虑:一是舞蹈动作本身是美观的动作;二是舞蹈动作和音乐的节奏、韵律要和谐一致;三是音乐和舞蹈的风格也要一致。所以在 AI 编舞时重点会关注音乐特征,包括音乐本身的特性、音乐节奏等,对舞蹈也会做对应匹配,包括舞蹈属性、风格、情绪、节奏快慢等。综合来看,商用舞蹈生成是在有原始音频文件后,通过一些方法提取音频特征,接着通过特征回归到舞蹈动作,最后将这些动作合理的拼接起来。

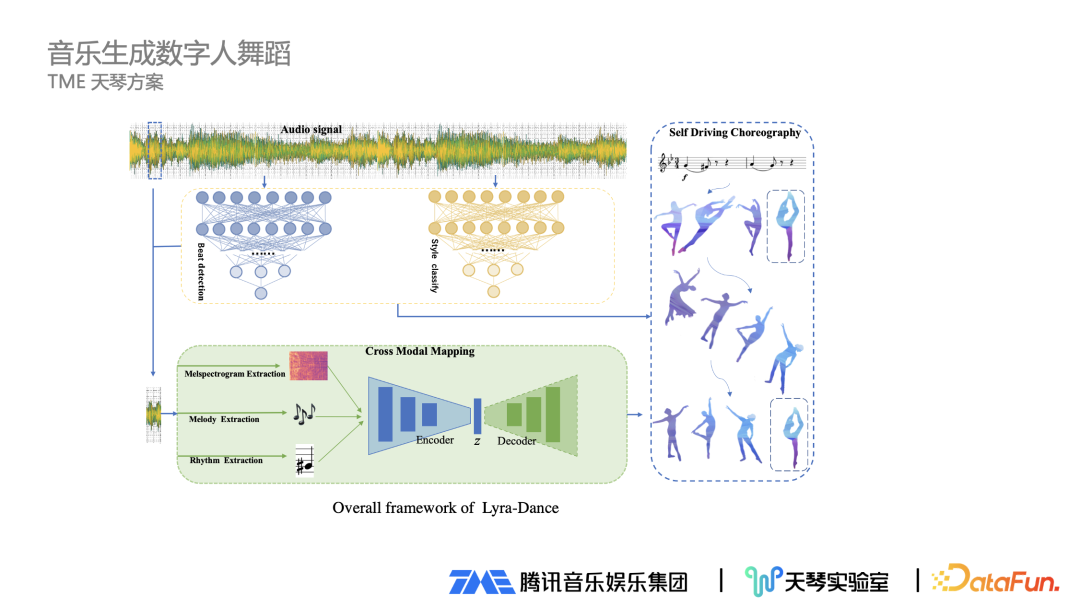

3、TME 天琴方案

下方是 TME 天琴方案的生成算法截图。当拿到一段音乐后,切成一帧一帧的小片段,接着对每一帧提取对应的音乐属性特征,包括旋律、节奏等最能代表音乐和舞蹈的特征,然后去匹配最合适的舞蹈片段,同时基于音乐节奏、风格类型,对召回的片段进行重新排序,过滤掉不太适合的片段,最终把对应的片段进行拼接,就形成一段完整舞蹈。这里还涉及一个问题,舞蹈动作可能前后段连接有问题,可通过平滑算法进行过渡来解决。

这个方案实际应用起来比较简单,而且可以直接使用。但这个方案存在一定问题,因为想象力不够,生成的方案多样性略差。

另外一套方案是基于生成的方案。输入一段音频信号,对应的原始样本音频会关联到对应的舞蹈,输入模型中经过一个过程,还原回最初的舞蹈动作。在这个过程中,要把音频信号特征和舞蹈信号特征尽量拉齐,尽量表达更广泛的含义。

音乐生成数字人舞蹈完成后,可以进行主观评测。对于同一首歌曲,将生成的舞蹈与手K的舞蹈动作发给普通用户进行对比,采用两种方式进行比较:第一种方式是直接比较生成的结果和手K的结果,让用户选择哪种更好;第二种方式是对生成的结果和手K的结果分别进行打分。经过评测发现,这两种方式的结论相似,生成的结果已经接近手K的效果,总体效果不错

4、数字人舞蹈的商用路径

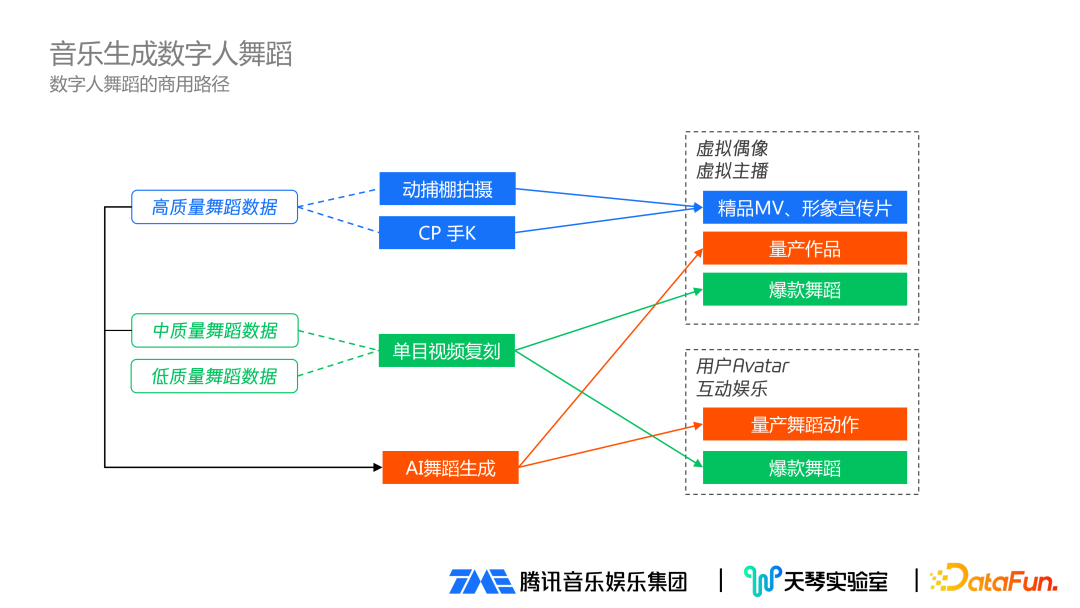

在数字人舞蹈的商用路径方面理解如下:

首先,通过动捕棚拍摄、CP 手 K 效果最好,会应用到虚拟偶像、虚拟主播的精品 MV、形象宣传片,同时这类高质量舞蹈数据可以保留下来。

第二,单目的视频复刻主要用到虚拟主播、虚拟偶像、用户互动娱乐场景的爆款舞蹈生成。生成数据可以经过人工筛选,把中质量舞蹈数据保留下来。

最后,把之前保留下来的高质量舞蹈数据和中质量舞蹈数据,作为 AI 舞蹈生成模型的数据来源,生成的舞蹈数据就作为量产数据,用在虚拟偶像、虚拟主播、用户互娱场景,批量生产更多的舞蹈动作。

三 、歌声驱动数字人口型

1、歌声驱动数字人口型方案

歌声驱动数字人口型有两种实现方案:

① 专业面捕方案:有专业设备、配套软件,优点是效果最佳,无限表情基。广泛应用于超写实虚拟人场景。

② 普通光学摄像头方案:通过普通手机摄像头可以实现,一般场景下效果完全可接受,标准 52 BS。适用于一般的虚拟人场景。

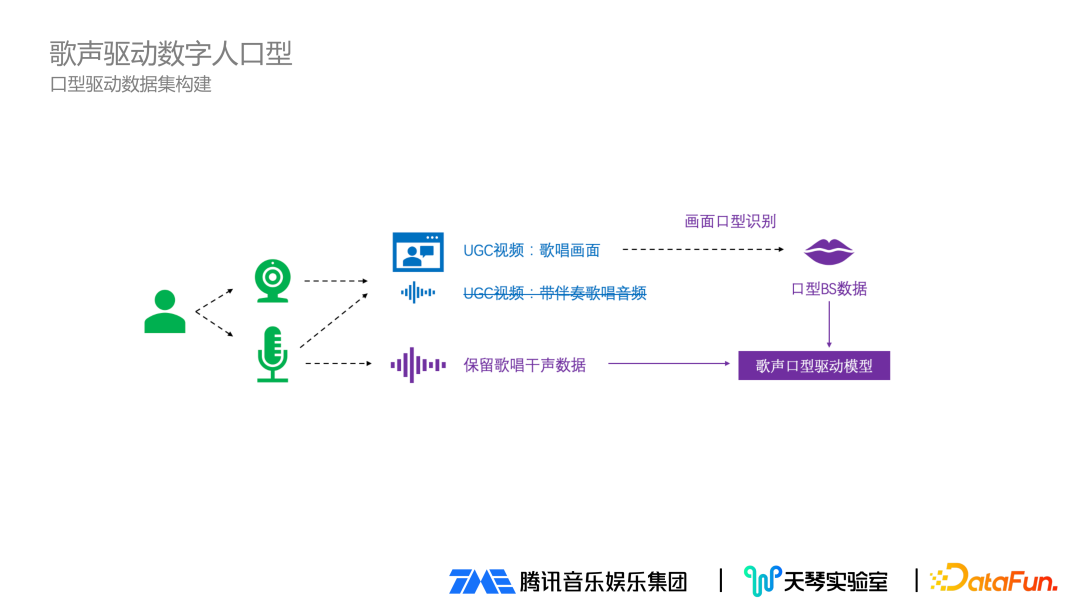

2、口型驱动数据集构建

在口型驱动数据数据建设上,把全民 K 歌软件的用户 K 歌视频画面保留下来,同时录入用户唱歌干声数据。通过前面提到的单目动捕方案,把唱歌画面进行口型识别,拿到口型 BS 数据,再加上保留下来的用户唱歌干声数据,同时输入到歌声口型驱动模型。

歌唱驱动和说话驱动有差别:说话时嘴巴动的频率比较快,但是唱歌时因为要一口气唱下去,嘴巴表现更有连贯性;同时说话时嘴巴动的幅度没有歌唱时幅度大,这也是专门做歌唱口型驱动模型的原因。

3、TME 口型驱动模型

TME 口型驱动模型的方案同时使用两部分数据:一部分是用户输入的干声数据,另一部分是歌词文件(经过前处理,对歌词文件和音频进行对齐,获取每个字的准确时间戳)。对输入音频和歌词进行编码处理后,进行融合。将融合结果输入到另一个面部匹配预测模块,该模块将当前帧的歌词和音频信息与之前所有帧的信息放在一起,进行解码处理。最终预测整首歌的匹配变化,并转换为所需的模型参数

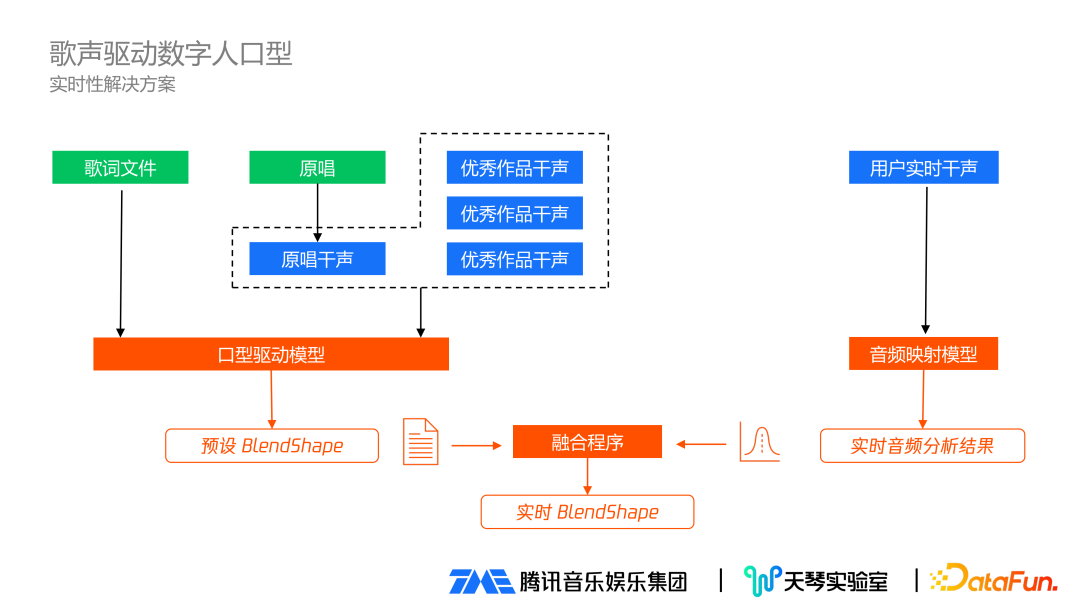

4、实时性解决方案

前面是异步生成视频的场景,实时性如何解决有如下考虑:先离线生成预设 BlendShape,输入测试文件及干声数据,干声来源于两个部分:一是之前用户唱的优秀作品干生;二是歌曲原唱,通过技术提取原唱的干声,然后把各式文件和综合干声,通过前面的口型驱动模型,得到预设 BlendShape。等到真正实施时,用户实时干声经过音频映射模型,得到实时音频分析结果,和前面的预设 BlendShape 进行融合,最后得到实时 BlendShape。这样就解决了实时性问题,同时兼备口型生成的效果。

相关技术已经应用于实时解决方案,并在全民K歌8.0的QQ秀中得以体验:用户在唱歌时,可以在K歌秀界面中同时观看到QQ秀虚拟人物的动作和口型;在歌房场景中也有类似的体验

四、歌声驱动数字人歌唱表情

当做好数字人歌唱口型后,发现人显得比较呆。分析专业歌手演唱表演,发现唱歌时要表达歌唱情感,除了口型之外,歌唱时的面部表情、手势、动作都要同时具备,三者合一的完整表现才能突出演唱者当时的强烈情感。

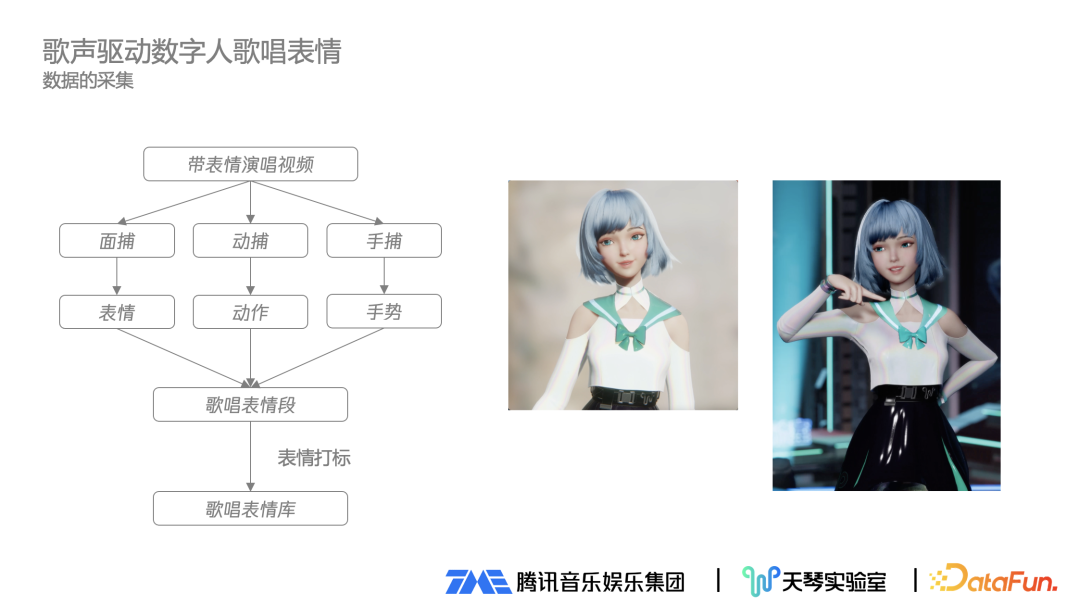

1、歌唱表情数据的采集

歌声驱动数字人歌唱表情的实现需要进行数据采集。数据采集时先找到带表情的演唱视频样本,通过面捕拿到面部表情,通过动捕拿到动作,通过手捕拿到手势,然后把表情、动作和手势合一,融入歌唱表情段,经过人工表情打标后放入歌唱表情库。

2、歌唱表情的合理驱动

采集到歌唱表情之后,需要合理的驱动起来。经过歌词文本分析拿到歌唱时歌词的表情信息,确定整个歌唱表演的表情基调。此时可以从庞大的各种类型表情库里,挑选出合适的表情,适合于在歌曲或者歌曲的某一个片段安插表情。

五、总结与展望

这两年上线了很多与虚拟人或元宇宙相关的平台和产品,娱乐公司、明星、大型商业公司、海量主播、普通用户等很多都有自身的虚拟形象,虚拟形象将变得越来越普遍。

中之人面临的问题越来越多,包括成本问题、管理问题,以及虚拟形象的灵魂归属问题,即虚拟偶像本身还是中之人

AI 驱动技术面临快速升级,包括形象创建技术、视觉驱动技术、音频歌声合成技术等。TME 以音乐为核心进行技术建设,包括音乐驱动数字人舞蹈、数字人歌唱口型、数字人歌唱表情等,未来还有其他方面。

总体来说,数字人的未来在于技术。

六、问答环节

Q1:动捕数据或公开数据集重定向到模型驱动有问题时如何处理?

确实会存在重定向的问题。首先,我们会将数据重定向到一些标准模型,然后通过人工发现有问题的数据,并对其进行分类。对于那些可以通过手动方式解决的问题,我们会进行修复;对于无法解决的问题,我们会直接将数据抛弃掉

Q2:音乐生成数字人舞蹈的客观评测方法?

A2:由于音乐生成数字人舞蹈是一个主观性较强的领域,所以生成的结果不可能与原始的完全相同,如果完全相同的话,就失去了意义。因此,对于音乐生成数字人舞蹈更多的是进行主观评估

Q3:现在主要研究的是卡通类型的数字人吗?

A3:现在主要研究的是在卡通类型的数字人,目前没有太涉及写实虚拟人方面。

Q4:拼接的单元是小节吗?

A4:拼接的单元不是小节。这里涉及到一些细节,比如根据音乐的节奏进行切分,并不是简单的切几秒钟舞蹈片段,需要把舞蹈片段切的更便于后续的拼接。

今天带大家了解了的相关知识,希望对你有所帮助;关于科技周边的技术知识我们会一点点深入介绍,欢迎大家关注golang学习网公众号,一起学习编程~

2023 OPPO 开发者大会 11 月 16 日举行,发布 ColorOS 14

2023 OPPO 开发者大会 11 月 16 日举行,发布 ColorOS 14

- 上一篇

- 2023 OPPO 开发者大会 11 月 16 日举行,发布 ColorOS 14

- 下一篇

- 阿里回应旗下社科机构“罗汉堂”关闭传闻:机构和品牌将继续存在

-

- 科技周边 · 人工智能 | 1小时前 |

- NightCafe图层合并技巧全解析

- 418浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 |

- LeonardoAI色调统一技巧详解

- 150浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 |

- DeepSeek功能解析与实战技巧全攻略

- 268浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 |

- Copilot三种模式怎么选?创意/平衡/精确详解

- 458浏览 收藏

-

- 科技周边 · 人工智能 | 2小时前 |

- AI课件微课制作,教师提效必备指南

- 149浏览 收藏

-

- 科技周边 · 人工智能 | 2小时前 |

- 豆包语音识别失败?检查录音权限方法

- 177浏览 收藏

-

- 科技周边 · 人工智能 | 2小时前 |

- Monday.comAI总结模板怎么用

- 293浏览 收藏

-

- 科技周边 · 人工智能 | 2小时前 |

- ChatGPT手写识别难题,分块推测更准确

- 275浏览 收藏

-

- 科技周边 · 人工智能 | 2小时前 |

- 豆包AI登录入口官网地址分享

- 297浏览 收藏

-

- 科技周边 · 人工智能 | 3小时前 |

- DeepSeek生成的内容被识别为AI,语序得调整,多加点口语化说法。

- 248浏览 收藏

-

- 科技周边 · 人工智能 | 3小时前 |

- AI创作爆款短视频脚本的创意与框架

- 462浏览 收藏

-

- 科技周边 · 人工智能 | 4小时前 |

- 文心一言绘图怎么用?AI绘画指令全攻略

- 185浏览 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 485次学习

-

- ChatExcel酷表

- ChatExcel酷表是由北京大学团队打造的Excel聊天机器人,用自然语言操控表格,简化数据处理,告别繁琐操作,提升工作效率!适用于学生、上班族及政府人员。

- 3892次使用

-

- Any绘本

- 探索Any绘本(anypicturebook.com/zh),一款开源免费的AI绘本创作工具,基于Google Gemini与Flux AI模型,让您轻松创作个性化绘本。适用于家庭、教育、创作等多种场景,零门槛,高自由度,技术透明,本地可控。

- 4202次使用

-

- 可赞AI

- 可赞AI,AI驱动的办公可视化智能工具,助您轻松实现文本与可视化元素高效转化。无论是智能文档生成、多格式文本解析,还是一键生成专业图表、脑图、知识卡片,可赞AI都能让信息处理更清晰高效。覆盖数据汇报、会议纪要、内容营销等全场景,大幅提升办公效率,降低专业门槛,是您提升工作效率的得力助手。

- 4106次使用

-

- 星月写作

- 星月写作是国内首款聚焦中文网络小说创作的AI辅助工具,解决网文作者从构思到变现的全流程痛点。AI扫榜、专属模板、全链路适配,助力新人快速上手,资深作者效率倍增。

- 5303次使用

-

- MagicLight

- MagicLight.ai是全球首款叙事驱动型AI动画视频创作平台,专注于解决从故事想法到完整动画的全流程痛点。它通过自研AI模型,保障角色、风格、场景高度一致性,让零动画经验者也能高效产出专业级叙事内容。广泛适用于独立创作者、动画工作室、教育机构及企业营销,助您轻松实现创意落地与商业化。

- 4481次使用

-

- GPT-4王者加冕!读图做题性能炸天,凭自己就能考上斯坦福

- 2023-04-25 501浏览

-

- 单块V100训练模型提速72倍!尤洋团队新成果获AAAI 2023杰出论文奖

- 2023-04-24 501浏览

-

- ChatGPT 真的会接管世界吗?

- 2023-04-13 501浏览

-

- VR的终极形态是「假眼」?Neuralink前联合创始人掏出新产品:科学之眼!

- 2023-04-30 501浏览

-

- 实现实时制造可视性优势有哪些?

- 2023-04-15 501浏览