MVDiffusion:实现高质量多视角图像生成与精确复刻场景材质

科技周边不知道大家是否熟悉?今天我将给大家介绍《MVDiffusion:实现高质量多视角图像生成与精确复刻场景材质》,这篇文章主要会讲到等等知识点,如果你在看完本篇文章后,有更好的建议或者发现哪里有问题,希望大家都能积极评论指出,谢谢!希望我们能一起加油进步!

逼真的图像生成在虚拟现实、增强现实、视频游戏和电影制作等领域有广泛应用。

随着近两年来扩散模型的快速发展,图像生成领域取得了重大突破。从Stable Diffusion衍生出的一系列根据文本描述生成图像的开源或商业模型,已经对设计、游戏等领域产生了巨大的影响

然而,如何根据给定的文本或其他条件,产生高质量的多视角图像仍然是一个挑战。已有的方法在多视图一致性方面存在明显的缺陷

目前常见的方法可以大致分为两类

第一类方法致力于生成一个场景的图片以及深度图,并得到对应的mesh,如Text2Room,SceneScape——首先用Stable Diffusion生成第一张图片,然后使用图像扭转(Image Warping)和图像补全(image inpainting)的自回归方式生成后续的图片以及深度图。

但是,这样的方案容易导致错误在多张图片的生成过程中逐渐累积,并且通常存在闭环问题(比如在相机旋转一圈回到起始位置附近时,生成的内容与第一张图片并不完全一致),导致其在场景规模较大或图片间视角变化较大时的效果欠佳。

第二类方法通过扩展扩散模型的生成算法,同时生成多张图片,以产生比单张图片更丰富的内容(例如生成360度全景图,或将一张图片的内容向两侧无限外推),例如MultiDiffusion和DiffCollage。然而,由于没有考虑相机模型,这类方法生成的结果并不是真正的全景图

MVDiffusion的目标是生成符合给定相机模型的多视角图片,这些图片在内容上严格一致且具有全局语义统一。该方法的核心思想是同时去噪和学习图片之间的对应关系以保持一致性

请点击以下链接查看论文:https://arxiv.org/abs/2307.01097

请访问项目网站:https://mvdiffusion.github.io/

Demo: https://huggingface.co/spaces/tangshitao/MVDiffusion

代码:https://github.com/Tangshitao/MVDiffusion

会议发表:NeurIPS(重点)

MVDiffusion的目标是通过同步去噪和基于图片之间对应关系的全局意识,产生内容高度一致且全局语义统一的多视角图片

具体地,研究人员对已有的文本-图片扩散模型(如Stable Diffusion)进行拓展,首先让其并行地处理多张图片,并进一步在原本的UNet中加入额外的「Correspondence-aware Attention」机制来学习多视角间的一致性和全局的统一性。

通过在少量的多视角图片训练数据上进行微调,最后得到的模型能够同步生成内容高度一致的多视角图片。

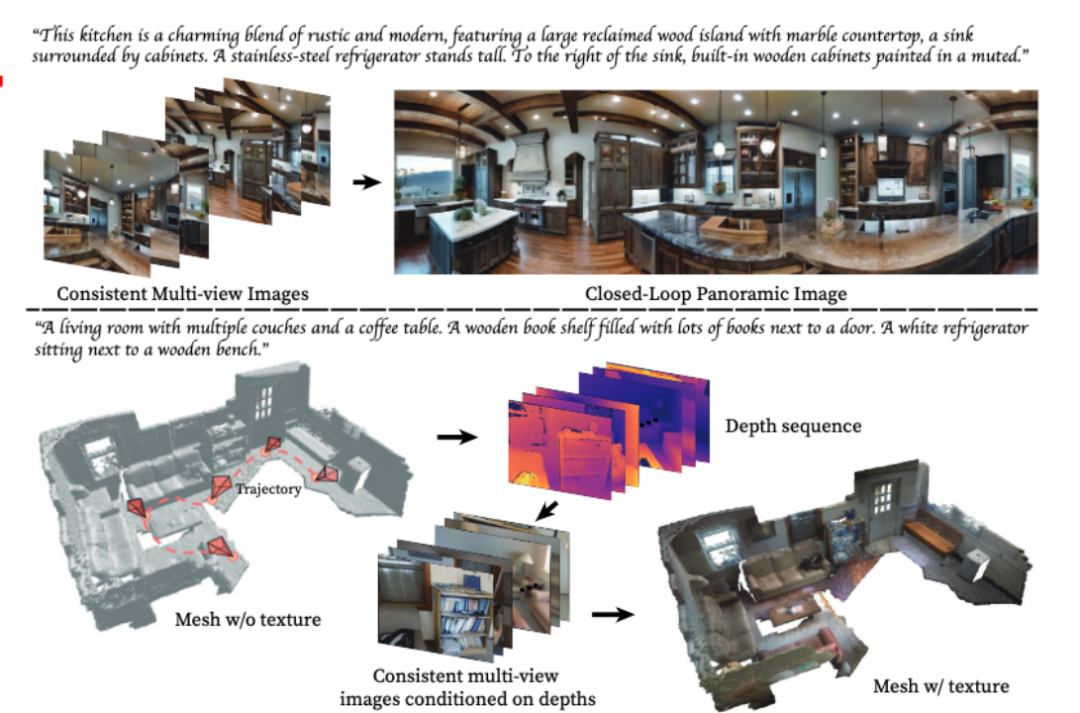

MVDiffusion在三个不同的应用场景中已经取得了很好的效果:

根据文字生成多视图,然后拼接以获得全景图

2. 将透视图像外推(outpainting)得到完整的360度全景图;

3. 为场景生成材质(texture)。

应用场景展示

应用1:全景图生成的过程是将多张照片或视频拼接在一起,以创建一个全景视角的图像或视频。这个过程通常涉及到使用特殊的软件或工具来自动或手动地将这些图像或视频进行对齐、融合和修复。通过全景图生成,人们可以以更广阔的视野来欣赏和体验场景,例如风景、建筑物或室内空间。这项技术在旅游、房地产、虚拟现实等领域具有广泛的应用(根据文字)

以生成全景图为例,输入一段描述场景的文字,MVDIffusion可以生成一个场景的多视角图片

输入以下内容可以获得8张多视角图片:“这个厨房是乡村与现代的迷人融合,拥有一个大型的回收木岛台带有大理石台面,一个被橱柜环绕的水槽。岛台的左边是一台高大的不锈钢冰箱。水槽的右边是涂有柔和色彩的内置木制橱柜。”

这8张图片能够拼接成一张全景图:

MVDiffusion也支持为每张图片提供不同的文字描述,但是这些描述之间需要保持语义上的一致性。

应用2:全景图生成的过程是将多张照片或视频拼接在一起,以创建一个全景视角的图像或视频。这个过程通常涉及到使用特殊的软件或工具来自动或手动地将这些图像或视频进行对齐、融合和修复。通过全景图生成,人们可以以更广阔的视野来欣赏和体验场景,例如风景、建筑物或室内空间。这项技术在旅游、房地产、虚拟现实等领域具有广泛的应用(根据一张透视图像)

MVDiffusion能够将一张透视图像外推(outpainting)成完整的360度全景图。

举个例子,假设我们输入下面这张透视图:

MVDiffusion能进一步生成下面的全景图:

可以看到,生成的全景图在语义上对输入图片进行了扩展,而且最左和最右的内容是相连的(没有闭环问题)。

应用3:生成场景材质

使用MVDiffusion可以为给定的无材质场景网格生成材质(纹理)

具体地,我们首先通过渲染mesh得到多视角的深度图(depth map),通过相机位姿(pose)以及深度图,我们可以获得多视角图片的像素之间的对应关系。

接着,MVDiffusion以多视角depth map作为条件,同步生成一致的多视角RGB图片。

因为生成的多视角图片能保持内容的高度一致,将它们再投回mesh,即可以得到高质量的带材质的mesh(textured mesh)。

以下是更多的效果示例:

全景图生成的过程是将多张照片或视频拼接在一起,以创建一个全景视角的图像或视频。这个过程通常涉及到使用特殊的软件或工具来自动或手动地将这些图像或视频进行对齐、融合和修复。通过全景图生成,人们可以以更广阔的视野来欣赏和体验场景,例如风景、建筑物或室内空间。这项技术在旅游、房地产、虚拟现实等领域具有广泛的应用

在这个应用场景中,需要特别提到的是,虽然在训练MVDiffusion时使用的多视角图片数据都来自于室内场景的全景图,而且风格都是单一的

然而,MVDiffusion并没有改变原始的稳定扩散参数,而只是对新加入的Correspondence-aware Attention进行了训练

最后,模型依然能根据给定的文本产生各种不同风格的多视角图片(如室外,卡通等)。

需要进行改写的内容是:单视图外推

场景材质生成

我们将首先介绍MVDiffusion在三个不同任务中的具体图片生成流程,最后再介绍方法的核心部分,即「Correspondence-aware Attention」模块。图1展示了MVDiffusion的概览

1. 全景图生成的过程是将多张照片或视频拼接在一起,以创建一个全景视角的图像或视频。这个过程通常涉及到使用特殊的软件或工具来自动或手动地将这些图像或视频进行对齐、融合和修复。通过全景图生成,人们可以以更广阔的视野来欣赏和体验场景,例如风景、建筑物或室内空间。这项技术在旅游、房地产、虚拟现实等领域具有广泛的应用(根据文字)

MVDiffusion同步生成8张带有重叠的图片(perspective image),然后再将这8中图片缝合(stitch)成全景图。在这8张透视图中,每两张图之间由一个3x3单应矩阵(homographic matrix)确定其像素对应关系。

在具体的生成过程中,MVDiffusion首先使用高斯随机初始化来生成8个视角的图片

然后,将这8张图片输入到一个具有多分支的Stable Diffusion预训练Unet网络中,进行同步去噪(denoising)得到生成结果。

其中UNet网络中加入了新的「Correspondence-aware Attention」模块(上图中淡蓝色部分),用于学习跨视角之间的几何一致性,使得这8张图片可以被拼接成一张一致的全景图。

2. 全景图生成的过程是将多张照片或视频拼接在一起,以创建一个全景视角的图像或视频。这个过程通常涉及到使用特殊的软件或工具来自动或手动地将这些图像或视频进行对齐、融合和修复。通过全景图生成,人们可以以更广阔的视野来欣赏和体验场景,例如风景、建筑物或室内空间。这项技术在旅游、房地产、虚拟现实等领域具有广泛的应用(根据一张透视图片)

MVDiffusion也可以将单张透视图补全成全景图。与全景图生成的过程是将多张照片或视频拼接在一起,以创建一个全景视角的图像或视频。这个过程通常涉及到使用特殊的软件或工具来自动或手动地将这些图像或视频进行对齐、融合和修复。通过全景图生成,人们可以以更广阔的视野来欣赏和体验场景,例如风景、建筑物或室内空间。这项技术在旅游、房地产、虚拟现实等领域具有广泛的应用相同,MVDiffusion将随机初始化的8个视角图片(包括透视图对应的视角)输入到多分支的Stable Diffusion Inpainting预训练的UNet网络中。

在Stable Diffusion Inpainting模型中,与之不同的是,UNet通过使用额外的输入掩码(mask)来区分作为条件的图片和将要生成的图片

透视图对应的视角,掩码设为1,该分支的UNet将直接恢复透视图。而其他视角,掩码设为0,对应分支的UNet将生成新的透视图

同样地,MVDiffusion使用「Correspondence-aware Attention」模块来学习生成图片与条件图片之间的几何一致性与语义统一性。

3. 场景材质生成

MVDiffusion首先基于深度图以及相机位姿生成一条轨迹上的RGB图片,然后使用TSDF fusion将生成的RGB图片与给定的深度图合成mesh。

RGB图片的像素对应关系可以通过深度图和相机位姿得到。

与全景图生成的过程是将多张照片或视频拼接在一起,以创建一个全景视角的图像或视频。这个过程通常涉及到使用特殊的软件或工具来自动或手动地将这些图像或视频进行对齐、融合和修复。通过全景图生成,人们可以以更广阔的视野来欣赏和体验场景,例如风景、建筑物或室内空间。这项技术在旅游、房地产、虚拟现实等领域具有广泛的应用一样,我们使用多分支UNet,并插入「Correspondence-aware Attention」来学习跨视角之间的几何一致性。

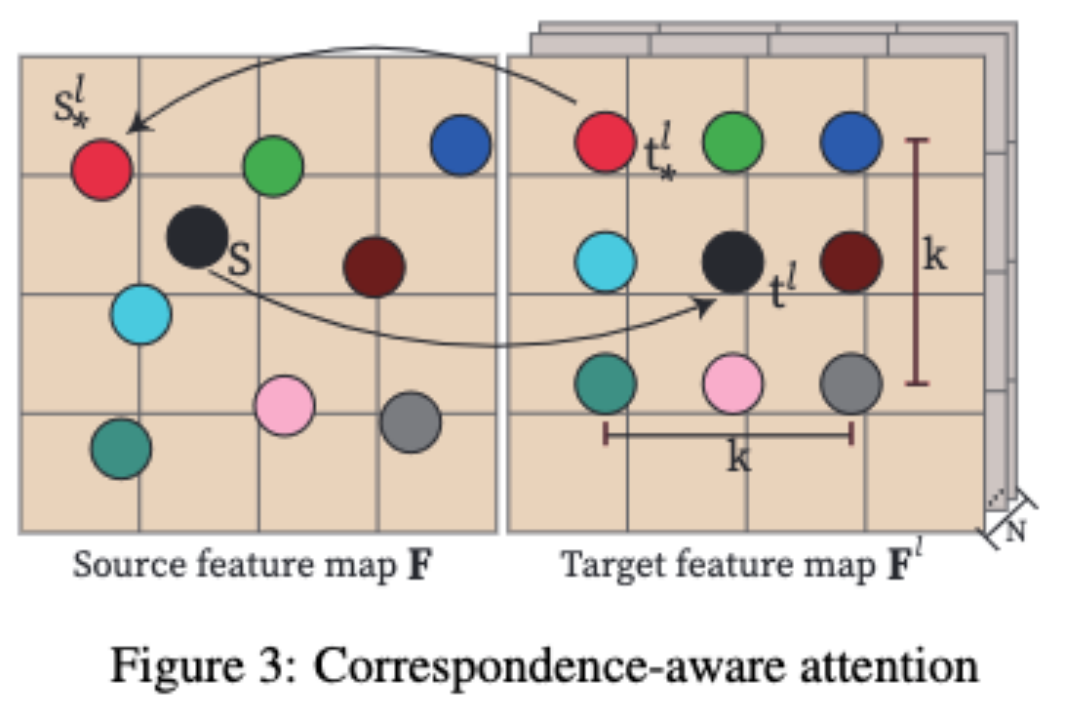

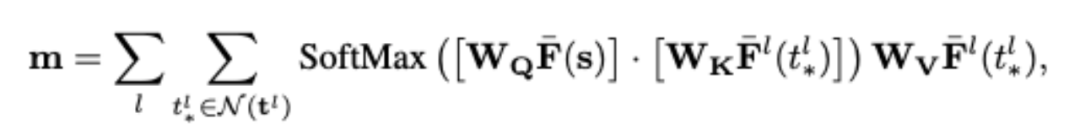

4. Correspondence-aware Attention机制

「Correspondence-aware Attention」(CAA),是MVDiffusion的核心,用于学习多视图之间的几何一致性和语义统一性。

MVDiffusion在Stable Diffusion UNet中的每个UNet block之后插入「Correspondence-aware Attention」block。CAA通过考虑源特征图和N个目标特征图来工作。

对于源特征图中的一个位置,我们基于目标特征图中的对应像素及其邻域来计算注意力输出。

具体来说,对于每个目标像素t^l,MVDiffusion会通过在(x/y)坐标上添加整数位移(dx/dy)来考虑一个K x K的邻域,其中|dx|表示在x方向上的位移大小,|dy|表示在y方向上的位移大小

在实际应用中,MVDiffusion算法使用K=3,并选择9点邻域来提高全景图的质量。然而,在生成受几何条件限制的多视图图像时,为了提高运行效率,选择使用K=1

CAA模块的计算遵循标准的注意力机制,如上图的公式所示,其中W_Q、W_K和W_V是query、key和value矩阵的可学习权重;目标特征不位于整数位置,而是通过双线性插值获得的。

关键的区别是基于源图像中的对应位置s^l与s之间的2D位移(全景)或1D深度误差(几何)向目标特征添加了位置编码。

在全景生成中(应用1和应用2),这个位移提供了本地邻域中的相对位置。

而在深度到图像生成中(应用3),视差提供了关于深度不连续或遮挡的线索,这对于高保真图像生成非常重要。

请注意,位移是一个包含2D(位移)或1D(深度误差)向量的概念。MVDiffusion将标准频率编码应用于位移的x和y坐标

好了,本文到此结束,带大家了解了《MVDiffusion:实现高质量多视角图像生成与精确复刻场景材质》,希望本文对你有所帮助!关注golang学习网公众号,给大家分享更多科技周边知识!

贾佳亚韩松团队新作:两行代码让大模型上下文窗口倍增 | GitHub热榜

贾佳亚韩松团队新作:两行代码让大模型上下文窗口倍增 | GitHub热榜

- 上一篇

- 贾佳亚韩松团队新作:两行代码让大模型上下文窗口倍增 | GitHub热榜

- 下一篇

- 刚刚,2023诺贝尔物理学奖颁给阿秒量级光脉冲!史上第五位女性得主诞生

-

- 科技周边 · 人工智能 | 57分钟前 |

- AIOverviews能预测疫情传播吗?

- 474浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 | 多语培训

- Synthesia多语种培训生成技巧

- 172浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 | AI视频制作

- 可灵AI古装复原教程,历史剧情轻松出片

- 180浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 |

- AI风筝工具+豆包,轻松制作创意风筝教程

- 315浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 | 秘塔AI

- 秘塔AI学习工具官网入口在哪

- 453浏览 收藏

-

- 科技周边 · 人工智能 | 2小时前 |

- TOFAI电脑版登录入口及官网地址

- 396浏览 收藏

-

- 科技周边 · 人工智能 | 3小时前 |

- Gemini语音转清单教程分享

- 241浏览 收藏

-

- 科技周边 · 人工智能 | 3小时前 |

- DeepSeek提示:内容含敏感词,需专业术语替代修改

- 218浏览 收藏

-

- 科技周边 · 人工智能 | 3小时前 |

- 清除豆包缓存方法,提升运行流畅度教程

- 337浏览 收藏

-

- 科技周边 · 人工智能 | 4小时前 |

- AI绘画版权怎么算?商用注意这些要点

- 335浏览 收藏

-

- 科技周边 · 人工智能 | 4小时前 |

- AI建站教程,零基础快速搭建网页

- 158浏览 收藏

-

- 科技周边 · 人工智能 | 4小时前 |

- VerseCrafter:复旦腾讯联合开源视频模型

- 136浏览 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 485次学习

-

- ChatExcel酷表

- ChatExcel酷表是由北京大学团队打造的Excel聊天机器人,用自然语言操控表格,简化数据处理,告别繁琐操作,提升工作效率!适用于学生、上班族及政府人员。

- 3742次使用

-

- Any绘本

- 探索Any绘本(anypicturebook.com/zh),一款开源免费的AI绘本创作工具,基于Google Gemini与Flux AI模型,让您轻松创作个性化绘本。适用于家庭、教育、创作等多种场景,零门槛,高自由度,技术透明,本地可控。

- 4034次使用

-

- 可赞AI

- 可赞AI,AI驱动的办公可视化智能工具,助您轻松实现文本与可视化元素高效转化。无论是智能文档生成、多格式文本解析,还是一键生成专业图表、脑图、知识卡片,可赞AI都能让信息处理更清晰高效。覆盖数据汇报、会议纪要、内容营销等全场景,大幅提升办公效率,降低专业门槛,是您提升工作效率的得力助手。

- 3951次使用

-

- 星月写作

- 星月写作是国内首款聚焦中文网络小说创作的AI辅助工具,解决网文作者从构思到变现的全流程痛点。AI扫榜、专属模板、全链路适配,助力新人快速上手,资深作者效率倍增。

- 5121次使用

-

- MagicLight

- MagicLight.ai是全球首款叙事驱动型AI动画视频创作平台,专注于解决从故事想法到完整动画的全流程痛点。它通过自研AI模型,保障角色、风格、场景高度一致性,让零动画经验者也能高效产出专业级叙事内容。广泛适用于独立创作者、动画工作室、教育机构及企业营销,助您轻松实现创意落地与商业化。

- 4321次使用

-

- GPT-4王者加冕!读图做题性能炸天,凭自己就能考上斯坦福

- 2023-04-25 501浏览

-

- 单块V100训练模型提速72倍!尤洋团队新成果获AAAI 2023杰出论文奖

- 2023-04-24 501浏览

-

- ChatGPT 真的会接管世界吗?

- 2023-04-13 501浏览

-

- VR的终极形态是「假眼」?Neuralink前联合创始人掏出新产品:科学之眼!

- 2023-04-30 501浏览

-

- 实现实时制造可视性优势有哪些?

- 2023-04-15 501浏览