PHP大文件分割技巧与实现方法

还在为PHP分割大文件而烦恼吗?本文为你提供实用的解决方案!**PHP分割大文件**的核心在于流式处理,通过`fopen`、`fread`和`fwrite`等函数,循环读写小块数据,有效避免内存溢出。文章深入剖析了常见的性能瓶颈,如内存限制、执行时间限制和磁盘I/O,并提供了针对性的优化策略,包括合理设置块大小、使用`set_time_limit(0)`以及减少不必要的文件操作。除了按字节分割,还介绍了按行分割文本文件的方法。同时,详细讲解了如何按顺序流式追加各分片进行合并,并通过校验哈希值确保数据的完整性。更重要的是,本文强调了异常处理的重要性,涵盖文件权限、句柄状态、读写结果等方面,并结合日志记录与临时文件清理,保障整个过程的可靠性。掌握这些技巧,轻松应对PHP大文件分割挑战!

答案:PHP分割大文件核心是流式处理,通过fopen、fread、fwrite循环读写小块数据,避免内存溢出;常见瓶颈有内存限制、执行时间限制和磁盘I/O,优化策略包括合理设置块大小、使用set_time_limit(0)和减少不必要的文件操作;除按字节分割外,还可按行分割文本文件;合并时需按顺序流式追加各分片,并校验哈希值确保完整性;异常处理应涵盖文件权限、句柄状态、读写结果,并结合日志与临时文件清理保障可靠性。

PHP要分割大文件,核心思路其实很简单,就是别一口气把整个文件都吞下去,而是小口小口地吃,然后吐出来变成一个个小文件。这本质上是一种流式处理,避免了内存爆炸,尤其是在处理几个GB甚至几十GB的文件时,这是唯一可行的办法。它不是什么魔法,更多的是一种文件I/O的策略选择。

解决方案

分割大文件在PHP中,通常我们会用到文件指针操作,也就是fopen、fread和fwrite这一套组合拳。我的做法是这样的:首先确定一个合适的“块大小”(chunk size),然后循环读取原始文件,每次读取一个块,就把它写入到一个新的、更小的文件中。

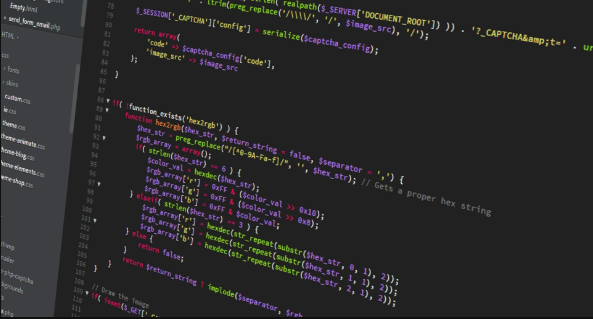

<?php

function splitLargeFile(string $sourceFilePath, string $destinationDir, int $chunkSize = 1024 * 1024 * 5): array

{

// 默认块大小设置为5MB,这个值可以根据实际情况调整。

// 太小了会产生太多文件,I/O开销大;太大了可能还是会短暂占用较多内存,虽然比整个文件小得多。

// 我个人觉得5MB到20MB是个比较折中的选择。

if (!file_exists($sourceFilePath) || !is_readable($sourceFilePath)) {

// 文件不存在或者不可读,这可是个大问题,直接抛异常或者返回错误。

throw new \InvalidArgumentException("源文件不存在或不可读: {$sourceFilePath}");

}

if (!is_dir($destinationDir) || !is_writable($destinationDir)) {

// 目标目录不存在或者不可写,同样是致命错误。

// 生产环境中,可能需要先尝试创建目录。

throw new \InvalidArgumentException("目标目录不存在或不可写: {$destinationDir}");

}

$sourceFileHandle = fopen($sourceFilePath, 'rb'); // 'rb' 以二进制安全模式读取

if (!$sourceFileHandle) {

throw new \RuntimeException("无法打开源文件进行读取: {$sourceFilePath}");

}

$partFiles = [];

$partNum = 0;

// 循环读取直到文件末尾

while (!feof($sourceFileHandle)) {

$buffer = fread($sourceFileHandle, $chunkSize); // 读取指定大小的块

if ($buffer === false) {

// 读取失败了,这通常是I/O错误,需要记录日志并中断。

fclose($sourceFileHandle);

throw new \RuntimeException("从源文件读取数据失败: {$sourceFilePath}");

}

if (empty($buffer)) {

// 如果读取到空内容,可能是文件末尾,也可能是其他问题。

// 但feof会处理文件末尾,所以这里空buffer通常意味着文件已读完或出现异常。

break;

}

$partFileName = sprintf('%s/%s.part%04d', $destinationDir, basename($sourceFilePath), $partNum);

$partFileHandle = fopen($partFileName, 'wb'); // 'wb' 以二进制安全模式写入,如果文件存在则覆盖

if (!$partFileHandle) {

fclose($sourceFileHandle);

throw new \RuntimeException("无法创建或打开分片文件进行写入: {$partFileName}");

}

$bytesWritten = fwrite($partFileHandle, $buffer);

if ($bytesWritten === false || $bytesWritten < strlen($buffer)) {

// 写入失败或写入不完整,这很严重。

fclose($partFileHandle);

fclose($sourceFileHandle);

throw new \RuntimeException("写入分片文件失败或不完整: {$partFileName}");

}

fclose($partFileHandle); // 每次写入完成后立即关闭分片文件句柄

$partFiles[] = $partFileName;

$partNum++;

}

fclose($sourceFileHandle); // 关闭源文件句柄

return $partFiles;

}

// 示例用法:

// $largeFilePath = '/path/to/your/large_file.zip'; // 替换为你的大文件路径

// $outputDirectory = '/path/to/output/parts'; // 替换为分片文件存放目录

// try {

// // 确保输出目录存在,如果不存在,手动创建一下

// if (!is_dir($outputDirectory)) {

// mkdir($outputDirectory, 0755, true);

// }

// $splitFiles = splitLargeFile($largeFilePath, $outputDirectory, 1024 * 1024 * 10); // 分成10MB的块

// echo "文件分割成功,共生成 " . count($splitFiles) . " 个分片文件:\n";

// foreach ($splitFiles as $file) {

// echo $file . "\n";

// }

// } catch (\Exception $e) {

// echo "文件分割失败: " . $e->getMessage() . "\n";

// }

?>这个函数的核心思想就是fread和fwrite的循环。fread一次读取指定大小的数据到内存缓冲区,然后fwrite再把这些数据写入新的文件。这个缓冲区的大小($chunkSize)是关键,它决定了每次内存占用的峰值。

PHP分割大文件时常见的性能瓶颈与优化策略有哪些?

在PHP处理大文件分割时,我们经常会碰到一些让人头疼的性能瓶颈。在我看来,最主要的有三个:内存限制(memory_limit)、执行时间限制(max_execution_time)以及磁盘I/O性能。

首先说内存限制。虽然我们用了分块读取,避免了将整个文件载入内存,但如果你设置的$chunkSize过大,或者在循环内部有其他操作导致内存累积,还是有可能触碰到memory_limit。解决办法是:合理设置$chunkSize,通常几MB到几十MB是比较安全的范围。同时,确保在每次循环中,没有创建大量临时变量或者对数据进行不必要的复制。PHP的垃圾回收机制虽然会工作,但及时释放不再使用的变量(比如unset($buffer),尽管在循环中通常不是必须的,因为$buffer会被新值覆盖)也是个好习惯。

其次是执行时间限制。PHP脚本默认的执行时间通常是30秒或60秒。对于一个GB级别的文件分割,这时间远远不够。一个简单粗暴但有效的方法是在脚本开头加上set_time_limit(0);,这会取消脚本的执行时间限制。当然,这只适用于命令行或你完全控制的服务器环境。在Web环境下,长时间运行的脚本可能会导致用户体验不佳或服务器资源耗尽,所以如果可能,最好将大文件处理放到后台队列或定时任务(Cron Job)中执行。

最后是磁盘I/O性能。这其实是硬伤,PHP能做的优化有限,更多依赖于服务器硬件。但我们还是可以做一些事情:

- 选择合适的块大小:太小的块会导致频繁的I/O操作,每次打开、写入、关闭文件都会有系统开销;太大的块虽然减少了操作次数,但如果超出了操作系统或硬件的最佳缓存/传输单元,也可能效率不高。经验法则是在几MB到几十MB之间测试,找到你服务器的最佳点。

- 避免不必要的磁盘操作:比如,不要在循环内部重复检查文件是否存在或创建目录,这些操作应该在循环外部一次性完成。

- 使用

rb/wb模式:确保以二进制安全模式打开文件,这对于任何文件类型都适用,并且可以避免PHP在处理非文本文件时可能出现的字符编码问题。

总的来说,优化策略就是:管好内存,放宽时间,以及尽量减少不必要的磁盘折腾。

除了固定大小分割,PHP还有哪些分割大文件的方法?以及如何有效合并这些分割文件?

除了前面提到的固定大小(字节数)分割,PHP在处理文本文件时,还可以考虑按行分割。这种方法特别适用于日志文件、CSV文件等以行作为逻辑单元的数据。

按行分割的实现思路:

不是用fread($handle, $chunkSize),而是用fgets($handle)逐行读取。你可以设置一个“行数限制”,比如每10000行写入一个新文件。

// 简化示例,不包含完整错误处理

function splitFileByLines(string $sourceFilePath, string $destinationDir, int $linesPerFile = 10000): array

{

$sourceFileHandle = fopen($sourceFilePath, 'r'); // 'r' 文本模式读取

if (!$sourceFileHandle) { /* 错误处理 */ }

$partFiles = [];

$partNum = 0;

$lineCount = 0;

$currentPartFileHandle = null;

while (($line = fgets($sourceFileHandle)) !== false) {

if ($lineCount % $linesPerFile === 0) {

// 如果达到行数限制,或者这是第一个文件

if ($currentPartFileHandle) {

fclose($currentPartFileHandle); // 关闭上一个分片文件

}

$partFileName = sprintf('%s/%s_linepart%04d.txt', $destinationDir, basename($sourceFilePath, '.txt'), $partNum);

$currentPartFileHandle = fopen($partFileName, 'w'); // 'w' 文本模式写入

if (!$currentPartFileHandle) { /* 错误处理 */ }

$partFiles[] = $partFileName;

$partNum++;

}

fwrite($currentPartFileHandle, $line);

$lineCount++;

}

if ($currentPartFileHandle) {

fclose($currentPartFileHandle);

}

fclose($sourceFileHandle);

return $partFiles;

}这种方法的好处是,分割后的每个文件都是完整的行,对于后续的文本处理非常方便。但缺点是,如果行特别长,或者文件行数极其庞大,性能可能不如固定字节块分割。而且,如果你处理的是二进制文件,这种方法就完全不适用了。

如何有效合并这些分割文件? 合并其实比分割简单多了,就是把所有分片文件按照正确的顺序,依次追加写入到一个新的目标文件里。

<?php

function mergeSplitFiles(array $partFilePaths, string $destinationFilePath): bool

{

if (empty($partFilePaths)) {

return false;

}

// 确保目标文件可写。如果目标文件已存在,会被覆盖。

$destinationFileHandle = fopen($destinationFilePath, 'wb'); // 'wb' 二进制写入,覆盖

if (!$destinationFileHandle) {

throw new \RuntimeException("无法创建或打开目标文件进行合并: {$destinationFilePath}");

}

foreach ($partFilePaths as $partFilePath) {

if (!file_exists($partFilePath) || !is_readable($partFilePath)) {

fclose($destinationFileHandle);

throw new \InvalidArgumentException("分片文件不存在或不可读: {$partFilePath}");

}

$partFileHandle = fopen($partFilePath, 'rb'); // 'rb' 二进制读取

if (!$partFileHandle) {

fclose($destinationFileHandle);

throw new \RuntimeException("无法打开分片文件进行读取: {$partFilePath}");

}

// 再次使用 fread/fwrite 模式,避免将整个分片文件载入内存

while (!feof($partFileHandle)) {

$buffer = fread($partFileHandle, 1024 * 1024 * 4); // 再次使用一个缓冲区,比如4MB

if ($buffer === false) {

fclose($partFileHandle);

fclose($destinationFileHandle);

throw new \RuntimeException("从分片文件读取数据失败: {$partFilePath}");

}

if (empty($buffer)) {

break;

}

$bytesWritten = fwrite($destinationFileHandle, $buffer);

if ($bytesWritten === false || $bytesWritten < strlen($buffer)) {

fclose($partFileHandle);

fclose($destinationFileHandle);

throw new \RuntimeException("写入目标文件失败或不完整: {$destinationFilePath}");

}

}

fclose($partFileHandle); // 关闭当前分片文件

}

fclose($destinationFileHandle); // 关闭目标文件

return true;

}

// 示例用法:

// 假设 $splitFiles 是之前分割函数返回的数组,并且是按顺序的

// $mergedFilePath = '/path/to/your/merged_file.zip';

// try {

// $success = mergeSplitFiles($splitFiles, $mergedFilePath);

// if ($success) {

// echo "文件合并成功: " . $mergedFilePath . "\n";

// }

// } catch (\Exception $e) {

// echo "文件合并失败: " . $e->getMessage() . "\n";

// }

?>关键点在于顺序:合并时必须严格按照分割时的顺序来追加。如果你的分片文件名是file.part0000、file.part0001这样的,那么直接按字符串排序就能保证顺序。如果文件名不规范,那就需要在分割时额外记录分片文件的顺序。另外,合并操作也应该使用流式处理,避免将整个分片文件一次性载入内存,尤其是当单个分片文件本身也比较大时。

在PHP大文件分割过程中,如何处理异常情况和确保数据完整性?

处理异常情况和确保数据完整性,这在任何文件操作中都至关重要,大文件分割尤其如此,因为一旦出错,代价可能很大。我的经验是,要从几个方面着手:

预检查与前置条件:

- 文件存在与可读性:在开始分割前,务必检查源文件是否存在并且可读。

file_exists()和is_readable()是你的朋友。 - 目标目录可写性:确保目标目录存在且可写。如果不存在,可以尝试用

mkdir($directory, 0755, true)创建,并检查创建是否成功。 - 参数有效性:比如

$chunkSize是否为正整数。 这些检查可以尽早发现问题,避免在操作进行到一半时才失败。

- 文件存在与可读性:在开始分割前,务必检查源文件是否存在并且可读。

运行时错误处理:

- 文件句柄检查:

fopen()可能会失败(比如权限问题、文件路径错误),它会返回false。每次打开文件句柄后都应该检查其返回值。 - 读写操作检查:

fread()和fwrite()也可能失败。fread()失败返回false,fwrite()失败返回false或者写入的字节数小于预期。这些情况都需要捕获并处理。 try-catch块:将整个分割或合并逻辑包裹在try-catch块中,这样任何抛出的异常都能被捕获,然后你可以记录日志、清理临时文件,或者给用户一个友好的错误提示。我个人更倾向于在函数内部抛出更具体的异常,然后在调用层进行捕获和处理。

- 文件句柄检查:

数据完整性保障:

- 校验和(Checksum):这是确保数据完整性的黄金标准。在分割前,计算源文件的MD5或SHA1哈希值。分割并合并完成后,再计算合并后文件的哈希值,与源文件的哈希值进行比对。如果两者一致,那么恭喜你,数据在传输和处理过程中没有发生损坏或丢失。PHP有

md5_file()和sha1_file()函数可以方便地实现这一点。 - 临时文件清理:如果分割或合并过程中断(比如由于错误或超时),可能会留下部分或不完整的分片文件或合并文件。在

catch块中,或者在脚本结束时(比如通过register_shutdown_function),可以尝试清理这些遗留的临时文件,避免占用磁盘空间或造成混淆。 - 日志记录:无论是成功、失败还是警告,都应该详细记录日志。包括文件路径、错误信息、时间戳等。这对于后续的故障排查和审计至关重要。

- 校验和(Checksum):这是确保数据完整性的黄金标准。在分割前,计算源文件的MD5或SHA1哈希值。分割并合并完成后,再计算合并后文件的哈希值,与源文件的哈希值进行比对。如果两者一致,那么恭喜你,数据在传输和处理过程中没有发生损坏或丢失。PHP有

原子性考量(非必须但高级): 对于极度关键的数据,你可能需要考虑操作的原子性。也就是说,要么整个文件分割/合并成功,要么就好像什么都没发生过一样。这通常意味着在操作成功前,不要删除源文件,或者将最终合并的文件先写入一个临时位置,确认无误后再替换掉目标文件。不过对于大多数文件分割场景,上面的校验和和错误处理已经足够了。

总而言之,处理大文件,就得像对待精密仪器一样小心。多一点检查,多一点错误处理,多一点数据验证,才能让整个流程更加健壮可靠。

本篇关于《PHP大文件分割技巧与实现方法》的介绍就到此结束啦,但是学无止境,想要了解学习更多关于文章的相关知识,请关注golang学习网公众号!

废文网小说免费阅读入口推荐

废文网小说免费阅读入口推荐

- 上一篇

- 废文网小说免费阅读入口推荐

- 下一篇

- ToDesk彻底卸载与清理指南

-

- 文章 · php教程 | 6分钟前 |

- UPDATE语句返回NULL原因及解决方法

- 491浏览 收藏

-

- 文章 · php教程 | 8分钟前 |

- PHP反射机制详解与使用实例

- 201浏览 收藏

-

- 文章 · php教程 | 26分钟前 |

- PHP数组权重排序与评分实现技巧

- 316浏览 收藏

-

- 文章 · php教程 | 31分钟前 |

- cURL错误码60解决方法大全

- 351浏览 收藏

-

- 文章 · php教程 | 33分钟前 |

- 网页嵌入PHP链接失败AJAX调试方法

- 489浏览 收藏

-

- 文章 · php教程 | 34分钟前 |

- PHP分页类实现教程详解

- 234浏览 收藏

-

- 文章 · php教程 | 35分钟前 |

- PHP上传文件到服务器的完整步骤

- 229浏览 收藏

-

- 文章 · php教程 | 48分钟前 |

- 负载均衡原理与流量分发解析

- 437浏览 收藏

-

- 文章 · php教程 | 53分钟前 |

- PHP调用听书插件关闭自动播放技巧

- 448浏览 收藏

-

- 文章 · php教程 | 1小时前 |

- PHP安全漏洞与防御方法全解析

- 412浏览 收藏

-

- 文章 · php教程 | 1小时前 |

- PHP压缩文件夹教程:节省空间技巧

- 456浏览 收藏

-

- 文章 · php教程 | 1小时前 |

- OpenTBS图片替换失败?临时文件解决方法

- 482浏览 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 485次学习

-

- ChatExcel酷表

- ChatExcel酷表是由北京大学团队打造的Excel聊天机器人,用自然语言操控表格,简化数据处理,告别繁琐操作,提升工作效率!适用于学生、上班族及政府人员。

- 4128次使用

-

- Any绘本

- 探索Any绘本(anypicturebook.com/zh),一款开源免费的AI绘本创作工具,基于Google Gemini与Flux AI模型,让您轻松创作个性化绘本。适用于家庭、教育、创作等多种场景,零门槛,高自由度,技术透明,本地可控。

- 4478次使用

-

- 可赞AI

- 可赞AI,AI驱动的办公可视化智能工具,助您轻松实现文本与可视化元素高效转化。无论是智能文档生成、多格式文本解析,还是一键生成专业图表、脑图、知识卡片,可赞AI都能让信息处理更清晰高效。覆盖数据汇报、会议纪要、内容营销等全场景,大幅提升办公效率,降低专业门槛,是您提升工作效率的得力助手。

- 4365次使用

-

- 星月写作

- 星月写作是国内首款聚焦中文网络小说创作的AI辅助工具,解决网文作者从构思到变现的全流程痛点。AI扫榜、专属模板、全链路适配,助力新人快速上手,资深作者效率倍增。

- 5875次使用

-

- MagicLight

- MagicLight.ai是全球首款叙事驱动型AI动画视频创作平台,专注于解决从故事想法到完整动画的全流程痛点。它通过自研AI模型,保障角色、风格、场景高度一致性,让零动画经验者也能高效产出专业级叙事内容。广泛适用于独立创作者、动画工作室、教育机构及企业营销,助您轻松实现创意落地与商业化。

- 4726次使用

-

- PHP技术的高薪回报与发展前景

- 2023-10-08 501浏览

-

- 基于 PHP 的商场优惠券系统开发中的常见问题解决方案

- 2023-10-05 501浏览

-

- 如何使用PHP开发简单的在线支付功能

- 2023-09-27 501浏览

-

- PHP消息队列开发指南:实现分布式缓存刷新器

- 2023-09-30 501浏览

-

- 如何在PHP微服务中实现分布式任务分配和调度

- 2023-10-04 501浏览