PHP内存不足怎么解决

PHP内存超限是常见问题,本文深入探讨了解决方法,并符合百度SEO优化。当PHP程序尝试使用超过配置允许的内存时,便会触发此错误。解决该问题的核心在于**调整`memory_limit`配置**以及**优化代码**,双管齐下。除了临时调高`memory_limit`外,更应着重于代码优化,避免一次性加载大量数据,采用分批处理和生成器`yield`;及时`unset`大变量;减少不必要的变量复制;优化数据库查询,只取所需字段并分页。利用`memory_get_usage()`和Xdebug等工具精准定位内存消耗点,警惕盲目增加内存限制、误解`unset`效果等常见误区。本文旨在帮助开发者从代码逻辑和数据处理方式上提升内存效率,避免PHP内存超限错误。

解决PHP内存超出限制错误需调整memory_limit配置并优化代码。首先可临时调高memory_limit,但根本在于优化内存使用:避免一次性加载大量数据,改用分批处理和生成器yield;及时unset大变量;减少不必要的变量复制;优化数据库查询,只取所需字段并分页;利用memory_get_usage()和Xdebug等工具定位内存消耗点;警惕盲目增加内存限制、误解unset效果等常见误区,重点从代码逻辑和数据处理方式上提升内存效率。

PHP遇到内存占用超出限制的致命错误,通常是你的程序尝试使用超过系统或配置允许的内存量。解决这个问题,核心在于两点:一是适当调整PHP的内存限制配置,二是更关键地,优化你的代码,让它更高效地利用内存。很多时候,我们发现问题出在代码处理大量数据或循环不当上。

解决方案

解决PHP内存占用超出限制的错误,我通常会从配置和代码两个层面入手,这就像是给水管加粗并检查水龙头有没有漏水。

首先,最直接但也最治标不治本的方法是调整memory_limit。你可以在php.ini文件中找到这一项,比如memory_limit = 128M。如果你的应用确实需要更多内存(比如处理大型图片、复杂报表),可以适当调高,比如到256M或512M。但要注意,这会影响服务器上所有PHP进程的内存分配,设得太高可能导致服务器资源耗尽。

另一种临时调整方法是在你的脚本开头用ini_set('memory_limit', '256M');,但这种方式可能会被服务器配置限制,而且不推荐作为长期解决方案,因为它掩盖了潜在的代码问题。对于Apache服务器,你也可以在.htaccess文件中设置php_value memory_limit 256M。

然而,更根本的解决之道在于代码优化。这才是我们应该花大力气的地方。我见过太多案例,一味提高内存限制,结果只是把问题延后,甚至导致服务器整体性能下降。

考虑你的代码是如何处理数据的:

大数据集处理: 如果你从数据库一次性查询出几十万条记录,然后全部加载到内存中处理,那几乎肯定会内存溢出。这时候,分批处理(batch processing)是王道。比如,每次只查询和处理1000条记录,处理完一批再查询下一批。

使用生成器(Generators): PHP的

yield关键字是处理大型迭代的利器。它允许你按需生成值,而不是一次性生成所有值并存储在内存中。这对于处理大型文件或数据库结果集特别有效。function readLargeFile($filename) { $handle = fopen($filename, 'r'); if ($handle) { while (($line = fgets($handle)) !== false) { yield $line; // 每次只返回一行,而不是整个文件 } fclose($handle); } } foreach (readLargeFile('very_large_log.txt') as $line) { // 处理每一行,内存占用保持恒定 }及时释放变量: 当一个大变量不再需要时,使用

unset()来销毁它。这会立即释放变量占用的内存,让PHP的垃圾回收机制有机会回收这部分内存。尤其是在循环内部处理大对象时,这一点非常重要。foreach ($largeDataSet as $key => $data) { // 处理 $data // ... unset($largeDataSet[$key]); // 及时释放 }避免不必要的复制: PHP在某些操作中会进行变量复制。了解传值和传引用的区别,尽量避免不必要的深拷贝,尤其是在函数参数传递时。

数据库查询优化: 只选择你需要的字段,而不是

SELECT *。使用LIMIT和OFFSET进行分页查询。对于非常大的结果集,考虑使用数据库游标(如果你的数据库和PHP驱动支持)。

如何精准定位PHP内存溢出的具体原因?

当PHP抛出内存超限错误时,它通常会告诉你是在哪个文件哪一行出的错。但这只是一个表象,真正的“元凶”可能隐藏在更深的代码逻辑里。要精准定位,我通常会结合几种方法:

首先,看错误日志。PHP的错误日志(通常是php_error.log或web服务器的错误日志)会记录内存溢出的具体信息,包括文件路径和行号。这是最直接的线索,它告诉你内存耗尽发生在哪里。但记住,这只是“案发现场”,不是“犯罪动机”。

其次,使用内存分析工具。Xdebug是一个非常强大的PHP调试器和分析器。配置Xdebug后,你可以生成内存使用报告(cachegrind文件),然后用KCachegrind或Webgrind等工具打开分析。这些工具能可视化地展示函数调用栈以及每个函数消耗的内存,让你一眼看出哪些函数是内存大户。这就像是给程序做CT扫描,能看到内存到底被谁吃掉了。

; php.ini 配置 Xdebug for profiling xdebug.mode = develop,profile xdebug.start_with_request = yes xdebug.output_dir = /tmp/xdebug_profiles xdebug.filename_template = cachegrind.out.%p

再者,手动埋点memory_get_usage()和memory_get_peak_usage()。在代码的关键路径或可能耗内存的地方,插入这两个函数来打印当前内存使用量和峰值内存使用量。通过对比不同阶段的内存值,你可以大致判断是哪个代码块导致了内存飙升。这虽然有点原始,但对于快速定位小范围问题非常有效。

echo 'Start: ' . round(memory_get_usage() / 1024 / 1024, 2) . 'MB' . PHP_EOL; // 假设这里有一段可能耗内存的代码 $largeArray = range(0, 1000000); echo 'After array: ' . round(memory_get_usage() / 1024 / 1024, 2) . 'MB' . PHP_EOL; echo 'Peak usage: ' . round(memory_get_peak_usage() / 1024 / 1024, 2) . 'MB' . PHP_EOL; unset($largeArray); echo 'After unset: ' . round(memory_get_usage() / 1024 / 1024, 2) . 'MB' . PHP_EOL;

最后,代码审查和逻辑分析。有时候,内存问题并非由单个函数引起,而是由一系列操作的累积效应。比如,在一个循环里不断地创建对象,却没有及时销毁;或者递归函数没有正确的终止条件,导致无限递归。这时候,就需要人工审查代码,结合业务逻辑,找出那些可能导致内存累积的“陷阱”。这需要经验,也需要对业务流程有深入的理解。

除了增加内存限制,还有哪些PHP代码层面的优化策略?

在PHP应用中,尤其是在处理大数据量时,仅仅依赖增加内存限制是远远不够的,甚至可以说是一种逃避。真正的优化应该深入到代码层面,让程序本身变得更“节俭”。我个人觉得,以下几种策略是除了调整memory_limit之外,最值得投入精力的:

1. 利用生成器(Generators)进行按需迭代:

这是我处理大文件或数据库结果集时最常用的方法。传统的做法是把所有数据一次性读入内存,比如file_get_contents()或fetchAll()。但当文件有几个G,或者数据库结果有几十万条时,内存肯定爆掉。生成器允许你定义一个迭代器,它在每次迭代时才计算并返回一个值,而不是预先生成所有值。这样,无论数据集多大,内存占用都能保持在一个很低的水平。

// 例子:处理一个巨大的CSV文件,一行一行处理

function processCsvRows($filePath) {

$handle = fopen($filePath, 'r');

if ($handle === false) {

throw new Exception("Cannot open CSV file.");

}

while (($data = fgetcsv($handle)) !== false) {

yield $data; // 每次只返回一行数据

}

fclose($handle);

}

// 使用生成器处理数据,内存占用恒定

foreach (processCsvRows('path/to/large.csv') as $row) {

// 处理 $row,例如插入数据库或进行计算

}2. 分批处理(Batch Processing): 对于需要处理大量数据的任务,比如数据迁移、报表生成、邮件群发等,一次性处理往往是不现实的。分批处理的核心思想是将大任务拆分成多个小任务,每个小任务处理一部分数据。这通常结合队列系统(如RabbitMQ, Redis Queue)或定时任务(Cron Job)来实现。

例如,你需要处理100万用户的数据:

- 不是一次性查询100万用户。

- 而是查询前1000个用户,处理完。

- 再查询接下来的1000个用户,处理完。

- 直到所有用户处理完毕。

这在循环中可以通过LIMIT和OFFSET来实现,或者通过记录上次处理到的ID来避免OFFSET带来的性能问题。

3. 及时unset()不再使用的变量:

虽然PHP有垃圾回收机制,但对于大型变量或对象,手动unset()可以更早地释放内存。尤其是在长生命周期的脚本(如常驻内存的服务、长时间运行的CLI脚本)或大型循环中,这一点尤为重要。unset()会立即解除变量名与内存地址的关联,使得这部分内存可以被回收。

4. 避免不必要的变量复制和深拷贝:

PHP在函数传参时默认是传值,这意味着会将变量复制一份。对于大型数组或对象,这会造成额外的内存开销。如果函数内部不需要修改原始变量,或者修改了也希望影响原始变量,可以考虑使用引用传递function(&$param)。但要注意,引用传递会增加代码的复杂性和潜在的副作用,要慎用。

5. 优化数据库查询: 数据库是内存消耗的常见源头。

- 只查询所需字段: 避免

SELECT *。只选择你需要的列,可以显著减少从数据库传输到PHP脚本的数据量。 - 合理使用索引: 优化查询性能,减少数据库在内存中处理数据的时间和空间。

- 分页查询: 结合

LIMIT和OFFSET,或者基于游标(cursor)/上次处理ID的查询,避免一次性加载大量结果集。

6. 使用更内存高效的数据结构:

在PHP中,普通的数组非常灵活,但有时也比较耗内存。如果你知道数组的大小是固定的,并且只存储特定类型的数据,可以考虑使用SPL(Standard PHP Library)提供的一些数据结构,如SplFixedArray,它在内存使用上可能比普通PHP数组更高效。但这通常是微优化,除非你确定内存是瓶颈。

PHP内存管理中常见的误区有哪些?

在处理PHP内存问题时,我发现大家经常会掉进一些“坑”里。这些误区不仅可能导致问题无法解决,甚至会引入新的性能瓶颈或安全风险。

1. 盲目提高memory_limit:

这是最常见也最危险的误区。很多人一看到内存溢出,第一反应就是把memory_limit从128M改成256M,甚至512M、1G。这就像是家里水管漏水,不是去修水管,而是直接加大水泵功率。短期内可能看似解决了问题,但长期来看,它掩盖了代码层面的真正问题。如果你的代码确实存在内存泄露,或者处理逻辑不当,无限提高内存限制只会让服务器资源被耗尽,导致所有PHP进程变慢,甚至服务器崩溃。正确的做法是,先分析内存消耗,确认是合理需求还是代码问题。

2. 误解unset()的即时效果:

很多人认为unset($var)会立即释放内存。在大多数情况下,它确实会解除变量与内存的关联,使得这部分内存可以被PHP的垃圾回收器回收。但是,这并不意味着内存会立即返还给操作系统。PHP的垃圾回收机制是周期性运行的,或者在内存压力达到一定程度时才触发。而且,如果变量被其他变量引用(引用计数不为0),或者存在循环引用,unset()可能并不能立即释放内存。所以,不要过度依赖unset()来做精细的内存控制,它更多是帮助垃圾回收器更快地识别可回收内存。

3. 忽视第三方库和框架的内存消耗: 我们开发应用时,大量依赖Composer包和各种框架(如Laravel, Symfony)。这些库和框架本身会占用一定的内存。如果你的应用内存占用很高,除了自己写的业务代码,也需要考虑是不是某些库在特定操作时消耗了大量内存。例如,某些ORM在加载大量关联数据时,可能会一次性构建非常复杂的对象图,导致内存飙升。这时候,你需要了解这些库的内部机制,或者寻找更轻量级的替代方案,或者优化它们的配置。

4. 不区分实际内存使用和峰值内存使用:memory_get_usage()和memory_get_peak_usage()是两个不同的概念。memory_get_usage()返回的是当前脚本分配的内存量,而memory_get_peak_usage()返回的是脚本执行过程中消耗的内存峰值。内存溢出通常是由于峰值内存超过限制。在分析问题时,只看当前内存使用量可能会误导你,因为有些操作(比如大型数组的创建)可能在短时间内造成内存峰值,操作结束后内存又降下来,但这个峰值已经足够触发错误了。

5. 过度优化或微优化: 有时候,为了追求极致的内存效率,开发者可能会进行一些过度复杂的优化,比如使用位运算、或者手写一些非常底层的数据结构。这些“微优化”往往会大大增加代码的复杂性和可读性,但对整体内存的改善可能微乎其微。更重要的是,过早的优化是万恶之源。你应该把精力放在那些真正能带来巨大收益的地方,比如处理大数据集的方式、数据库查询效率等,而不是纠结于每个变量的字节数。

6. 忽略PHP版本和环境差异: 不同的PHP版本对内存的管理方式可能有所优化或变化。例如,PHP 7系列相比PHP 5系列在内存效率上有显著提升。此外,不同的SAPI(如Apache的mod_php、FPM、CLI)以及不同的操作系统,其内存分配和回收行为也可能存在细微差异。因此,在排查问题时,确保你在生产环境和开发环境使用相同的PHP版本和配置,并考虑到环境因素可能带来的影响。

以上就是本文的全部内容了,是否有顺利帮助你解决问题?若是能给你带来学习上的帮助,请大家多多支持golang学习网!更多关于文章的相关知识,也可关注golang学习网公众号。

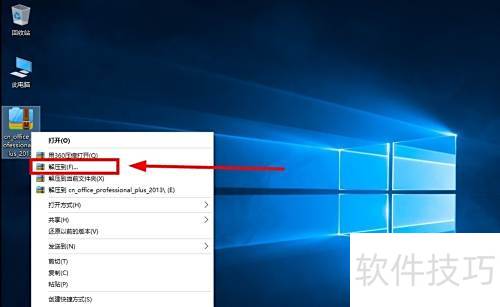

Win10安装Office2013步骤详解

Win10安装Office2013步骤详解

- 上一篇

- Win10安装Office2013步骤详解

- 下一篇

- BOM画中画功能怎么开启?

-

- 文章 · php教程 | 3分钟前 | php递归函数教程

- PHP递归优化数据库查询技巧

- 500浏览 收藏

-

- 文章 · php教程 | 30分钟前 |

- PHP实现POST断点续传技巧解析

- 162浏览 收藏

-

- 文章 · php教程 | 35分钟前 |

- PHP代码审计关键点与安全解析

- 292浏览 收藏

-

- 文章 · php教程 | 37分钟前 |

- 防止PHPINFO被访问的实用方法

- 296浏览 收藏

-

- 文章 · php教程 | 53分钟前 |

- PHP上传文件到服务器完整教程

- 204浏览 收藏

-

- 文章 · php教程 | 57分钟前 |

- PHP递归获取对象嵌套属性技巧

- 301浏览 收藏

-

- 文章 · php教程 | 1小时前 |

- PHP枚举标志组合方法详解

- 461浏览 收藏

-

- 文章 · php教程 | 1小时前 | PHP框架

- PHP框架构建RESTfulAPI与路由设计详解

- 450浏览 收藏

-

- 文章 · php教程 | 1小时前 |

- PHP日期格式Y-m-dH:i:s详解

- 199浏览 收藏

-

- 文章 · php教程 | 1小时前 | php 折线图

- PHP折线图绘制教程及JpGraph使用详解

- 320浏览 收藏

-

- 文章 · php教程 | 2小时前 |

- ThinkPHP验证码生成与验证教程

- 372浏览 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 485次学习

-

- ChatExcel酷表

- ChatExcel酷表是由北京大学团队打造的Excel聊天机器人,用自然语言操控表格,简化数据处理,告别繁琐操作,提升工作效率!适用于学生、上班族及政府人员。

- 4128次使用

-

- Any绘本

- 探索Any绘本(anypicturebook.com/zh),一款开源免费的AI绘本创作工具,基于Google Gemini与Flux AI模型,让您轻松创作个性化绘本。适用于家庭、教育、创作等多种场景,零门槛,高自由度,技术透明,本地可控。

- 4479次使用

-

- 可赞AI

- 可赞AI,AI驱动的办公可视化智能工具,助您轻松实现文本与可视化元素高效转化。无论是智能文档生成、多格式文本解析,还是一键生成专业图表、脑图、知识卡片,可赞AI都能让信息处理更清晰高效。覆盖数据汇报、会议纪要、内容营销等全场景,大幅提升办公效率,降低专业门槛,是您提升工作效率的得力助手。

- 4365次使用

-

- 星月写作

- 星月写作是国内首款聚焦中文网络小说创作的AI辅助工具,解决网文作者从构思到变现的全流程痛点。AI扫榜、专属模板、全链路适配,助力新人快速上手,资深作者效率倍增。

- 5880次使用

-

- MagicLight

- MagicLight.ai是全球首款叙事驱动型AI动画视频创作平台,专注于解决从故事想法到完整动画的全流程痛点。它通过自研AI模型,保障角色、风格、场景高度一致性,让零动画经验者也能高效产出专业级叙事内容。广泛适用于独立创作者、动画工作室、教育机构及企业营销,助您轻松实现创意落地与商业化。

- 4726次使用

-

- PHP技术的高薪回报与发展前景

- 2023-10-08 501浏览

-

- 基于 PHP 的商场优惠券系统开发中的常见问题解决方案

- 2023-10-05 501浏览

-

- 如何使用PHP开发简单的在线支付功能

- 2023-09-27 501浏览

-

- PHP消息队列开发指南:实现分布式缓存刷新器

- 2023-09-30 501浏览

-

- 如何在PHP微服务中实现分布式任务分配和调度

- 2023-10-04 501浏览