像Flink一样使用Redis

编程并不是一个机械性的工作,而是需要有思考,有创新的工作,语法是固定的,但解决问题的思路则是依靠人的思维,这就需要我们坚持学习和更新自己的知识。今天golang学习网就整理分享《像Flink一样使用Redis》,文章讲解的知识点主要包括Redis、NoSQL、flink,如果你对数据库方面的知识点感兴趣,就不要错过golang学习网,在这可以对大家的知识积累有所帮助,助力开发能力的提升。

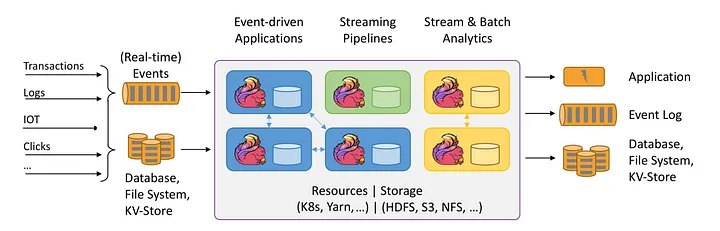

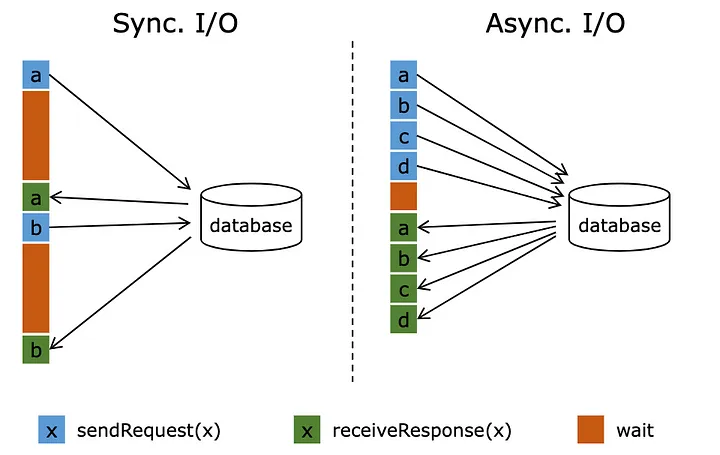

Apache Flink和 Redis 是两个强大的工具,可以一起使用来构建可以处理大量数据的实时数据处理管道。Flink 为处理数据流提供了一个高度可扩展和容错的平台,而 Redis 提供了一个高性能的内存数据库,可用于存储和查询数据。在本文中,将探讨如何使用 Flink 来使用异步函数调用 Redis,并展示如何使用它以非阻塞方式将数据推送到 Redis。

Redis的故事

“Redis:不仅仅是一个缓存

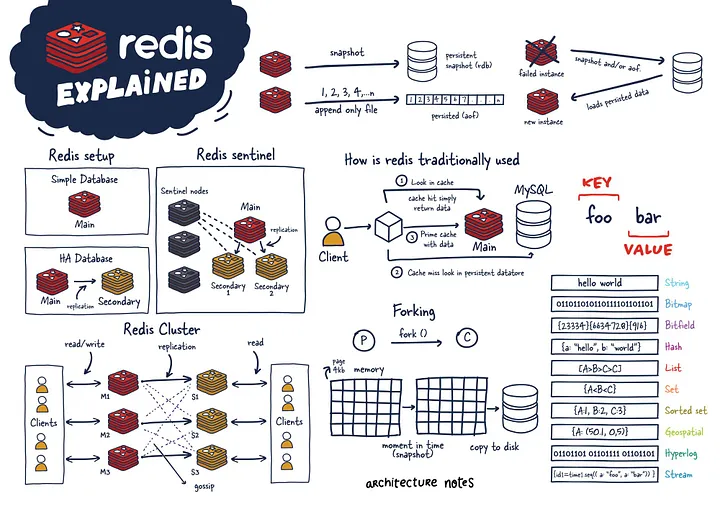

Redis 是一种功能强大的 NoSQL 内存数据结构存储,已成为开发人员的首选工具。虽然它通常被认为只是一个缓存,但 Redis 远不止于此。它可以作为数据库、消息代理和缓存三者合一。

Redis 的优势之一是它的多功能性。它支持各种数据类型,包括字符串、列表、集合、有序集合、哈希、流、HyperLogLogs 和位图。Redis 还提供地理空间索引和半径查询,使其成为基于位置的应用程序的宝贵工具。

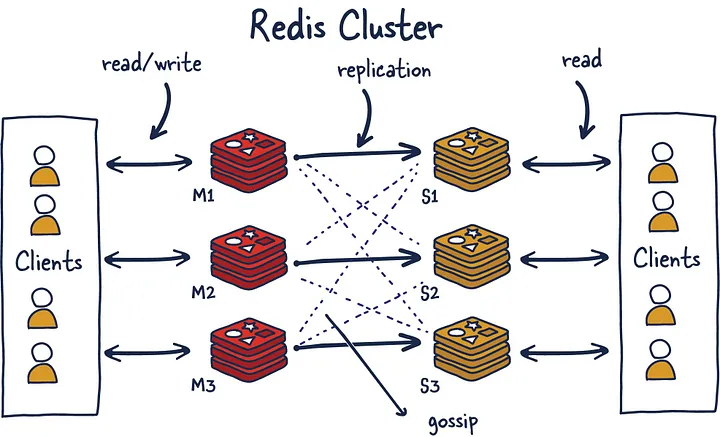

Redis 的功能超出了它的数据模型。它具有内置的复制、Lua 脚本和事务,并且可以使用 Redis Cluster 自动分区数据。此外,Redis 通过 Redis Sentinel 提供高可用性。

注意:在本文中,将更多地关注Redis集群模式

Redis 集群使用带哈希槽的算法分片来确定哪个分片拥有给定的键并简化添加新实例的过程。同时,它使用 Gossiping 来确定集群的健康状况,如果主节点没有响应,可以提升辅助节点以保持集群健康。必须有奇数个主节点和两个副本才能进行稳健设置,以避免脑裂现象(集群无法决定提升谁并最终做出分裂决定)

为了与 Redis 集群对话,将使用lettuce和 Redis Async Java 客户端。

Flink 的故事

Apache Flink 是一个开源、统一的流处理和批处理框架,旨在处理实时、高吞吐量和容错数据处理。它建立在 Apache Gelly 框架之上,旨在支持有界和无界流上的复杂事件处理和有状态计算,它的快速之处在于其利用内存中性能和异步检查本地状态。

故事的主人公

与数据库的异步交互是流处理应用程序的游戏规则改变者。通过这种方法,单个函数实例可以同时处理多个请求,从而允许并发响应并显着提高吞吐量。通过将等待时间与其他请求和响应重叠,处理管道变得更加高效。

我们将以电商数据为例,计算24小时滑动窗口中每个品类的销售额,滑动时间为30秒,下沉到Redis,以便更快地查找下游服务。

充足的数据集

Category, TimeStamp

Electronics,1679832334

Furniture,1679832336

Fashion,1679832378

Food,16798323536

Flink Kafka 消费者类

package Aysnc_kafka_redis; Redis 设置键异步 I/0 运算符 package AsyncIO; 以上就是本文的全部内容了,是否有顺利帮助你解决问题?若是能给你带来学习上的帮助,请大家多多支持golang学习网!更多关于数据库的相关知识,也可关注golang学习网公众号。

import AsyncIO.RedisSink;

import akka.japi.tuple.Tuple3;

import deserializer.Ecommdeserialize;

import model.Ecomm;

import org.apache.flink.api.common.eventtime.WatermarkStrategy;

import org.apache.flink.connector.kafka.source.KafkaSource;

import org.apache.flink.connector.kafka.source.enumerator.initializer.OffsetsInitializer;

import org.apache.flink.streaming.api.datastream.AsyncDataStream;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.datastream.SingleOutputStreamOperator;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.timestamps.BoundedOutOfOrdernessTimestampExtractor;

import org.apache.flink.streaming.api.functions.windowing.WindowFunction;

import org.apache.flink.streaming.api.windowing.assigners.TumblingEventTimeWindows;

import org.apache.flink.streaming.api.windowing.time.Time;

import org.apache.flink.streaming.api.windowing.windows.TimeWindow;

import org.apache.flink.util.Collector;

import java.util.concurrent.TimeUnit;

public class FlinkAsyncRedis {

public static void main(String[] args) throws Exception {

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

Ecommdeserialize jsonde = new Ecommdeserialize();

KafkaSourceEcomm> source = KafkaSource.Ecomm>builder()

.setTopics("{dummytopic}")

.setBootstrapServers("{dummybootstrap}")

.setGroupId("test_flink")

.setStartingOffsets(OffsetsInitializer.earliest())

.setValueOnlyDeserializer(jsonde)

.build();

DataStreamEcomm> orderData = env.fromSource(source, WatermarkStrategy.noWatermarks(), "Kafka Source");

orderData.assignTimestampsAndWatermarks(new BoundedOutOfOrdernessTimestampExtractorEcomm>(Time.seconds(10)) {

@Override

public long extractTimestamp(Ecomm element) {

return element.getEventTimestamp(); // extract watermark column from stream

}

});

SingleOutputStreamOperatorTuple3String, Long, Long>> aggregatedData = orderData.keyBy(Ecomm::getCategory)

.window(SlidingEventTimeWindows.of(Time.hours(24),Time.seconds(30)))

.apply((WindowFunctionEcomm, Tuple3String, Long, Long>, String, TimeWindow>) (key, window, input, out) -> {

long count = 0;

for (Ecomm event : input) {

count++; // increment the count for each event in the window

}

out.collect(new Tuple3(key, window.getEnd(), count)); // output the category, window end time, and count

});

// calling async I/0 operator to sink data to redis in UnOrdered way

SingleOutputStreamOperatorString> sinkResults = AsyncDataStream.unorderedWait(aggregatedData,new RedisSink(

"{redisClusterUrl}"),

1000, // the timeout defines how long an asynchronous operation take before it is finally considered failed

TimeUnit.MILLISECONDS,

100); //capacity This parameter defines how many asynchronous requests may be in progress at the same time.

sinkResults.print(); // print out the redis set response stored in the future for every key

env.execute("RedisAsyncSink"); // you will be able to see your job running on cluster by this name

}

}

import akka.japi.tuple.Tuple3;

import io.lettuce.core.RedisFuture;

import io.lettuce.core.cluster.RedisClusterClient;

import io.lettuce.core.cluster.api.StatefulRedisClusterConnection;

import io.lettuce.core.cluster.api.async.RedisAdvancedClusterAsyncCommands;

import lombok.AllArgsConstructor;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.configuration.Configuration;

import org.apache.flink.streaming.api.functions.async.ResultFuture;

import org.apache.flink.streaming.api.functions.async.RichAsyncFunction;

import scala.collection.immutable.List;

import java.util.ArrayList;

import java.util.Collections;

@AllArgsConstructor

public class RedisSink extends RichAsyncFunctionTuple3String, Long, Long>, String> {

String redisUrl;

public RedisSink(String redisUrl){

this.redisUrl=redisUrl;

}

private transient RedisClusterClient client = null;

private transient StatefulRedisClusterConnectionString, String> clusterConnection = null;

private transient RedisAdvancedClusterAsyncCommandsString, String> asyncCall = null;

// method executes any operator-specific initialization

@Override

public void open(Configuration parameters) {

if (client == null ) {

client = RedisClusterClient.create(redisUrl);

}

if (clusterConnection == null) {

clusterConnection = client.connect();

}

if (asyncCall == null) {

asyncCall = clusterConnection.async();

}

}

// core logic to set key in redis using async connection and return result of the call via ResultFuture

@Override

public void asyncInvoke(Tuple3String, Long, Long> stream, ResultFutureString> resultFuture) {

String productKey = stream.t1();

System.out.println("RedisKey:" + productKey); //for logging

String count = stream.t3().toString();

System.out.println("Redisvalue:" + count); //for logging

RedisFutureString> setResult = asyncCall.set(productKey,count);

setResult.whenComplete((result, throwable) -> {if(throwable!=null){

System.out.println("Callback from redis failed:" + throwable);

resultFuture.complete(new ArrayList());

}

else{

resultFuture.complete(new ArrayList(Collections.singleton(result)));

}});

}

// method closes what was opened during initialization to free any resources

// held by the operator (e.g. open network connections, io streams)

@Override

public void close() throws Exception {

client.close();

}

}用例:

要点:

golang切片是按值传递的吗?

golang切片是按值传递的吗?

- 上一篇

- golang切片是按值传递的吗?

- 下一篇

- 如何在Redis中执行Lua脚本?

-

- 数据库 · Redis | 2星期前 |

- 多租户Redis安全隔离方法详解

- 308浏览 收藏

-

- 数据库 · Redis | 2星期前 |

- Redis性能问题分析与常见原因解析

- 230浏览 收藏

-

- 数据库 · Redis | 2星期前 |

- Redis事务的4个实现步骤解析

- 349浏览 收藏

-

- 数据库 · Redis | 1个月前 |

- Redis哨兵高可用配置详解

- 467浏览 收藏

-

- 数据库 · Redis | 1个月前 |

- Redis哈希应用技巧与实战解析

- 387浏览 收藏

-

- 数据库 · Redis | 1个月前 |

- Redis与Memcached区别详解及选型建议

- 256浏览 收藏

-

- 数据库 · Redis | 1个月前 |

- Redis安全日志开启与查看方法

- 421浏览 收藏

-

- 数据库 · Redis | 1个月前 |

- Redis集群数据分片原理详解

- 282浏览 收藏

-

- 数据库 · Redis | 2个月前 |

- RedisSet去重原理与使用方法

- 391浏览 收藏

-

- 数据库 · Redis | 2个月前 |

- Redis崩溃后重启与数据恢复方法

- 189浏览 收藏

-

- 数据库 · Redis | 2个月前 |

- Redis主从复制配置与搭建教程

- 146浏览 收藏

-

- 数据库 · Redis | 2个月前 |

- Redis与Elasticsearch协同使用技巧

- 327浏览 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 485次学习

-

- ChatExcel酷表

- ChatExcel酷表是由北京大学团队打造的Excel聊天机器人,用自然语言操控表格,简化数据处理,告别繁琐操作,提升工作效率!适用于学生、上班族及政府人员。

- 4104次使用

-

- Any绘本

- 探索Any绘本(anypicturebook.com/zh),一款开源免费的AI绘本创作工具,基于Google Gemini与Flux AI模型,让您轻松创作个性化绘本。适用于家庭、教育、创作等多种场景,零门槛,高自由度,技术透明,本地可控。

- 4453次使用

-

- 可赞AI

- 可赞AI,AI驱动的办公可视化智能工具,助您轻松实现文本与可视化元素高效转化。无论是智能文档生成、多格式文本解析,还是一键生成专业图表、脑图、知识卡片,可赞AI都能让信息处理更清晰高效。覆盖数据汇报、会议纪要、内容营销等全场景,大幅提升办公效率,降低专业门槛,是您提升工作效率的得力助手。

- 4340次使用

-

- 星月写作

- 星月写作是国内首款聚焦中文网络小说创作的AI辅助工具,解决网文作者从构思到变现的全流程痛点。AI扫榜、专属模板、全链路适配,助力新人快速上手,资深作者效率倍增。

- 5804次使用

-

- MagicLight

- MagicLight.ai是全球首款叙事驱动型AI动画视频创作平台,专注于解决从故事想法到完整动画的全流程痛点。它通过自研AI模型,保障角色、风格、场景高度一致性,让零动画经验者也能高效产出专业级叙事内容。广泛适用于独立创作者、动画工作室、教育机构及企业营销,助您轻松实现创意落地与商业化。

- 4699次使用

-

- 分享Redis高可用架构设计实践

- 2023-01-24 286浏览

-

- Go与Redis实现分布式互斥锁和红锁

- 2022-12-22 117浏览

-

- Redis的各项功能解决了哪些问题?

- 2023-02-18 185浏览

-

- Go+Redis实现延迟队列实操

- 2023-02-23 426浏览

-

- 分享 echo-framework 项目基础框架

- 2023-01-11 134浏览