PHP+AI写作机器人搭建教程

学习知识要善于思考,思考,再思考!今天golang学习网小编就给大家带来《PHP+AI内容生成,批量写作机器人搭建教程》,以下内容主要包含等知识点,如果你正在学习或准备学习文章,就都不要错过本文啦~让我们一起来看看吧,能帮助到你就更好了!

在PHP中集成AI构建批量写作机器人是可行且高效的,其核心在于整合PHP后端能力与AI生成模型,形成自动化内容生产流程。1. 选择合适的AI模型,如OpenAI GPT、Google Gemini或开源模型,依据内容质量、成本和集成难度进行权衡;2. 封装AI接口,使用PHP类管理API调用逻辑,包括认证、请求构建与响应处理;3. 实施Prompt工程,构建可复用、可配置的模板系统,存储于数据库以支持灵活管理;4. 引入任务队列(如Redis或RabbitMQ)实现异步处理,避免同步调用导致的性能瓶颈;5. 持久化存储生成内容、Prompt与任务状态,便于后续处理与分析;6. 内容后处理与质检,通过PHP脚本进行格式转换、清洗,并设置人工审核环节确保质量;7. 建立完善的错误处理机制与日志系统,保障系统稳定运行;8. 优化性能与成本,采用并发请求、数据库优化、内存管理策略提升效率,同时通过精简Prompt、分级使用模型、缓存结果、自托管模型等方式降低AI调用费用。

在PHP中集成AI进行自动化内容生成,尤其是构建一个批量写作机器人,不仅是可行的,而且在当前的技术背景下,已经成为许多内容生产流程优化的核心策略。这本质上是将PHP强大的后端处理能力与AI模型的智能生成能力结合起来,实现从数据输入到内容输出的自动化闭环。

解决方案

搭建一个基于PHP的AI批量写作机器人,核心在于构建一个高效、可扩展的工作流,将AI模型的智能输出能力与PHP的系统集成优势发挥到极致。这不仅仅是简单的API调用,更涉及数据管理、任务调度、内容质控等多个层面。

首先,你需要选择一个合适的AI模型。目前主流的选择是基于云服务的API,例如OpenAI的GPT系列、Google的Gemini或者Anthropic的Claude。这些服务通常提供RESTful API接口,PHP可以通过HTTP客户端库(如Guzzle或原生的cURL)轻松与之交互。

核心步骤和技术考量:

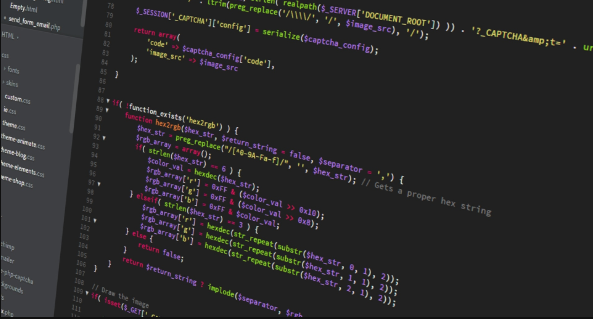

AI模型接口封装: 创建一个PHP类或服务,专门用于封装AI模型的API调用逻辑。这包括设置API密钥、构建请求体(包含prompt、模型参数如

temperature、max_tokens等)、发送请求、解析响应。

// 概念性代码,实际需用Guzzle等库处理HTTP请求 class AiContentGenerator { private $apiKey; private $endpoint; public function __construct($apiKey, $endpoint) { $this->apiKey = $apiKey; $this->endpoint = $endpoint; } public function generateText(string $prompt, array $options = []): ?string { $headers = [ 'Content-Type: application/json', 'Authorization: Bearer ' . $this->apiKey, ]; $data = [ 'model' => $options['model'] ?? 'gpt-4', 'messages' => [['role' => 'user', 'content' => $prompt]], 'temperature' => $options['temperature'] ?? 0.7, 'max_tokens' => $options['max_tokens'] ?? 1000, ]; // 实际这里会使用GuzzleHttp\Client发送请求 // $client = new GuzzleHttp\Client(); // $response = $client->post($this->endpoint, ['headers' => $headers, 'json' => $data]); // return json_decode($response->getBody()->getContents())->choices[0]->message->content ?? null; // 简化示例,假设直接返回 return "这是AI根据你的提示生成的文本:".$prompt; } }Prompt工程与管理: 这是生成高质量内容的灵魂。你需要设计一套灵活的prompt模板系统,能够根据不同的内容需求(比如产品描述、博客文章、社交媒体文案)动态组装prompt。这些模板和可变参数可以存储在数据库中,方便管理和迭代。

任务队列与批量处理: 对于“批量写作”,直接在请求时同步调用AI API是不可取的,因为这会导致超时和资源阻塞。最佳实践是引入一个消息队列系统(如Redis作为队列驱动,或者RabbitMQ)。PHP应用将内容生成请求推送到队列,后台的PHP worker进程则异步地从队列中取出任务,调用AI API,并将结果存储到数据库。

数据存储与管理: 生成的内容、原始prompt、任务状态、甚至AI模型的响应日志都应该持久化存储在数据库中(MySQL, PostgreSQL等)。这便于后续的内容检索、编辑、发布和性能分析。

内容后处理与质检: AI生成的内容并非总是完美的,可能需要进行格式化、关键词密度调整、事实核查或人工校对。PHP可以编写脚本进行初步的后处理,例如Markdown转HTML、文本清洗等。对于关键内容,人工审核环节不可或缺。

错误处理与日志: API调用失败、AI返回异常、网络问题等都可能发生。完善的错误处理机制和详细的日志记录对于排查问题至关重要。

如何选择适合PHP集成的AI模型?

选择合适的AI模型是构建批量写作机器人的一个关键决策,它直接影响到内容的质量、生成效率以及运营成本。在我看来,这并非一个“一劳永逸”的答案,而是需要根据具体需求和资源进行权衡。

首先,要明确你的内容需求。如果你的内容偏向创意性、需要高度流畅和自然的语言,那么像OpenAI的GPT-4或Anthropic的Claude 3系列这样的大型语言模型(LLMs)无疑是首选。它们的理解能力和生成质量通常是最顶级的。但如果你的需求更偏向结构化数据填充、简单文本摘要或关键词扩展,那么一些更小、更专业的模型,甚至是一些开源模型经过微调后,可能就足够了,而且成本会低得多。

其次,考虑集成难度和维护成本。云服务提供商(如OpenAI、Google Cloud AI、AWS Bedrock)提供的API接口,通常有清晰的文档和稳定的服务,PHP通过简单的HTTP请求库就能快速集成。这种方式的优点是无需关心底层硬件和模型部署,即插即用,非常适合快速原型开发和中小规模应用。缺点是长期来看,API调用费用可能会随着内容生成量的增加而显著上升。

另一条路是使用开源模型,并自行部署。例如,你可以利用Hugging Face上大量的预训练模型,或者使用像Ollama、Llama.cpp这样的工具在本地或私有服务器上运行Meta的Llama系列、Mistral等模型。这种方式的优势在于拥有完全的数据控制权(对于敏感数据尤其重要),并且长期运营成本可能更低(主要是硬件和电力开销)。然而,它对技术栈的要求更高,需要你具备模型部署、GPU管理、性能优化等方面的知识,对于纯PHP开发者来说,可能需要额外学习或团队协作。

在我个人的经验中,如果项目初期预算有限且需要快速验证想法,我会倾向于从OpenAI这类API开始。它们提供的SDK和文档都非常友好,能让你快速看到效果。一旦项目规模扩大,内容生成量激增,或者对数据隐私有更高要求时,我会开始考虑将部分或全部任务迁移到自部署的开源模型上,这通常是一个分阶段优化的过程。毕竟,没有最好的模型,只有最适合你当前场景的模型。

批量写作机器人的核心挑战与应对策略?

搭建批量写作机器人,远不止调用API那么简单,它会遇到一系列真实世界的挑战。这些挑战往往是技术与内容质量控制的交织,需要我们深思熟虑并制定应对策略。

一个最直接的挑战是内容质量的波动性。AI模型,即使是最先进的,也可能产生“幻觉”(Hallucinations),即生成听起来合理但实际上是虚假或不准确的信息。此外,在批量生成时,内容可能会出现重复、缺乏新意或风格不一致的问题。应对策略上,引入“人机协作”是关键。对于重要的、需要高精度和原创性的内容,必须有审校环节。你可以设计一个PHP后台管理界面,让编辑可以快速预览、修改和发布AI生成的内容。同时,在Prompt设计上要尽可能细致,提供明确的指令、上下文和参考信息,甚至可以加入“禁止重复”、“必须包含关键词”等约束条件。

第二个挑战是API的速率限制和成本控制。当你需要每小时生成数千甚至数万篇文章时,AI服务提供商的API速率限制会成为瓶颈。同时,每次API调用都是有成本的,不加控制的批量生成可能导致预算迅速超支。我的应对方法通常是:

- 异步处理与队列: 绝对不要同步调用API进行批量生成。使用消息队列(如Redis Queue或RabbitMQ)来缓冲请求,PHP worker进程从队列中异步取出任务并调用API。这样即使API暂时限速,任务也能在队列中等待,不会阻塞主应用。

- 并发控制: 在worker层面,控制同时进行的API请求数量,避免超出服务商的并发限制。

- 智能重试机制: 对于因速率限制或临时网络问题导致的API调用失败,实现指数退避(Exponential Backoff)的重试逻辑。

- 成本监控与预警: 定期检查API使用量和费用,设置预算阈值并发送预警通知,防止意外超支。在PHP中可以集成服务商的账单API或使用Webhook来获取这些信息。

第三个挑战在于Prompt工程的复杂性与迭代。批量生成意味着你需要一套可复用、可配置的Prompt模板。但一个好的Prompt不是一蹴而就的,它需要大量的实验和迭代。如何为不同类型的文章设计出既能保证质量又能实现差异化的Prompt,是一个持续优化的过程。我的做法是,将Prompt模板存储在数据库中,并允许通过PHP后台界面进行动态编辑和版本管理。每次更新Prompt后,可以先用小批量数据进行测试,观察生成效果,再逐步推广。同时,可以尝试结合Few-shot Learning(提供少量高质量示例给AI)来提升生成效果,这比单纯的指令更有效。

最后,可扩展性与系统稳定性也是不得不面对的问题。随着生成量的增加,数据库、队列、甚至PHP-FPM的资源消耗都会上升。你需要考虑数据库的读写分离、缓存策略(比如Redis缓存频繁访问的Prompt模板),以及服务器的横向扩展能力。一个健壮的日志系统和监控报警机制是不可或缺的,它们能帮助你在问题发生前或发生时快速定位并解决。这就像搭建一个复杂的生产线,每个环节都需要精心设计和持续维护。

如何优化PHP批量写作机器人的性能与成本?

优化PHP批量写作机器人的性能与成本,是一个持续的工程,它要求我们既要关注代码效率,也要精打细算AI模型的使用。这就像在高速公路上驾驶一辆油电混合车,既要跑得快,又要省油。

性能优化方面:

异步与并行处理是核心。 PHP本身是单线程的,但通过GuzzleHTTP库的

curl_multi功能,或者更现代的ReactPHP、Amp等异步框架,可以实现对AI API的并发请求。这意味着你可以在等待一个AI响应的同时,发送另一个请求。对于批量任务,这种并行处理能力能显著减少总耗时。// 概念性Guzzle并发请求示例 use GuzzleHttp\Client; use GuzzleHttp\Promise\Utils; $client = new Client(); $requests = []; $prompts = ['prompt1', 'prompt2', 'prompt3']; // 假设有多个待生成的prompt foreach ($prompts as $index => $prompt) { $requests[$index] = $client->postAsync('YOUR_AI_API_ENDPOINT', [ 'json' => [ 'model' => 'gpt-4', 'messages' => [['role' => 'user', 'content' => $prompt]], ], 'headers' => [ 'Authorization' => 'Bearer YOUR_API_KEY', 'Content-Type' => 'application/json', ], ]); } // 等待所有请求完成 $responses = Utils::settle($requests)->wait(); foreach ($responses as $index => $response) { if ($response['state'] === 'fulfilled') { // 处理成功的响应 // $content = json_decode($response['value']->getBody()->getContents())->choices[0]->message->content; // echo "Prompt {$index} 生成内容: {$content}\n"; } else { // 处理失败的请求 // echo "Prompt {$index} 请求失败: {$response['reason']->getMessage()}\n"; } }当然,更推荐的做法是结合消息队列,将任务分发给多个PHP worker进程,每个worker再利用并发请求能力处理一批任务。这能更好地利用多核CPU资源。

数据库优化。 无论是存储Prompt模板、任务状态还是最终生成的内容,数据库都是瓶颈之一。确保你的表设计合理,有正确的索引。对于高并发写入,可以考虑使用批量插入(bulk insert)而不是逐条插入。如果数据量巨大,读写分离也是一个值得考虑的方案。

内存管理。 PHP在处理大量文本时,内存消耗可能不小。尽量避免一次性将所有待处理的Prompt或已生成的内容加载到内存中,而是采用流式处理或分批处理。例如,从文件或数据库分批读取Prompt,处理完一批后释放内存,再处理下一批。

成本优化方面:

精简Prompt,控制Token消耗。 AI模型的计费通常是基于输入和输出的Token数量。一个冗长、重复的Prompt会白白增加成本。学会用最简洁、最精确的语言表达你的需求。例如,与其写“请帮我写一篇关于人工智能的文章,内容要涵盖机器学习、深度学习、神经网络等多个方面,并且要用通俗易懂的语言,字数在800字左右”,不如直接写“撰写一篇800字左右的AI科普文,重点阐述机器学习、深度学习和神经网络。”。在PHP中,你可以实现一个Prompt预处理器,自动移除不必要的空格、注释或重复指令。

智能选择AI模型。 不同的AI模型,其性能和价格差异巨大。对于某些非核心、对质量要求不那么高的内容,可以考虑使用成本更低的模型(如OpenAI的

gpt-3.5-turbo),而将更昂贵、更强大的模型(如gpt-4)保留给对质量有严格要求或需要复杂推理的任务。这种分级使用策略能有效降低总体成本。结果缓存。 如果你的机器人可能会生成重复或高度相似的内容(例如,针对同一产品生成不同平台的描述),可以考虑将AI生成的结果进行缓存。当新的请求与已缓存的Prompt高度相似时,直接返回缓存结果,避免重复调用API。这需要一个有效的缓存键生成策略(例如,Prompt内容的哈希值)和缓存过期机制。

利用开源与自托管模型。 当你的内容生成量达到一定规模,且对数据隐私有较高要求时,自托管开源大模型(如Llama 2、Mistral等)会是一个非常有吸引力的选项。虽然初期需要投入硬件和部署维护成本,但长期来看,可以完全摆脱按Token计费的模式,将成本转嫁为固定资产投入。PHP可以与这些本地运行的模型通过HTTP API(例如,通过Ollama或Llama.cpp提供的API)进行交互。

在我看来,性能和成本的优化往往是相辅相成的。一个高效的系统,能用更少的资源完成更多的工作,自然也降低了成本。但关键在于找到那个平衡点,不为了极致的优化而牺牲项目的可维护性和开发效率。

以上就是《PHP+AI写作机器人搭建教程》的详细内容,更多关于php,AI,内容生成,Prompt工程,批量写作机器人的资料请关注golang学习网公众号!

HTML获取地理位置方法详解

HTML获取地理位置方法详解

- 上一篇

- HTML获取地理位置方法详解

- 下一篇

- AndroidRoom唯一约束优化技巧

-

- 文章 · php教程 | 6分钟前 |

- PHP筛选回文字符串方法详解

- 351浏览 收藏

-

- 文章 · php教程 | 18分钟前 |

- PHP缓存问题怎么解决?缓存调试与清除技巧

- 393浏览 收藏

-

- 文章 · php教程 | 20分钟前 |

- IIS配置PHP环境详细教程

- 218浏览 收藏

-

- 文章 · php教程 | 21分钟前 |

- PHP修改文件夹所有者教程详解

- 374浏览 收藏

-

- 文章 · php教程 | 25分钟前 |

- Yii2 mPDF显示韩元符号方法

- 336浏览 收藏

-

- 文章 · php教程 | 30分钟前 | php 错误屏蔽

- 关闭PHP错误显示的设置方法

- 102浏览 收藏

-

- 文章 · php教程 | 30分钟前 | PHP递归函数

- PHP递归函数返回值怎么正确获取

- 116浏览 收藏

-

- 文章 · php教程 | 45分钟前 |

- PHP分页数据一致性保护技巧

- 145浏览 收藏

-

- 文章 · php教程 | 1小时前 |

- PHP获取参数并存入数据库方法详解

- 176浏览 收藏

-

- 文章 · php教程 | 1小时前 |

- PHP读取Excel并导入数据库的教程

- 241浏览 收藏

-

- 文章 · php教程 | 1小时前 |

- PHP文件下载实现教程与代码示例

- 480浏览 收藏

-

- 文章 · php教程 | 2小时前 |

- PHP保留两位小数向下取整技巧

- 220浏览 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 485次学习

-

- ChatExcel酷表

- ChatExcel酷表是由北京大学团队打造的Excel聊天机器人,用自然语言操控表格,简化数据处理,告别繁琐操作,提升工作效率!适用于学生、上班族及政府人员。

- 4123次使用

-

- Any绘本

- 探索Any绘本(anypicturebook.com/zh),一款开源免费的AI绘本创作工具,基于Google Gemini与Flux AI模型,让您轻松创作个性化绘本。适用于家庭、教育、创作等多种场景,零门槛,高自由度,技术透明,本地可控。

- 4470次使用

-

- 可赞AI

- 可赞AI,AI驱动的办公可视化智能工具,助您轻松实现文本与可视化元素高效转化。无论是智能文档生成、多格式文本解析,还是一键生成专业图表、脑图、知识卡片,可赞AI都能让信息处理更清晰高效。覆盖数据汇报、会议纪要、内容营销等全场景,大幅提升办公效率,降低专业门槛,是您提升工作效率的得力助手。

- 4359次使用

-

- 星月写作

- 星月写作是国内首款聚焦中文网络小说创作的AI辅助工具,解决网文作者从构思到变现的全流程痛点。AI扫榜、专属模板、全链路适配,助力新人快速上手,资深作者效率倍增。

- 5860次使用

-

- MagicLight

- MagicLight.ai是全球首款叙事驱动型AI动画视频创作平台,专注于解决从故事想法到完整动画的全流程痛点。它通过自研AI模型,保障角色、风格、场景高度一致性,让零动画经验者也能高效产出专业级叙事内容。广泛适用于独立创作者、动画工作室、教育机构及企业营销,助您轻松实现创意落地与商业化。

- 4718次使用

-

- PHP技术的高薪回报与发展前景

- 2023-10-08 501浏览

-

- 基于 PHP 的商场优惠券系统开发中的常见问题解决方案

- 2023-10-05 501浏览

-

- 如何使用PHP开发简单的在线支付功能

- 2023-09-27 501浏览

-

- PHP消息队列开发指南:实现分布式缓存刷新器

- 2023-09-30 501浏览

-

- 如何在PHP微服务中实现分布式任务分配和调度

- 2023-10-04 501浏览