Python搭建知识图谱与Neo4j连接教程

积累知识,胜过积蓄金银!毕竟在文章开发的过程中,会遇到各种各样的问题,往往都是一些细节知识点还没有掌握好而导致的,因此基础知识点的积累是很重要的。下面本文《Python构建知识图谱及Neo4j连接教程》,就带大家讲解一下知识点,若是你对本文感兴趣,或者是想搞懂其中某个知识点,就请你继续往下看吧~

使用Python和Neo4j构建知识图谱是主流高效方案,因其结合了Python强大的数据处理与NLP能力及Neo4j原生图存储与查询优势;2. 构建流程包括数据获取(利用Pandas、Requests等)、清洗、信息抽取(通过spaCy、NLTK等进行实体与关系识别)、知识建模(定义节点、关系及属性)、数据导入(通过Neo4j驱动执行批量Cypher操作)和应用可视化(使用Neo4j Browser或Bloom);3. 高效导入数据的关键策略包括使用UNWIND实现批量操作、事务管理、创建索引以加速匹配、以及在合适场景下采用LOAD CSV;4. 常见挑战有数据质量问题(需清洗与标准化)、信息抽取准确性不足(可结合规则与微调模型应对)、模式设计复杂性(应从小规模迭代并结合领域专家意见)以及大规模性能瓶颈(需优化查询、索引和考虑集群部署),整个过程强调迭代优化与多技术协同。

用Python构建知识图谱,并将其存储在Neo4j中,这其实是目前非常主流且高效的方案。核心在于Python强大的数据处理和信息抽取能力,结合Neo4j原生的图存储与查询优势,能让你把非结构化或半结构化数据转化为结构化的知识体系。这不仅仅是技术的堆叠,更是一种思维方式的转变,把散落在各处的信息点串联起来,形成一个可查询、可分析的知识网络。

解决方案

制作知识图谱并非一蹴而就,它通常涉及几个关键步骤,而Python和Neo4j在每个环节都能发挥重要作用。

首先,你需要处理数据。这可能意味着从文本、数据库、API等不同来源获取数据。Python的Pandas、BeautifulSoup、Requests等库在这里是你的得力助手。数据往往是“脏”的,需要清洗、去重、标准化,这一步至关重要,决定了后续图谱的质量。

接着是信息抽取。这是将原始数据转化为图谱中“节点”和“关系”的关键。你可以使用自然语言处理(NLP)技术,比如命名实体识别(NER)来识别实体(人名、地名、组织、概念等),以及关系抽取来识别实体间的联系(例如“出生于”、“工作在”、“是…”)。Python的spaCy、NLTK、Hugging Face Transformers等库提供了强大的工具集。对于结构化数据,这部分可能就是简单的字段映射。

然后是知识建模,也就是定义图谱的“骨架”。你需要思考有哪些类型的节点(Label),它们有什么属性(Property),以及节点之间有哪些类型的关系(Relationship Type),关系本身是否也有属性。这就像设计一个数据库模式,但它更灵活,更贴近真实世界的连接。

接下来,就是把这些清洗、抽取、建模好的数据导入Neo4j。这通常通过Python的Neo4j驱动程序来实现。你将编写Python代码来连接Neo4j数据库,然后构造Cypher语句,将实体创建为节点,将关系创建为边。为了效率,批量导入和事务管理是必不可少的。

最后,是知识图谱的应用和可视化。一旦数据进入Neo4j,你就可以使用Cypher进行复杂的图查询,发现隐藏的模式、进行路径分析、社区发现等。Neo4j Browser和Bloom等工具能直观地展示图谱,帮助你理解数据。

为什么选择Python和Neo4j来构建知识图谱?

选择Python和Neo4j来构建知识图谱,这并非偶然,而是基于它们各自的优势和极佳的协同效应。

Python在数据科学和人工智能领域几乎是无所不能的。它的生态系统极其丰富,从数据爬取(Scrapy, Requests)、数据清洗(Pandas)、到自然语言处理(NLTK, spaCy, Transformers),再到机器学习模型的训练与部署,几乎每个环节都有成熟的库支持。这意味着你在处理各种异构数据源、进行复杂的文本分析和信息抽取时,Python能提供一站式的解决方案。它的语法简洁,上手快,原型开发效率高,对于需要快速迭代和验证思路的知识图谱项目来说,这种灵活性是不可替代的。我个人觉得,Python的魅力在于它允许你“随心所欲”地玩弄数据,不被太多条条框框限制,这在面对复杂、非结构化的知识时尤其重要。

Neo4j则是一款原生的图数据库,它天生就是为存储和查询关系而设计的。与传统的关系型数据库相比,Neo4j在处理复杂、多跳的关系查询时,性能优势是压倒性的。它的数据模型直观,直接对应了现实世界中的“点”和“线”,这让知识图谱的建模过程变得非常自然。Cypher查询语言是它的另一大亮点,它声明式、图形化的语法让图查询变得异常简单和富有表现力。更重要的是,Neo4j提供了强大的可视化工具,如Neo4j Browser和Neo4j Bloom,能让你直观地看到知识图谱的结构,这对于理解复杂关系、进行探索性分析至关重要。我经常觉得,当数据量大到一定程度,关系错综复杂时,文字或表格已经无法承载,只有图才能真正展现其内在的逻辑美。

将两者结合,Python负责“输入”和“处理”,将原始、零散的知识碎片进行加工和提炼;Neo4j则负责“存储”和“查询”,以最高效的方式组织这些知识,并允许你以图的方式进行探索。这种分工协作,让知识图谱的构建变得既高效又富有洞察力。

在Python中如何高效地连接Neo4j并导入数据?

在Python中连接Neo4j,官方推荐的neo4j驱动是首选,它提供了稳定、功能全面的API。当然,也有像py2neo这样的第三方库,它在某些方面可能提供更高级的抽象,但通常我还是会倾向于官方驱动,因为它与Neo4j的版本兼容性更好,也更容易获得社区支持。

连接Neo4j数据库通常只需要几行代码:

from neo4j import GraphDatabase

# 连接URI和认证信息

uri = "bolt://localhost:7687" # 你的Neo4j实例地址

username = "neo4j"

password = "your_password" # 替换为你的密码

try:

driver = GraphDatabase.driver(uri, auth=(username, password))

print("成功连接到Neo4j数据库!")

except Exception as e:

print(f"连接Neo4j失败: {e}")

driver = None # 确保在连接失败时driver为None

# 确保在程序结束时关闭驱动

# driver.close()导入数据时,效率是关键。直接一条条地创建节点和关系在数据量小时可行,但面对成千上万甚至上亿的数据点时,性能会急剧下降。这里有几种策略可以大大提升导入效率:

使用事务(Transactions)和批量操作: 将多个创建或更新操作封装在一个事务中提交,而不是每个操作都独立提交。这大大减少了网络往返和数据库I/O。

if driver: with driver.session() as session: # 批量创建节点示例 nodes_to_create = [ {"name": "Alice", "age": 30}, {"name": "Bob", "age": 25}, {"name": "Charlie", "age": 35} ] # 使用UNWIND批量创建,效率非常高 query = """ UNWIND $data AS item CREATE (p:Person {name: item.name, age: item.age}) RETURN p.name """ session.run(query, data=nodes_to_create) print("批量创建节点完成。") # 批量创建关系示例 relationships_to_create = [ {"person1": "Alice", "person2": "Bob", "rel_type": "FRIENDS_WITH"}, {"person1": "Bob", "person2": "Charlie", "rel_type": "WORKS_WITH"} ] # 批量创建关系,并确保节点存在 query = """ UNWIND $data AS item MATCH (p1:Person {name: item.person1}) MATCH (p2:Person {name: item.person2}) MERGE (p1)-[r:FRIENDS_WITH]->(p2) RETURN p1.name, r, p2.name """ session.run(query, data=relationships_to_create) print("批量创建关系完成。")这里的

UNWIND是一个非常强大的Cypher子句,它允许你将一个列表(Python中的列表)展开为多行数据,然后对每行数据执行操作。这比在Python循环中多次调用session.run()要快得多,因为它减少了数据库的交互次数。创建索引: 在导入大量数据之前,为节点上的关键属性(例如

Person节点的name属性)创建索引是至关重要的。这会大大加速MATCH操作,尤其是在创建关系时需要查找现有节点。if driver: with driver.session() as session: session.run("CREATE INDEX FOR (p:Person) ON (p.name)") print("为Person节点的name属性创建索引。")使用

LOAD CSV(如果数据源是CSV): 如果你的数据已经规整为CSV文件,Neo4j的LOAD CSV命令可以在数据库层面直接导入,效率更高,因为它绕过了Python的中间处理。Python可以用来生成这些CSV文件。// 假设你的CSV文件在Neo4j服务器可以访问的路径下 LOAD CSV WITH HEADERS FROM 'file:///path/to/your/nodes.csv' AS row CREATE (:Person {name: row.name, age: toInteger(row.age)})

选择哪种方法取决于你的数据来源、数据量以及对导入过程的控制需求。通常,结合Python的数据预处理能力和UNWIND的批量导入,能满足大多数复杂场景的需求。

知识图谱构建中的常见挑战与应对策略

构建知识图谱,尤其是在真实世界的数据上,从来都不是一帆风顺的。你会遇到各种各样的问题,这本身就是这个领域的魅力所在,因为它需要你像侦探一样去解决问题。

一个非常普遍的挑战是数据质量问题。原始数据往往是不完整、不一致、有噪声甚至有错误的。比如,同一个实体可能有多种不同的写法(“苹果公司”和“Apple Inc.”),或者数据中存在大量冗余信息。应对这种问题,最直接的方法是投入大量精力在数据清洗和预处理上。这包括使用正则表达式进行模式匹配、模糊匹配算法(如Levenshtein距离)进行实体对齐、以及编写自定义规则来标准化数据格式。有时候,你甚至需要引入人工标注或众包来解决那些机器难以判断的歧义。这部分工作枯燥但至关重要,它直接决定了你最终图谱的“纯净度”。

另一个让人头疼的问题是信息抽取的准确性。无论是命名实体识别(NER)还是关系抽取,当前的NLP模型都无法达到100%的准确率。模型可能会漏掉一些实体,或者错误地识别出不存在的关系,甚至将一个实体误识别为另一个类型。针对这个问题,首先可以尝试使用在特定领域预训练过的模型,或者对通用模型进行微调(Fine-tuning),用你自己的领域数据来训练模型,让它更好地理解你的语境。对于高精度的要求,你可能需要结合规则匹配和机器学习模型,形成一个混合策略。更高级一点,可以考虑引入“人类在环”(Human-in-the-Loop)的机制,让人工对模型抽取的结果进行审核和修正,然后将修正后的数据反馈给模型进行再训练,形成一个持续优化的闭环。

知识图谱的模式设计也是一个不小的挑战。如何定义节点类型(Labels)、关系类型(Relationship Types)以及它们的属性,这需要深思熟虑。设计得过于简单可能无法表达复杂的语义,过于复杂则可能导致导入困难和查询效率低下。我个人的经验是,先从一个简单的核心模式开始,然后逐步迭代和扩展。与领域专家进行频繁的沟通至关重要,他们能提供宝贵的领域知识,帮助你理解实体和关系之间真正的逻辑。有时候,你还需要考虑未来的扩展性,比如是否需要支持多源数据集成,或者未来是否会加入时间维度等。

最后,图谱的扩展性与性能也是一个长期需要关注的问题。当数据量从百万级增长到亿级甚至更高时,你会发现之前的导入策略和查询方式可能不再适用。对于导入,除了前面提到的批量操作和索引,你可能需要考虑Neo4j的集群部署,或者使用Neo4j的APOC库中更高级的批量导入工具。对于查询性能,除了确保索引的正确使用,还需要优化Cypher查询语句,避免全图扫描,尽量从索引开始遍历。对于超大规模的图谱分析,可能需要结合其他大数据工具,比如Spark GraphFrames,但Neo4j本身在单机或集群模式下也能处理相当大的数据集。

这些挑战并非技术本身无法解决,更多的是对项目管理、数据理解和持续优化的考验。知识图谱的构建是一个迭代的过程,很少有“一次性完美”的方案,关键在于在面对问题时,能够灵活调整策略,不断学习和进步。

以上就是本文的全部内容了,是否有顺利帮助你解决问题?若是能给你带来学习上的帮助,请大家多多支持golang学习网!更多关于文章的相关知识,也可关注golang学习网公众号。

HTML预加载技巧与preload作用详解

HTML预加载技巧与preload作用详解

- 上一篇

- HTML预加载技巧与preload作用详解

- 下一篇

- GoChannel非阻塞技巧:select与default使用

-

- 文章 · python教程 | 23分钟前 |

- 时区日期处理与Pandas技巧解析

- 153浏览 收藏

-

- 文章 · python教程 | 45分钟前 |

- Python串口通信管理:避免占用与连接失败方法

- 298浏览 收藏

-

- 文章 · python教程 | 1小时前 |

- Python复杂数据结构属性变更的联动更新技巧

- 385浏览 收藏

-

- 文章 · python教程 | 1小时前 |

- PyCharm中文设置方法及界面配置教程

- 237浏览 收藏

-

- 文章 · python教程 | 1小时前 |

- Map与Partial循环异常修复方法

- 124浏览 收藏

-

- 文章 · python教程 | 1小时前 |

- FastAPI全局异常处理技巧分享

- 495浏览 收藏

-

- 文章 · python教程 | 2小时前 | Python

- 孤立森林如何识别金融异常数据

- 425浏览 收藏

-

- 文章 · python教程 | 2小时前 |

- Python闭包与函数式编程实战解析

- 245浏览 收藏

-

- 文章 · python教程 | 2小时前 |

- NumPy优化库存分配与客户均价计算

- 109浏览 收藏

-

- 文章 · python教程 | 2小时前 |

- Python多列表合并技巧分享

- 307浏览 收藏

-

- 文章 · python教程 | 2小时前 |

- Pythonsorted函数实用技巧分享

- 179浏览 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 499次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 484次学习

-

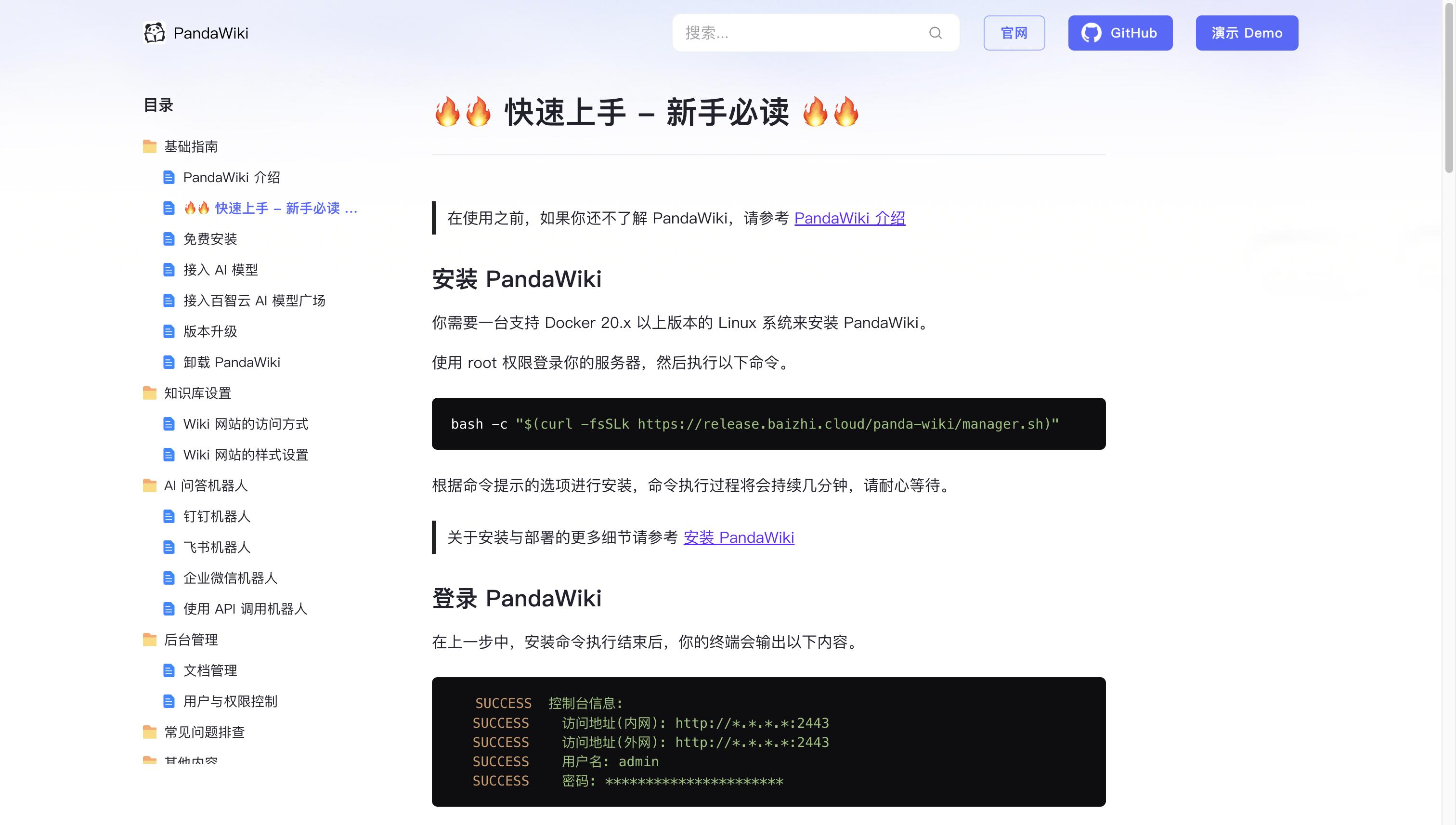

- PandaWiki开源知识库

- PandaWiki是一款AI大模型驱动的开源知识库搭建系统,助您快速构建产品/技术文档、FAQ、博客。提供AI创作、问答、搜索能力,支持富文本编辑、多格式导出,并可轻松集成与多来源内容导入。

- 186次使用

-

- AI Mermaid流程图

- SEO AI Mermaid 流程图工具:基于 Mermaid 语法,AI 辅助,自然语言生成流程图,提升可视化创作效率,适用于开发者、产品经理、教育工作者。

- 980次使用

-

- 搜获客【笔记生成器】

- 搜获客笔记生成器,国内首个聚焦小红书医美垂类的AI文案工具。1500万爆款文案库,行业专属算法,助您高效创作合规、引流的医美笔记,提升运营效率,引爆小红书流量!

- 1001次使用

-

- iTerms

- iTerms是一款专业的一站式法律AI工作台,提供AI合同审查、AI合同起草及AI法律问答服务。通过智能问答、深度思考与联网检索,助您高效检索法律法规与司法判例,告别传统模板,实现合同一键起草与在线编辑,大幅提升法律事务处理效率。

- 1015次使用

-

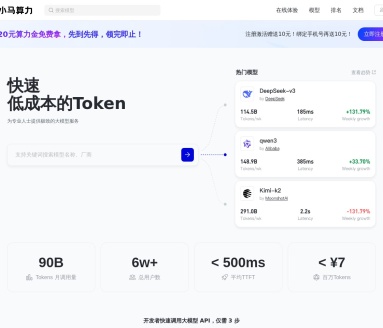

- TokenPony

- TokenPony是讯盟科技旗下的AI大模型聚合API平台。通过统一接口接入DeepSeek、Kimi、Qwen等主流模型,支持1024K超长上下文,实现零配置、免部署、极速响应与高性价比的AI应用开发,助力专业用户轻松构建智能服务。

- 1084次使用

-

- Flask框架安装技巧:让你的开发更高效

- 2024-01-03 501浏览

-

- Django框架中的并发处理技巧

- 2024-01-22 501浏览

-

- 提升Python包下载速度的方法——正确配置pip的国内源

- 2024-01-17 501浏览

-

- Python与C++:哪个编程语言更适合初学者?

- 2024-03-25 501浏览

-

- 品牌建设技巧

- 2024-04-06 501浏览