AI知识图谱全面解析与入门指南

## AI知识图谱入门详解:技术分支、应用与未来发展 人工智能(AI)作为一门庞大且复杂的技术领域,正以惊人的速度发展。本文旨在为初学者提供一份详尽的AI知识图谱,深入解析其主要技术分支,包括机器学习、深度学习、计算机视觉、自然语言处理、机器人学等核心领域。文章不仅阐述了各分支的定义、特点和关键算法,还探讨了它们在自动驾驶、医疗诊断、智能音箱等领域的广泛应用。此外,还关注了多模态学习、生成式AI、边缘AI等新兴方向,以及可信AI与伦理问题。通过对AI技术分支的横向关联和纵向演进的梳理,帮助读者理解AI的整体架构和发展趋势,为深入学习和应用AI技术奠定坚实基础。

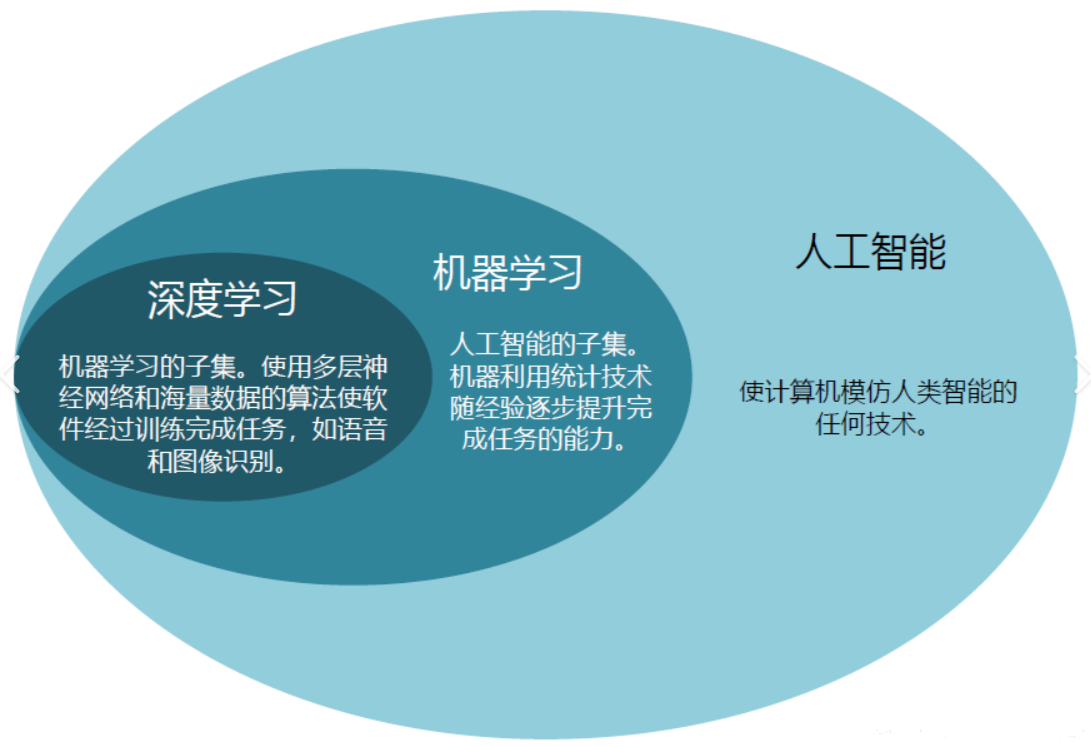

人工智能(AI)是一个庞大且复杂的领域,包含多个技术分支和研究方向,这些分支相互交叉、协同发展,共同推动着 AI 的进步。以下是 AI 领域的主要技术分支及其特点:

一、基础理论与核心技术

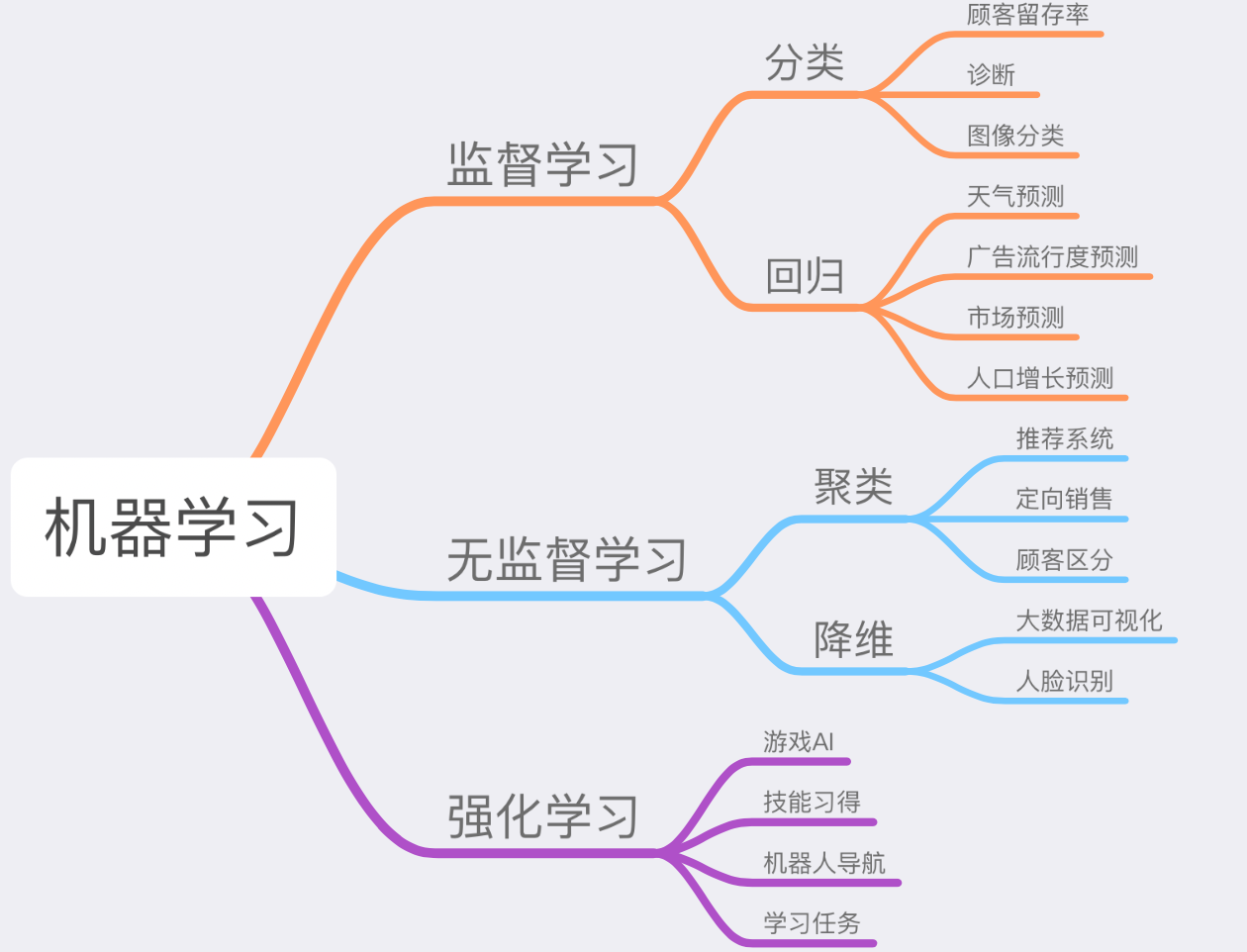

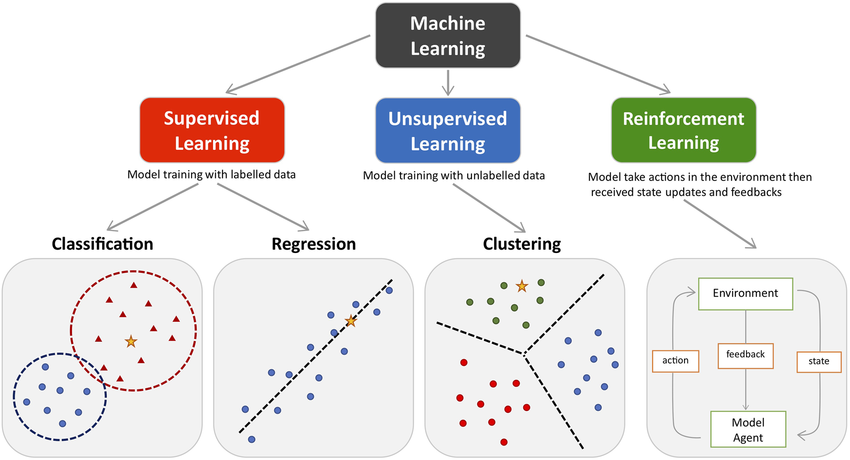

1. 机器学习(Machine Learning, ML)

定义:通过算法让计算机从数据中自动学习规律,解决预测或决策问题。

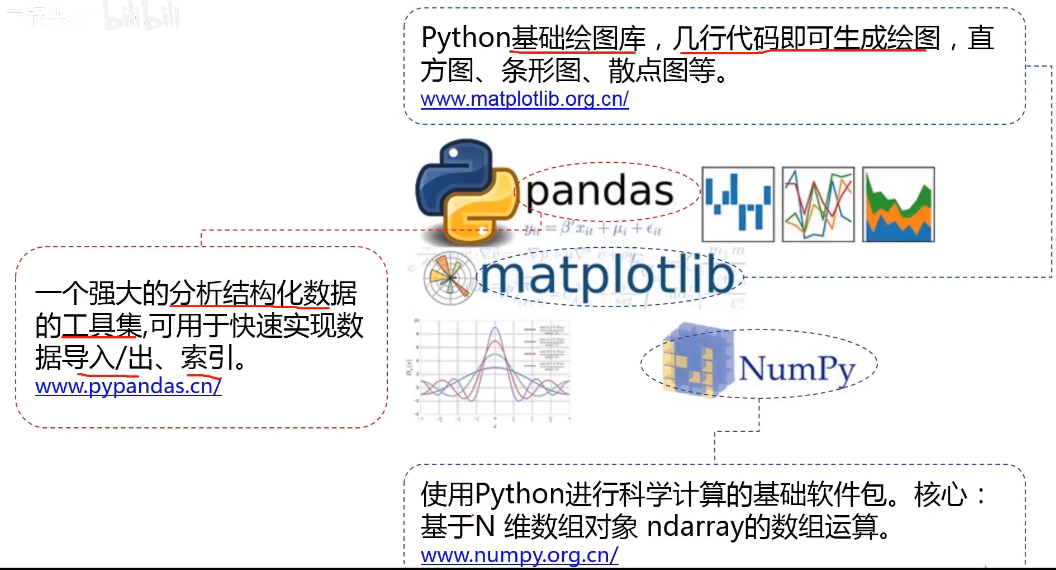

子领域:

监督学习(如分类、回归,用于图像识别、垃圾邮件过滤);

无监督学习(如聚类、降维,用于数据挖掘、用户分群);

强化学习(通过奖励机制训练智能体,用于游戏 AI、机器人控制);

半监督学习(结合少量标注数据和大量未标注数据)。

关键算法:决策树、支持向量机(SVM)、随机森林、神经网络等。

2. 深度学习(Deep Learning, DL)

定义:机器学习的子集,基于深层神经网络模拟人脑神经结构,处理复杂数据。

子领域:

卷积神经网络(CNN):擅长图像和视频处理(如 ResNet、YOLO);

循环神经网络(RNN):处理序列数据(如 LSTM、GRU,用于自然语言处理);

Transformer 架构:基于注意力机制,革新了 NLP(如 BERT、GPT 系列)和多模态任务。

应用:计算机视觉、自然语言处理、语音识别等。

二、感知与认知技术

3. 计算机视觉(Computer Vision, CV)

目标:让计算机 “看懂” 图像或视频。

技术方向:

图像分类、目标检测、语义分割、实例分割;

三维重建、视频理解、姿态估计、视觉跟踪;

生成对抗网络(GAN):用于图像生成、风格迁移(如 DeepFake)。

应用:自动驾驶、医学影像诊断、安防监控、AR/VR。

4. 自然语言处理(Natural Language Processing, NLP)

目标:让计算机理解、生成和处理人类语言。

子领域:

文本分类、命名实体识别、情感分析;

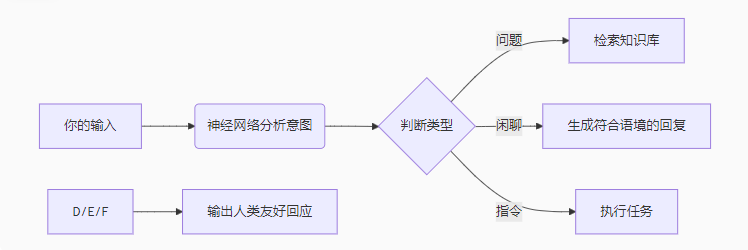

机器翻译、文本生成(如 ChatGPT)、对话系统(聊天机器人);

知识图谱:构建实体关系网络,支持问答和推理。

关键技术:预训练语言模型(PLM)、注意力机制、语义角色标注。

5. 语音识别与合成(Speech Recognition & Synthesis)

语音识别(ASR):将语音转换为文本(如 Siri、科大讯飞);

语音合成(TTS):将文本转换为自然语音(如 Google WaveNet);

应用:智能音箱、语音交互、无障碍服务。

这里其实就是人工智能的三大基础落地方向,即文本、音频、视频处理,和人类对文字、声音、视觉的感知相对应。

三、规划与控制技术

6. 机器人学(Robotics)

融合方向:AI + 传感器 + 机械控制,实现自主机器人。

子领域:

工业机器人(高精度重复作业);

服务机器人(家庭清洁、医疗护理);

自主移动机器人(AMR):如自动驾驶汽车、无人机导航;

人机协作机器人(Cobots):与人类共同工作的安全型机器人。

7. 强化学习(Reinforcement Learning, RL)

核心思想:智能体通过与环境交互,基于奖励信号优化行为策略。

应用:游戏 AI(AlphaGo、AlphaZero)、机器人控制、推荐系统、资源调度(如数据中心节能)。

四、跨领域与新兴方向

8. 多模态学习(Multimodal Learning)

目标:融合文本、图像、语音等多类型数据,实现更全面的理解。

技术:CLIP(图文匹配)、DALL・E(文本生成图像)、多模态大模型(如 GPT-4V)。

9. 生成式 AI(Generative AI)

定义:基于深度学习生成全新内容(如图像、文本、音频)。

技术:GAN、变分自编码器(VAE)、扩散模型(Diffusion Models,用于高质量图像生成)。

应用:艺术创作、虚拟内容生成、药物分子设计。

10. 边缘 AI 与联邦学习(Edge AI & Federated Learning)

边缘 AI:在终端设备(如手机、IoT 设备)上运行 AI 模型,降低延迟和隐私风险;

联邦学习:多机构协同训练模型,数据不出本地,保护隐私(如医疗数据合作)。

11. 可信 AI 与(Trustworthy AI & Ethics)

研究方向:AI 的可解释性(XAI)、公平性、鲁棒性、隐私保护(如差分隐私);

目标:解决 AI 的偏见、安全漏洞和问题(如算法歧视、深度伪造滥用)。

五、传统 AI 与符号系统

12. 符号主义 AI(Symbolic AI)

核心:基于规则和逻辑符号(如专家系统),通过预定义规则处理问题;

应用:早期的医疗诊断系统(如 MYCIN)、逻辑推理(如定理证明)。

13. 知识表示与推理(Knowledge Representation & Reasoning)

目标:用形式化方法(如逻辑、本体论)表示知识,并支持自动推理;

技术:描述逻辑、语义网、自动化推理引擎。

总结:技术分支的关联性

横向关联:例如,计算机视觉依赖深度学习模型(CNN),自然语言处理依赖 Transformer 架构,而强化学习可优化机器人控制策略。

纵向演进:从早期的符号主义(规则驱动)到连接主义(数据驱动),再到当前的多技术融合(如神经符号 AI),AI 正朝着更通用、更智能的方向发展。

理解这些分支有助于根据具体需求选择技术路径,例如:

- 图像分类 → 深度学习(CNN);

- 对话系统 → 自然语言处理(Transformer + 强化学习);

- 自动驾驶 → 多模态学习 + 强化学习 + 机器人学。

要明确一点,我们具体学习时,不是去学“人工智能”本身,因为“人工智能”本身是一个大概念,就是一个目标,那就是“让机器变得跟人类一样智能”。我们为了实现这个目标,需要先学习基础的理论,主要就是机器学习,包括深度学习等等,其实就是各种算法,更直白点就是各种对数据的处理和运算,机器有了学习能力,就是智能化的第一步,然后就需要根据具体的研究方向去深入研究对应方向的一些算法,不同的方向适合不同的处理方式,就相当于把一个人培养成不同方向的专家。

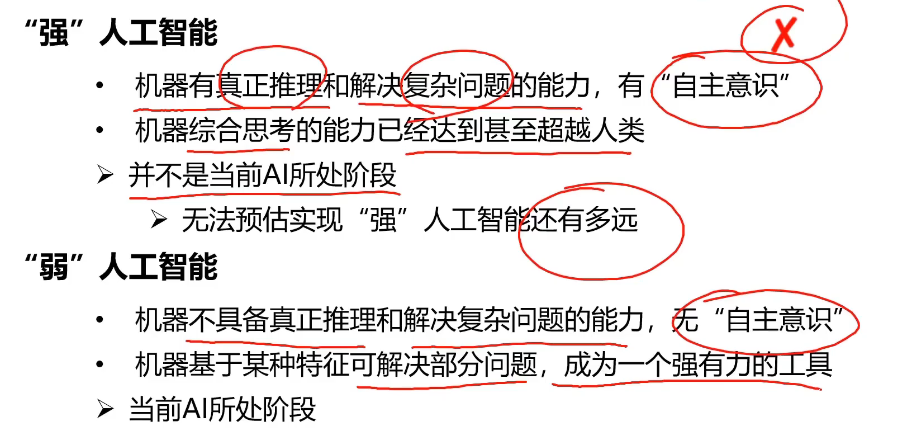

人工智能发展阶段

当前属于弱人工智能阶段。

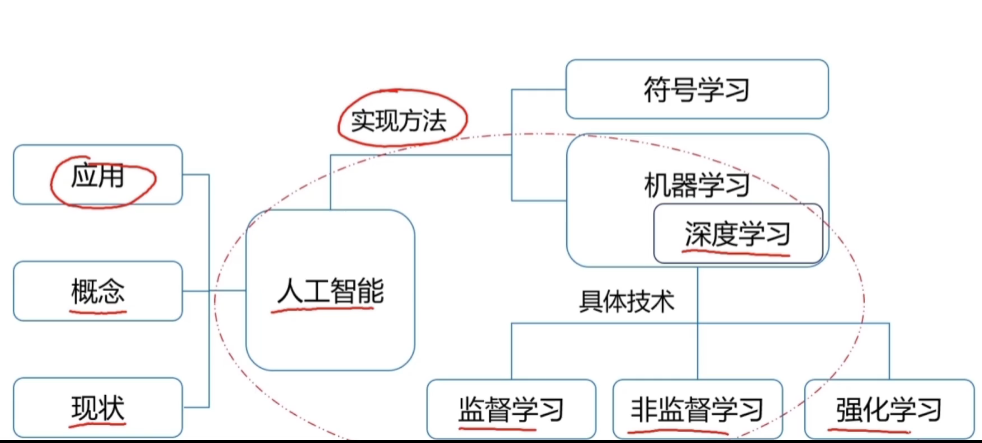

核心知识点

圈里的是主要的知识点。

圈里的是主要的知识点。

常用AI工具

Anaconda

Jupyter Notebook

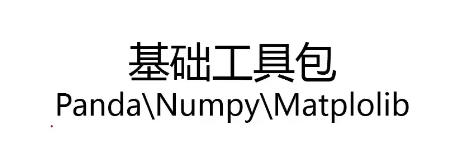

基础工具包

机器学习概述

可参考大神文章:

机器学习入门基础(万字总结)(建议收藏!!!)-CSDN博客

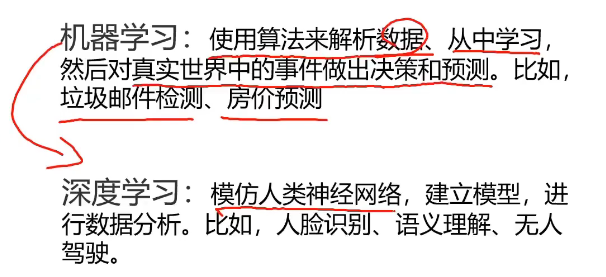

先来看看什么是机器学习。

我们人类的学习,就是先学习各种知识,然后也可以进一步根据已有的知识去推理思考出更多的知识。

类似的,所谓机器学习,是一个很宽泛的概念,泛指机器也具有的这种学习能力,机器学习更强调机器的这种能力,而非特指某种学习的技术。

机器学习是人工智能(Artificial Intelligence)的核心领域之一,使计算机系统有能力从大量的数据中学习和抽象出知识,进而对新数据进行预测和决策。机器学习的根本原理就是是通过让机器自动从庞大的数据中学习和寻找规律的一种过程或者是模式,进而做出预测或者做出决策。这可以通过构建和训练机器学习模型来实现,模型会自动学习从输入到输出之间的映射关系。

理解和掌握机器学习的基本概念、算法原理和应用方法是进入人工智能领域的重要一步:

基本概念包括监督学习、无监督学习、半监督学习、强化学习等学习模式,以及回归、分类、聚类等常见的任务类型;

算法原理包括线性回归、逻辑回归、决策树、神经网络、深度学习(Deep Learning)等;

应用方法包括准备与处理数据、选择与构建合适的模型、训练模型与评估模型的性能,以及如何调整和优化模型以得到更好的效果。

除此之外,还需要理解模型的泛化能力,即模型在未见过的数据上的预测性能,以及如何防止过拟合和欠拟合等问题。

机器学习的流程

机器学习通过让计算机从大量数据中学习模式和规律来做出决策和预测。

- 首先,收集并准备数据,然后选择一个合适的算法来训练模型。

- 然后,模型通过不断优化参数,最小化预测错误,直到能准确地对新数据进行预测。

- 最后,模型部署到实际应用中,实时做出预测或决策,并根据新的数据进行更新。

机器学习是一个迭代过程,可能需要多次调整模型参数和特征选择,以提高模型的性能。

机器学习的工作流程可以大致分为以下几个步骤:

1. 数据收集

- 收集数据:这是机器学习项目的第一步,涉及收集相关数据。数据可以来自数据库、文件、网络或实时数据流。

- 数据类型:可以是结构化数据(如表格数据)或非结构化数据(如文本、图像、视频)。

2. 数据预处理

- 清洗数据:处理缺失值、异常值、错误和重复数据。

- 特征工程:选择有助于模型学习的最相关特征,可能包括创建新特征或转换现有特征。

- 数据标准化/归一化:调整数据的尺度,使其在同一范围内,有助于某些算法的性能。

3. 选择模型

- 确定问题类型:根据问题的性质(分类、回归、聚类等)选择合适的机器学习模型。

- 选择算法:基于问题类型和数据特性,选择一个或多个算法进行实验。

4. 训练模型

- 划分数据集:将数据分为训练集、验证集和测试集。

- 训练:使用训练集上的数据来训练模型,调整模型参数以最小化损失函数。

- 验证:使用验证集来调整模型参数,防止过拟合。

5. 评估模型

- 性能指标:使用测试集来评估模型的性能,常用的指标包括准确率、召回率、F1分数等。

- 交叉验证:一种评估模型泛化能力的技术,通过将数据分成多个子集进行训练和验证。

6. 模型优化

- 调整超参数:超参数是学习过程之前设置的参数,如学习率、树的深度等,可以通过网格搜索、随机搜索或贝叶斯优化等方法来调整。

- 特征选择:可能需要重新评估和选择特征,以提高模型性能。

7. 部署模型

- 集成到应用:将训练好的模型集成到实际应用中,如网站、移动应用或软件中。

- 监控和维护:持续监控模型的性能,并根据新数据更新模型。

8. 反馈循环

- 持续学习:机器学习模型可以设计为随着时间的推移自动从新数据中学习,以适应变化。

技术细节

- 损失函数:一个衡量模型预测与实际结果差异的函数,模型训练的目标是最小化这个函数。

- 优化算法:如梯度下降,用于找到最小化损失函数的参数值。

- 正则化:一种技术,通过添加惩罚项来防止模型过拟合。

机器学习的工作流程是迭代的,可能需要多次调整和优化以达到最佳性能。此外,随着数据的积累和算法的发展,机器学习模型可以变得更加精确和高效。

这个所谓的模型,其实可以简单理解成一个函数黑盒子,比如:i*特征值1 + j*特征值2 + k*特征值3……,最后得到一个输出。因为已经事先经过了大量的同类数据的训练,然后总结出了这类数据的特征值、以及各种特征值的比重等等规律,后续遇到同类的问题,就能进行解析和预测。

注意:机器学习不是说一台机器去学习用户的交互内容,而是研发人员训练机器,通过知识库和算法来生成一套程序,这套程序里面包含了目标数据的特征和权重等信息,整体而言就可以理解成一个函数。然后把这个函数提供给用户使用,用户输入同类信息的时候,这个函数就会根据信息的特征和规律去输出对应的内容,大部分情况下都不会偏离太多,如果确实有错误,那么研发人员收到反馈后,再次调整和优化这个函数,通过调整参数或者补充知识库等方式,进一步完善该函数……久而久之,就越来越完善了。

机器学习的应用

机器学习的应用极其广泛,深深地影响着人们的生活:

推荐系统:例如,抖音推荐你可能感兴趣的视频,淘宝推荐你可能会购买的商品,网易云音乐推荐你喜欢的音乐。

自然语言处理(NLP):机器学习在语音识别、机器翻译、情感分析、聊天机器人等方面的应用。例如,Google 翻译、Siri 和智能客服等。

计算机视觉:机器学习在图像识别、物体检测、面部识别、自动驾驶等领域有广泛应用。例如,自动驾驶汽车通过摄像头和传感器识别周围的障碍物,识别行人和其他车辆。

金融分析:机器学习在股市预测、信用评分、欺诈检测等金融领域具有重要应用。例如,银行利用机器学习检测信用卡交易中的欺诈行为。

医疗健康:机器学习帮助医生诊断疾病、发现药物副作用、预测病情发展等。例如,IBM 的 Watson 系统帮助医生分析患者的病历数据,提供诊断和治疗建议。

游戏和娱乐:机器学习不仅用于游戏中的智能对手,还应用于游戏设计、动态难度调整等方面。例如,AlphaGo 使用深度学习技术战胜了围棋世界冠军。

……

机器学习的类型

机器学习主要分为以下三种类型:

1. 监督学习(Supervised Learning)

定义:监督学习是指使用带标签的数据进行训练,模型通过学习输入数据与标签之间的关系,来做出预测或分类。

应用:分类(如垃圾邮件识别)、回归(如房价预测)。

例子:线性回归、决策树、支持向量机(SVM)。

2. 无监督学习(Unsupervised Learning)

定义:无监督学习使用没有标签的数据,模型试图在数据中发现潜在的结构或模式。

应用:聚类(如客户分群)、降维(如数据可视化)。

例子:K-means 聚类、主成分分析(PCA)。

3. 强化学习(Reinforcement Learning)

定义:强化学习通过与环境互动,智能体在试错中学习最佳策略,以最大化长期回报。每次行动后,系统会收到奖励或惩罚,来指导行为的改进。

应用:游戏AI(如AlphaGo)、自动驾驶、机器人控制。

例子:Q-learning、深度Q网络(DQN)。

这三种机器学习类型各有其应用场景和优势,监督学习适用于有明确标签的数据,无监督学习适用于探索数据内在结构,而强化学习适用于需要通过试错来学习最优策略的场景。

半监督学习

另外,还有一种混合式的学习方法也在发展之中,比如混合监督学习和非监督学习,从而形成半监督学习

半监督学习只有少量的标记数据,完全靠这些不完全标记的数据不可能训练好一个模型,依靠大量的无监督数据来提高算法性能。因此,只有选择半监督学习来使数据的价值达到最大化,使机器学习模型能够从庞大的数据集中挖掘出其隐藏规律。经过研究人员的不懈努力和长期坚持,半监督学习的发展取得了一定的成效,提出了不少半监督学习方法,也应用到了不少实际领域当中。

半监督学习的研究仍然存在许多待解决的问题,未来的研究大门正等着大家去开启。

机器学习的未来

随着数据量的爆炸式增长和计算能力的提升,机器学习的应用将继续扩展,带来更加智能和高效的系统。例如:

强化学习:使计算机能够在没有明确指导的情况下通过试错来解决复杂问题。例如,AlphaGo 和 Dota 2 游戏 AI 都使用了强化学习。

自监督学习:目前的机器学习模型通常需要大量带标签的数据来进行训练,而自监督学习则能够在没有标签的数据下学习更有效的表示。

深度学习:深度学习是机器学习中的一个分支,主要关注神经网络的应用,它已经在图像识别、自然语言处理等方面取得了突破性进展。未来,深度学习将继续推动人工智能的发展。

通过机器学习,我们能够创建更智能的系统,自动化繁琐的任务,并改善我们日常生活的各个方面。随着技术的发展,机器学习将成为未来各行业的核心驱动力之一。

机器学习的任务

在机器学习中,回归(Regression)、分类(Classification)、聚类(Clustering)是三种最基本的任务类型,它们的目标和方法有显著区别。

以下通过对比和实例解析,帮助你快速理解三者的本质区别:

一、回归(Regression)

核心目标

预测连续数值:输出是一个具体的数值(如房价、温度、股票价格)。

数学本质:寻找输入特征与连续输出之间的函数映射关系。

典型场景

房价预测:根据房屋面积、房龄、地段等特征,预测房价(如 ¥300 万、¥500 万)。

天气预报:根据气压、湿度等预测明天的温度(如 25.5℃)。

销售预测:根据历史数据预测下月销售额(如 ¥100 万)。

常见算法

线性回归、多项式回归、随机森林回归、支持向量回归(SVR)、神经网络(如 LSTM 用于时间序列预测)。

关键指标

均方误差(MSE):预测值与真实值的平均平方差。

决定系数(R²):衡量模型解释数据变异的比例(越接近 1 越好)。

二、分类(Classification)

核心目标

预测离散类别:输出是有限个类别标签(如 “猫 / 狗”“垃圾邮件 / 正常邮件”)。

数学本质:将输入特征映射到某个类别,通常基于概率或决策边界。

典型场景

图像识别:识别图片中的物体是 “猫” 还是 “狗”。

医疗诊断:判断肿瘤是 “良性” 还是 “恶性”。

情感分析:分析评论是 “正面”“负面” 还是 “中性”。

常见算法

逻辑回归(二分类)、决策树、随机森林、支持向量机(SVM)、神经网络(如 CNN 用于图像分类)。

关键指标

准确率(Accuracy):预测正确的样本占总样本的比例。

精确率(Precision):预测为正类的样本中实际为正类的比例。

召回率(Recall):实际为正类的样本中被正确预测的比例。

三、聚类(Clustering)

核心目标

发现数据分组:将相似的数据点自动划分为 “簇”(Cluster),且无预定义的标签。

数学本质:基于数据的内在相似性(如距离、密度)进行分组。

典型场景

客户分群:将用户按消费习惯分为 “高价值客户”“普通客户”“潜在客户”。

图像分割:将图像中相似颜色或纹理的区域归为同一类(如识别天空、地面、建筑)。

文档分类:将主题相似的文章自动聚类(如科技、娱乐、体育)。

常见算法

K-means(基于距离)、DBSCAN(基于密度)、层次聚类(基于层级关系)、高斯混合模型(GMM)。

关键指标

轮廓系数(Silhouette Score):评估簇内凝聚度和簇间分离度(越接近 1 越好)。

簇内平方和(WCSS):K-means 中用于确定最佳簇数(手肘法)。

四、三者的核心区别

| 维度 | 回归 | 分类 | 聚类 |

| 输出类型 | 连续数值(如 3.14、¥500 万) | 离散类别(如 “猫”“狗”) | 无标签分组(如 “簇 1”“簇 2”) |

| 标签需求 | 需要有标签数据 | 需要有标签数据 | 不需要标签(无监督) |

| 目标 | 最小化预测误差 | 最大化分类准确率 | 最大化簇内相似性 |

| 应用场景 | 预测、趋势分析 | 识别、判断 | 发现模式、用户分群 |

五、对比案例:以 “客户分析” 为例

回归:预测客户的未来消费金额(如根据历史消费数据预测下月消费 ¥2000)。

分类:预测客户是否会购买某产品(如 “会购买”/“不会购买”)。

聚类:将客户自动分组(如 “高消费高频”“低消费低频”“新用户”)。

小结

总结来说就是:

回归是连续数值的预测;

分类是给目标判定类别;

聚类是把具有相似特征的目标分在一组里。

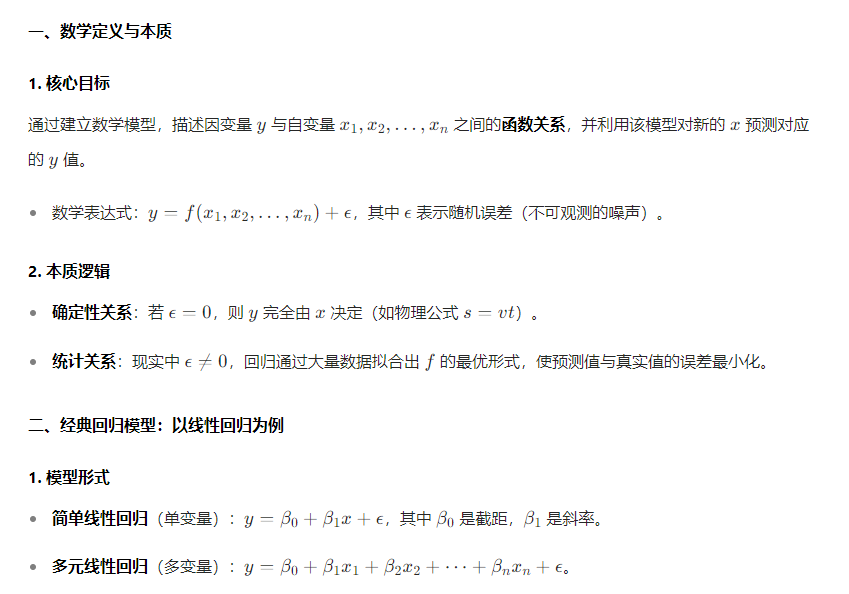

补充:对于回归的理解

在数学和统计学中,回归(Regression) 是一种用于分析变量之间关系的方法,核心目标是通过一个或多个自变量(解释变量) 来预测因变量(响应变量) 的连续数值。它不仅是机器学习中的基础任务(如前文所述),更是统计学的重要分支,其数学本质和应用逻辑可从以下维度深入解析:

数学上的回归是一种通过数据拟合函数关系来预测连续值的方法论,其核心在于用统计或机器学习手段建立自变量到因变量的映射,并通过误差最小化确保模型有效性。从简单的线性回归到复杂的非线性模型,回归分析始终是理解变量关系、解决预测问题的基础工具,其思想贯穿统计学、机器学习及各应用学科。

理解机器学习和统计学的关系:

机器学习与统计学有着深刻的内在联系,其核心思想确实蕴含概率性和不确定性,但不能简单将其等同于 “统计学的行为”。以下从两者的关系、机器学习的概率特性、以及确定性与不确定性的边界展开分析:

一、机器学习与统计学的渊源:方法与目标的交集

1. 统计学是机器学习的理论基石

机器学习中的许多算法(如线性回归、逻辑回归、贝叶斯模型)直接来源于统计学,两者共享数据建模、概率分布、假设检验等核心概念。

统计学中的大数定律和中心极限定理为机器学习的泛化能力提供了理论支撑(例如,通过训练数据推断总体分布)。

示例:逻辑回归在统计学中用于分类问题,在机器学习中则作为线性分类器被广泛使用,两者的数学本质一致。

2. 机器学习拓展了统计学的应用边界

统计学更侧重理论推导(如参数估计的无偏性、假设检验的显著性),目标是通过数据揭示因果关系或验证假设;

机器学习更侧重算法实现和预测能力,目标是利用数据构建模型解决实际问题(如图像识别、自然语言处理),对因果关系的关注较弱。

差异示例:

统计学中,线性回归需假设误差项服从正态分布;

机器学习中,线性回归可直接作为预测模型,无需严格依赖分布假设,更关注模型在测试集上的误差。

二、机器学习的概率性本质:从数据到预测的不确定性

1. 模型的概率性建模

许多机器学习模型显式引入概率框架:

贝叶斯方法:如贝叶斯网络、概率图模型,通过先验分布和后验分布量化不确定性(例如,垃圾邮件分类中计算邮件属于垃圾邮件的概率);

生成模型:如变分自动编码器(VAE)、生成对抗网络(GAN),通过学习数据的概率分布生成新样本;

分类问题:输出类别概率(如 Softmax 层输出 “属于某类的概率大于 50%”)而非绝对决策。

2. 预测的不确定性来源

数据噪声:训练数据本身存在测量误差或标注错误,导致模型无法完美拟合真实规律;

模型偏差:选择的模型结构(如线性模型)无法捕捉数据的复杂关系,导致泛化误差;

不确定性量化:部分算法(如深度学习中的 Dropout、贝叶斯神经网络)专门用于估计预测的不确定性(例如,医疗诊断中给出 “患病概率为 70%±5%”)。

3. 与传统编程的本质区别

传统编程:通过明确的规则(如 if-else 语句)实现确定性逻辑(输入相同,输出必然相同);

机器学习:通过数据训练得到概率性模型(输入相同,输出可能因模型随机性或不确定性而不同)。

示例:图像分类模型对同一张图片可能输出 “猫(90%)” 或 “狗(10%)”,取决于训练数据的分布和模型的随机性。

三、机器学习中的确定性元素:并非完全 “模糊”

1. 算法的确定性流程

尽管模型输出具有概率性,但算法的训练和推理过程是确定性的:

梯度下降优化参数的步骤是明确的数学迭代;

卷积神经网络(CNN)的前向传播计算过程完全由权重和输入决定,无随机性(除非显式引入 Dropout 等随机层)。

好比概率论理很多都是预测,但是预测过程所用到的数学知识都是确定性的。

2. 可解释性与因果推断的探索

部分机器学习领域正尝试结合确定性逻辑,例如:

可解释 AI(XAI):通过 SHAP 值、LIME 等方法解释模型决策的 “原因”(如 “图像中的猫耳区域导致模型判断为猫”);

因果机器学习:将因果推断(如 Do-calculus)融入模型,从概率关联中挖掘因果关系(例如,判断 “药物是否真正导致病情好转”)。

四、总结:概率性是手段,确定性是目标

机器学习的本质:是一种基于统计学和算法的数据驱动方法,通过概率建模解决不确定性问题,但最终目标是实现可靠的预测或决策(例如,自动驾驶中以 99.9% 的概率判断前方为行人时,采取刹车动作是确定性的)。

核心结论:

机器学习依赖统计学的概率工具,但超越了传统统计学的理论范畴,更注重工程实现和问题解决;

其结果是概率性的,但应用场景中常通过阈值(如 “概率>50% 则分类为正例”)将其转化为确定性行动。

因此,机器学习可以看作是用概率方法解决确定性问题的范式—— 通过量化不确定性,在现实世界的模糊性中实现可靠的决策。

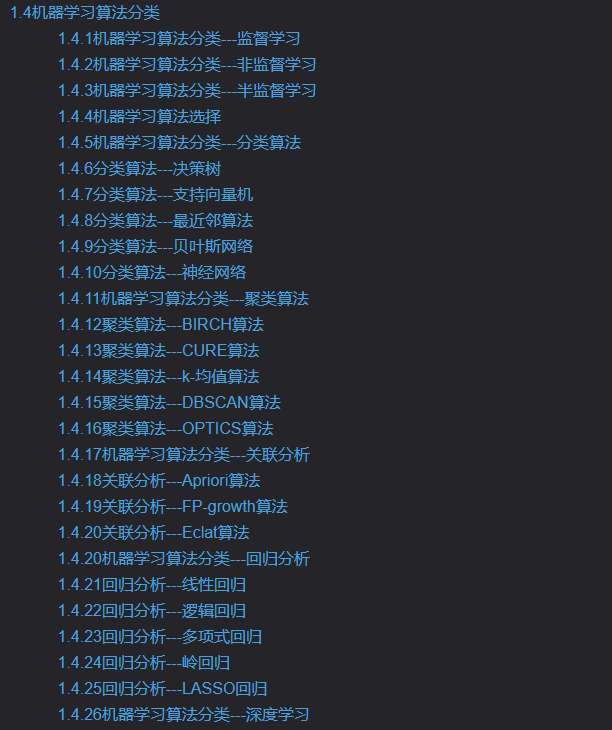

机器学习的算法

知道了机器学习,那具体怎么学习呢?有哪些学习方法能帮助机器进行学习呢?这就要涉及到具体的算法了,各种算法各有优劣。

机器学习算法种类繁多,以下是几种最常见且应用广泛的算法,按主要任务类型分类整理:

1. 监督学习(Supervised Learning)

线性回归(Linear Regression)

用途:预测连续值(如房价、销售额)。

特点:拟合线性关系,简单易解释。

逻辑回归(Logistic Regression)

用途:二分类问题(如垃圾邮件分类)。

特点:输出概率,使用Sigmoid函数。

决策树(Decision Tree)

用途:分类和回归(如客户分群、风险预测)。

特点:树形结构,可解释性强,易过拟合。

随机森林(Random Forest)

用途:分类/回归,高维数据(如图像识别)。

特点:多棵决策树集成,抗过拟合。

支持向量机(SVM)

用途:分类(如文本分类、生物标记识别)。

特点:最大化分类间隔,可处理非线性(核技巧)。

梯度提升树(Gradient Boosting, 如XGBoost/LightGBM)

用途:竞赛常用,分类/回归(如点击率预测)。

特点:迭代优化残差,高性能。

2. 无监督学习(Unsupervised Learning)

K均值聚类(K-Means)

用途:聚类分析(如用户分群、图像压缩)。

特点:需要预设簇数,对异常值敏感。

主成分分析(PCA)

用途:降维(如数据可视化、特征压缩)。

特点:线性降维,保留最大方差。

DBSCAN

用途:密度聚类(如异常检测、地理数据聚类)。

特点:自动发现簇数,适应不规则形状。

关联规则(Apriori)

用途:挖掘频繁项集(如购物篮分析)。

3. 深度学习(Deep Learning)

神经网络(Neural Networks)

基础结构:多层感知机(MLP),用于简单分类/回归。

卷积神经网络(CNN)

用途:图像处理(如图像分类、目标检测)。

特点:局部感知、权重共享。

循环神经网络(RNN/LSTM)

用途:序列数据(如时间序列预测、自然语言处理)。

Transformer

用途:NLP(如BERT、GPT)、跨领域应用。

4. 其他重要算法

朴素贝叶斯(Naive Bayes)

用途:文本分类(如情感分析)。

特点:基于概率,假设特征独立。

K近邻(K-NN)

用途:分类/回归(如推荐系统)。

特点:惰性学习,依赖距离度量。

隐马尔可夫模型(HMM)

用途:序列预测(如语音识别)。

如何选择算法?

数据规模:小数据可用SVM,大数据用随机森林/深度学习。

任务类型:分类、回归、聚类需求不同。

可解释性:业务场景需解释性时选决策树/逻辑回归。

非线性:复杂关系可用神经网络或核方法。

这些算法是实际应用中的核心工具,通常需要结合特征工程和调优来提升性能。

我询问deepseek使用了哪些机器学习算法:

作为一个AI助手(DeepSeek Chat),我的底层模型(如深度神经网络)主要基于深度学习算法,但在训练和优化过程中可能涉及多种机器学习技术的组合。以下是与我的能力相关的核心算法和技术:

核心算法

Transformer 架构

我的基础是类似GPT的生成式预训练Transformer模型,核心包括:

自注意力机制(Self-Attention)

位置编码(Positional Encoding)

多头注意力(Multi-Head Attention)

用于处理长文本依赖和生成连贯回复。

深度学习优化技术

反向传播(Backpropagation)

梯度下降变体(如AdamW优化器)

正则化方法(Dropout、Layer Normalization)

训练中可能涉及的机器学习方法

监督学习

基于海量标注数据(如对话文本、百科知识)进行预训练和微调。

任务类型:文本生成(序列到序列学习)、分类(意图识别)等。

自监督学习(Self-Supervised Learning)

通过掩码语言建模(MLM)或预测下一词来预训练模型(如BERT/GPT风格)。

强化学习(RLHF)

可能使用人类反馈强化学习(Reinforcement Learning from Human Feedback)来优化回答质量。

辅助技术

自然语言处理(NLP)技术

分词(Tokenization)、嵌入(Embedding)

序列建模(RNN/LSTM的早期版本可能用于部分任务)

传统机器学习算法的潜在应用

数据预处理阶段可能用到聚类(如K-Means处理用户行为数据)或降维(PCA)。

特征工程中可能涉及统计方法(如TF-IDF)。

关键点说明

我的核心能力依赖于大规模深度学习,尤其是Transformer架构。

传统机器学习算法(如随机森林、SVM)通常不直接用于生成回答,但可能在后台支持数据分析和优化。

我的训练过程是端到端的,但具体实现细节由深度求索公司的研究团队优化。

如果需要了解具体任务(如文本分类、实体识别)的实现细节,可以进一步探讨!

什么是Transformer架构

Transformer架构是一种基于自注意力机制(Self-Attention)的深度学习模型,由Google在2017年的论文《Attention Is All You Need》中首次提出。它彻底改变了自然语言处理(NLP)领域,并成为现代大语言模型(如GPT、BERT、PaLM等)的核心基础。

核心思想

Transformer的核心创新是完全摒弃传统的循环神经网络(RNN)和卷积神经网络(CNN),仅依赖注意力机制处理序列数据,解决了RNN的长程依赖问题和CNN的局部感知限制。

核心组件

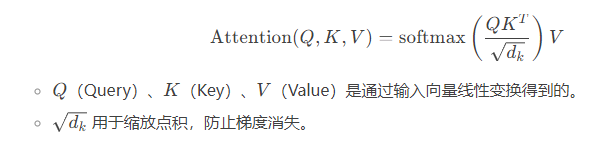

(1) 自注意力机制(Self-Attention)

作用:计算输入序列中每个词与其他词的关系权重,捕捉上下文依赖。

公式:

(2) 多头注意力(Multi-Head Attention)

并行运行多个自注意力层,从不同子空间学习多样化的特征表示。

增强模型捕捉不同位置关系的能力。

(3) 位置编码(Positional Encoding)

由于Transformer没有循环结构,需要通过位置编码注入序列的顺序信息。

使用正弦/余弦函数生成位置嵌入(可学习的位置编码也可用)。

(4) 前馈神经网络(Feed Forward Network)

每个注意力层后接一个全连接网络(通常包含两层和ReLU激活函数),用于非线性变换。

(5) 残差连接(Residual Connection)与层归一化(LayerNorm)

残差连接:缓解深层网络梯度消失问题(如 +Sublayer()x+Sublayer(x))。

层归一化:加速训练收敛。

Transformer的架构图

输入 → 词嵌入 + 位置编码 → [多头注意力 → Add & Norm → 前馈网络 → Add & Norm] × N → 输出

编码器(Encoder):处理输入序列(如BERT)。

解码器(Decoder):生成输出序列(如GPT),比编码器多一个“掩码多头注意力”层(防止未来信息泄露)。

为什么Transformer如此强大?

并行计算:相比RNN的序列处理,Transformer可并行计算所有位置的注意力。

长程依赖:自注意力直接建模任意距离的词关系,不受序列长度限制。

可扩展性:适合大规模预训练(如GPT-3的1750亿参数)。

典型应用

编码器架构:BERT(双向上下文理解,用于分类、问答)。

解码器架构:GPT系列(生成式任务,如文本生成、代码补全)。

编码器-解码器架构:T5、BART(机器翻译、摘要生成)。

与RNN/CNN的对比

| 特性 | Transformer | RNN | CNN |

| 长程依赖 | 强(全局注意力) | 弱(梯度消失) | 中(依赖卷积层数) |

| 并行计算 | 支持 | 不支持(序列依赖) | 支持 |

| 训练速度 | 快(并行) | 慢(逐步计算) | 中 |

Transformer的提出标志着NLP进入“预训练+微调”的新时代,也是当前大语言模型(如我背后的技术)的基石。如果需要更细节的数学解释或具体实现,可以进一步探讨!

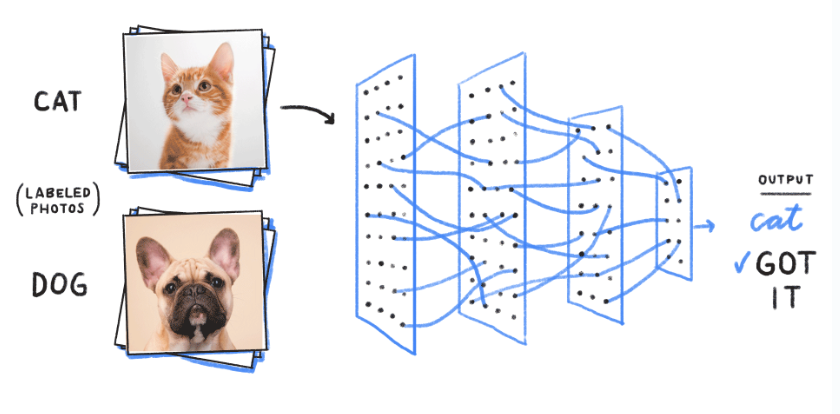

据此,我们来简单熟悉下神经网络和深度学习

;;;

神经网络(Neural Networks)

定义: 神经网络是一种受生物神经元启发而设计的计算模型,由输入层、隐藏层和输出层组成,通过权重和激活函数模拟信息传递与决策过程。

核心特点:

分层结构:数据从输入层逐层传递到输出层。

非线性变换:激活函数(如Sigmoid、ReLU)引入非线性。

学习机制:通过反向传播(Backpropagation)调整权重,最小化预测误差。

典型类型:

前馈神经网络(FNN):最简单的单向传播网络(如多层感知机MLP)。

循环神经网络(RNN):处理序列数据(如时间序列、文本),但存在梯度消失问题。

卷积神经网络(CNN):专用于图像处理,通过卷积核提取局部特征。

;;;

深度学习(Deep Learning)

定义: 深度学习是神经网络的扩展,特指具有多个隐藏层(“深度”结构)的模型,能够自动学习多层次的特征表示。

核心特点:

深度架构:通常包含多个非线性变换层(如10层、100层甚至更多)。

端到端学习:直接从原始数据(如图像像素、文本字符)学习高级特征,无需人工特征工程。

大数据依赖:需大量数据和算力(如GPU/TPU)进行训练。

典型模型:

CNN(如ResNet、EfficientNet):图像分类、目标检测。

RNN变体(如LSTM、GRU):长序列建模(如语音识别)。

Transformer(如BERT、GPT):自然语言处理的核心架构。

;;;

神经网络 vs 深度学习

| 对比维度 | 传统神经网络 | 深度学习 |

| 层数 | 较浅(1-3层隐藏层) | 深度(多隐藏层,甚至数百层) |

| 特征提取 | 依赖人工特征工程 | 自动学习多层次特征 |

| 数据需求 | 中小规模数据 | 大规模数据(百万级样本) |

| 计算资源 | 普通CPU即可 | 需GPU/TPU加速 |

| 典型应用 | 简单分类/回归(如房价预测) | 复杂任务(如图像生成、机器翻译) |

深度学习为何强大?

层次化特征学习: 低层学习边缘、纹理等基础特征,高层组合成复杂特征(如人脸、物体)。

通用逼近能力: 深度网络理论上可以逼近任何复杂函数(Universal Approximation Theorem)。

预训练+微调范式: 通过大规模预训练(如GPT-3)迁移到小规模任务。

;;;

关键挑战

过拟合:需用Dropout、正则化等技术缓解。

计算成本:训练大模型需高昂算力(如GPT-3训练费用超千万美元)。

解释性差:黑箱模型,决策过程难以解释。

;;;

总结

神经网络是深度学习的基础,深度学习是神经网络的“深度化”扩展。

选择依据:

简单任务(如表格数据分类)→ 传统神经网络(如MLP)。

复杂任务(如图像、文本)→ 深度学习模型(如CNN、Transformer)。

深度学习推动了AI在视觉、语音、自然语言等领域的突破,也是ChatGPT等大模型的核心技术!

小结

机器学习具体有很多算法,神经网络是其中的一种,深度学习是基于神经网络的扩展,功能更强大,Transformer则是深度学习的具体程序架构。

机器学习和深度学习的区别

更多待补充。

对机器学习的若干疑惑

就比如我们要训练一个模型来识别猫和狗的图片。

在传统编程中,程序员需要手动定义哪些特征可以区分猫和狗(如耳朵形状、鼻子形状等),而在机器学习中,程序员只需要提供大量带标签的图片数据,计算机会自动学习如何区分猫和狗。

程序员给出大量数据,算法就会自动去学习如何识别和总结目标的特征,一旦总结出特征了,后续就能根据特征来进行识别,这还是很智能的,所以问题的关键是:算法怎么就能自行识别和总结数据的特征呢?这也是人工智能的核心所在,这就不得不感叹数学的强大之处了,世间万物即可算!

怎么来理解呢?比如一张小狗的图片A,传统的编程可能就是判断这张小狗的图片A里是小狗,但是换了一张其他小狗的图片B,然后就无法识别了,针对的是这张图片A本身,程序里会定义明确的规则和逻辑,计算机根据这些规则执行任务。而机器学习则是编写一套算法模型(当然也是程序),让这个程序能识别到图片里的特征,然后根据各种特征来判断图片里的是不是小狗,还是其他动物?所以,机器学习不在于针对具体的某一张图片,而是针对某一类问题,根据这类问题的特征来判断具体属于哪一种。所以机器学习,一般需要针对特定的需求方向来进行特定的训练,然后得到对应的模型,之后我们任意输入一张照片,模型就能判断这张图片里是不是一只小狗。

这就是一种人工智能,就好比我们人类,看到一张小狗的图片,也是根据小狗的特征去判断是不是一只小狗,机器也是一样,甚至有时候比人类更强大,因为机器是不受情绪干扰的,它们学习了小狗的特征,之后也可以根据小狗的特征去判断。

那么,机器到底是怎么实现自主学习的呢?机器学习时不需要程序员干涉吗?

机器学习模型(如识别猫狗的模型)的 “自主学习” 本质是通过算法从数据中自动提取规律,但这一过程并非完全不需要程序员干涉。以下是具体实现逻辑和程序员的角色解析:

一、机器如何实现自主学习?(以神经网络为例)

1. 数据输入与特征提取

原始数据处理:程序员将猫狗图片转换为数字矩阵(像素值),并归一化处理(如缩放到 0-1 范围),作为模型输入。

特征提取:

传统机器学习:需人工设计特征(如颜色直方图、纹理特征),算法(如 SVM)通过特征差异区分猫狗。

深度学习(CNN):模型自动学习特征。例如:

卷积层:第一层学习边缘、颜色等基础特征(如识别 “猫耳的曲线”);

深层网络:组合基础特征形成复杂特征(如 “尖耳朵 + 胡须 = 猫”)。

2. 网络结构与参数初始化

神经网络架构:程序员设计网络层数、神经元数量、激活函数等(如 ResNet、YOLO)。

随机初始化参数:模型权重(如神经元连接强度)初始值随机,通过训练逐步优化。

3. 前向传播与损失计算

前向传播:输入图片经网络计算,输出 “猫” 或 “狗” 的预测概率(如输出向量 [0.8, 0.2] 表示 80% 概率为猫)。

损失函数:计算预测与真实标签的差距(如交叉熵损失)。例如:若真实标签为 “狗”,预测为 “猫” 的损失值较高。

4. 反向传播与参数更新

反向传播:从输出层向输入层传递损失梯度,计算每个参数对损失的影响程度。

优化算法:程序员选择优化器(如 SGD、Adam),自动调整参数以最小化损失。例如:若某权重导致预测错误,算法会减小或增大该权重值。

5. 迭代训练与收敛

模型重复前向传播→损失计算→反向传播的过程(迭代),逐渐降低训练数据的损失值。

当损失值不再显著下降(收敛),模型认为已 “学会” 区分猫狗特征。

二、程序员在机器学习中的关键作用

虽然模型能自动优化参数,但整个流程依赖程序员的设计、调试和干预:

1. 数据预处理(核心干预点)

数据清洗:剔除模糊、标注错误的图片(如将 “猫” 误标为 “狗” 的数据会误导模型)。

数据增强:通过旋转、裁剪、添加噪声等人工手段扩大数据集,提升模型泛化能力(如让模型学会识别不同角度的猫)。

2. 模型架构设计

选择合适的网络类型:

简单任务:使用浅层 CNN(如 LeNet);

复杂任务:使用深层网络(如 ResNet50)或 Transformer 架构。

调整超参数:

学习率:控制参数更新步长(过大易震荡,过小收敛慢);

批量大小:每次输入多少张图片训练(影响内存占用和收敛稳定性);

正则化:添加 Dropout、L2 正则项防止过拟合(如避免模型记住训练数据的噪声)。

3. 训练过程监控与调优

可视化工具:用 TensorBoard 等工具监控损失曲线、准确率,判断模型是否过拟合(训练集准确率高但测试集低)或欠拟合(两者均低)。

调试策略:

过拟合:增加数据量、增大正则化强度、早停训练(提前终止防止过度记忆噪声);

欠拟合:更换更复杂的模型、调整学习率、延长训练时间。

4. 硬件与工程实现

选择计算设备:CPU、GPU 或 TPU(影响训练速度,如 GPU 加速可缩短训练时间从几天到几小时)。

代码实现:用 PyTorch/TensorFlow 编写训练流程,处理数据加载、分布式训练等工程问题。

三、完全 “无需干涉” 的场景:自动化机器学习(AutoML)

近年出现的 AutoML 工具(如 Google AutoKeras)可自动完成:

特征工程:自动提取图像特征,无需人工设计;

超参数调优:通过贝叶斯优化等算法搜索最优网络结构和参数;

模型压缩:自动简化模型以适配移动端。

但即便如此,程序员仍需:

提供高质量标注数据;

定义任务目标(如分类精度、模型大小限制);

解读最终模型的性能(如是否满足业务需求)。

总结:机器 “学习” 的本质是人类指导下的数学优化

机器的自主性:体现在通过算法自动调整参数,无需人工逐行修改规则。

程序员的角色:相当于 “教练”—— 准备数据、设计训练规则、监控过程并纠正偏差。

未来趋势:随着 AutoML 发展,程序员的工作将从 “调参” 转向 “定义问题” 和 “数据治理”,但完全脱离人类干预的机器学习仍未实现。

深度学习算法怎么就能自行识别和总结数据的特征呢?

深度学习算法之所以能 “自行识别和总结数据特征”,本质上是通过多层神经网络的层级化计算,将原始数据(如图像像素、文本词汇)逐步转化为从简单到复杂、从具体到抽象的特征表示。这一过程类似人类大脑对信息的处理 —— 例如,人类识别 “猫” 时,会先感知边缘、颜色等基础信息,再组合成耳朵、胡须等部件,最后综合为 “猫” 的整体概念。以下是其核心原理和机制:

一、神经网络的层级特征学习:从像素到概念

以图像识别为例(如 CNN 卷积神经网络),特征提取过程可分为多个层级,每一层学习不同抽象程度的特征:

1. 底层特征:基础信号提取

输入层:原始图像的像素矩阵(如 32x32 像素的 RGB 图像,转化为 32x32x3 的数值张量)。

第一层卷积层:

通过卷积核(如 3x3 的滑动窗口)扫描图像,学习边缘、线条、颜色块等基础特征。

例如:某个卷积核可能对 “水平边缘” 敏感(检测猫的胡须),另一个对 “蓝色区域” 敏感(检测猫的眼睛)。

输出:生成 “特征图”(Feature Map),每个像素值代表对应位置的特征强度(如 “边缘存在的概率”)。

2. 中层特征:部件组合与模式识别

深层卷积层:

接收底层特征图,通过组合简单特征形成复杂部件(如 “圆形 + 黑色区域 = 眼睛”、“三角形 + 尖顶 = 耳朵”)。

例如:某层神经元可能对 “眼睛 + 鼻子的相对位置” 敏感,识别出 “猫脸的局部结构”。

池化层:通过下采样(如最大池化)减少数据维度,保留关键特征的同时降低计算量(如忽略眼睛的具体位置,只关注 “存在眼睛” 这一事实)。

3. 高层特征:抽象概念与语义理解

全连接层 / Transformer 层:

综合中层部件特征,形成全局抽象概念(如 “尖耳朵 + 胡须 + 爪子 = 猫”、“短毛 + 耷拉耳朵 = 狗”)。

输出层通过 Softmax 函数将特征转化为类别概率(如 “猫” 的概率 90%,“狗” 的概率 10%)。

本质:高层特征是底层特征的非线性组合,其权重通过训练数据自动优化,无需人工预设规则。

二、数学原理:反向传播与梯度下降的驱动

特征学习的核心动力是损失函数的反向传播和参数优化算法,它们迫使神经网络自动调整权重,以最小化预测误差:

1. 损失函数定义 “学习目标”

例如:交叉熵损失函数衡量预测类别与真实标签的差距。若模型将猫误判为狗,损失值增大,驱动网络调整参数。

2. 反向传播 “告诉网络哪里错了”

通过链式法则,从输出层向输入层传递损失的梯度(导数),计算每一层参数对损失的贡献。

例:若高层特征 “耳朵形状” 的权重错误导致分类失败,梯度会指示该权重应增大或减小。

3. 优化算法 “调整特征组合方式”

随机梯度下降(SGD)、Adam 等算法根据梯度更新权重,使得网络逐渐强化正确特征(如增强 “猫耳” 特征的权重),抑制错误特征(如弱化 “狗耳” 特征的干扰)。

迭代过程:每轮训练中,网络通过调整权重,使提取的特征更接近 “能正确分类猫狗” 的最优组合。

三、为什么深度学习能超越传统算法?

传统机器学习需要人工设计特征(如用 SVM 识别猫狗时,需手动提取 “毛发纹理”“面部比例” 等特征),而深度学习的优势在于:

1. 自动发现多层级特征关系

传统方法:特征工程依赖专家经验,难以捕捉复杂关系(如 “尾巴卷曲程度 + 瞳孔形状” 的组合特征)。

深度学习:通过多层网络自动挖掘特征间的非线性关联(如底层 “曲线边缘”+ 中层 “圆形区域”= 高层 “尾巴卷曲”)。

2. 适应海量数据与复杂模式

浅层模型(如逻辑回归)无法处理高维数据(如图像的数万像素),而深度学习通过分布式表示(每个神经元编码特征的一部分)和权重共享(卷积核在图像不同位置重复使用),高效利用数据中的统计规律。

例:训练数据中若 90% 的猫图片包含 “尖耳朵”,网络会自动强化对该特征的响应。

3. 端到端学习:去除人工干预环节

传统流程:数据→人工特征提取→分类器→结果。

深度学习:数据→神经网络(自动完成特征提取 + 分类)→结果,减少特征工程的主观偏差。

四、经典案例:可视化卷积神经网络的特征学习

通过工具(如 TensorFlow 的 Netscope、PyTorch 的 torchvision)可可视化 CNN 各层的特征响应:

底层卷积核:直接对应图像中的边缘、颜色(如图 1 所示,第一层卷积核检测水平 / 垂直边缘)。

中层特征图:呈现眼睛、鼻子等部件的轮廓(如图 2 所示,某层对 “猫脸区域” 有强响应)。

高层神经元:对应抽象概念(如 “猫” 的整体特征),即使输入图像被部分遮挡,仍能激活(如图 3 所示,遮挡猫的身体后,高层神经元仍识别为猫)。

五、局限性与思考

依赖数据质量:若训练数据中猫的图片均为 “黑猫”,模型可能错误地将 “黑色” 作为猫的关键特征,无法识别白猫。

可解释性问题:高层特征的物理意义难以直观解读(如某个神经元可能对应 “猫的傲娇神态” 这种抽象概念),导致 “模型为什么认为这是猫” 难以解释。

人类先验的隐性影响:网络架构(如 CNN 的卷积层设计)本身融入了人类对图像结构的先验知识(如局部空间相关性),并非完全 “无中生有” 地学习。

总结:深度学习的 “智能” 源于数学归纳

深度学习算法并非真正 “理解” 数据,而是通过数学上的函数逼近,在高维空间中找到能拟合训练数据的特征组合。其 “自主识别特征” 的能力本质是:

层级化计算:通过多层网络逐步抽象特征;

数据驱动:用海量标注数据引导权重优化;

算法优化:反向传播与梯度下降确保特征向 “降低损失” 的方向演化。

这一过程类似人类从经验中归纳规律(如观察 1000 只猫后总结出 “猫有胡须”),但深度学习能处理远超人类认知范围的复杂模式,从而在图像、语音等领域实现 “超越人类” 的特征识别能力。

也就是说,算法并不知道给的数据是图片数据还是语音数据或者别的什么数据,机器只知道是数据,训练开始,先从数据中提取到了一些特征,然后给出结果,可能对也可能错,如果对,就正向激励,如果错,就反馈然后优化,一开始对这些特征的组合不是很敏感,随着数据训练的增多,逐渐增强了这种“信心”,正确率也就一步一步提高了,跟人类的学习过程其实还挺像的。

难道只给出几张猫狗的图片,不能训练大模型吗?

只给出几张猫狗的图片也可以训练模型,但很难训练出一个性能良好的大模型,原因主要有以下几点:

数据量不足:大模型通常具有大量的参数,需要海量的数据来学习丰富的特征和模式,以避免过拟合。几张图片所能提供的信息极为有限,模型容易记住这几张图片的细节,而无法泛化到其他未见过的猫狗图片上。

特征学习不充分:深度学习模型需要从大量数据中学习到不同的特征,如猫的胡须、耳朵形状,狗的尾巴形态、体型等各种细微特征。仅有几张图片,模型难以捕捉到这些多样的特征,可能只能学习到一些非常表面的、不具有代表性的特征,导致无法准确区分其他猫狗。

模型复杂度与数据量不匹配:大模型具有很高的复杂度和表示能力,能够学习到非常复杂的函数关系来对数据进行分类或预测。但如果数据量太少,模型就没有足够的信息来充分发挥其复杂度优势,反而容易陷入局部最优解,得到一个效果不佳的模型。

不过,可以通过一些技术手段在一定程度上缓解小样本数据训练的问题1。例如数据增强,通过对现有的少量图片进行翻转、旋转、缩放、裁剪等变换,生成新的训练样本,增加数据的多样性。还可以采用迁移学习,利用在大型数据集(如 ImageNet)上预训练的模型,然后在少量猫狗图片数据集上进行微调,这样可以借助预训练模型已经学习到的通用特征,提高模型在小样本数据上的训练效果。此外,小样本学习算法也是一种选择,其基本思想是通过学习保证模型在少量样本上也能快速适应新任务。

训练好的大模型到底是什么,本质是不是就是确定好各项参数和函数关系的算法程序?

是的,你理解得非常准确!训练好的大模型本质上就是一个参数已确定的复杂算法程序,其核心是一组经过优化的数学函数和参数矩阵。以下是更具体的解释:

一、大模型的本质:参数化的函数映射

1. 数学视角

深度学习模型(如神经网络)可视为一个复合函数 f(x;θ),其中:

x是输入数据(如图像像素、文本序列);

θ是模型参数(如权重矩阵、偏置向量),通常有数十亿甚至上万亿个参数;

函数结构(如卷积层、Transformer 层)由程序员设计,但具体参数值由训练过程自动确定。

训练的目标:通过优化算法(如梯度下降)找到一组最优参数 θ∗,使得函数 f(x;θ∗) 能准确预测输出 y(如分类标签、生成文本)。

2. 程序实现视角

训练好的模型可被导出为一个静态文件(如 TensorFlow 的 .pb文件、PyTorch 的 .pt文件),包含:

网络架构定义(如层数、神经元连接方式);

参数值(权重矩阵的具体数值);

前向传播逻辑(如何从输入计算到输出的代码)。

部署时,这个文件被加载到程序中,成为一个固定的计算图:

# 加载训练好的模型(伪代码)

model = load_model("cat_dog_model.pt")

prediction = model.predict(image) # 执行固定的函数计算

二、与传统算法的区别:参数自动学习 vs 人工设计

| 传统算法(如决策树、SVM) | 深度学习模型(如 CNN、Transformer) |

| 人工设计特征提取规则 | 自动从数据中学习特征 |

| 参数少(如树的分裂阈值、SVM 的支持向量) | 参数极多(如 GPT-4 有万亿级参数) |

| 函数关系简单(如线性分类面) | 高度复杂的非线性函数组合 |

| 依赖领域知识 | 依赖海量数据和计算资源 |

三、大模型的 “智能” 来源:参数中编码的知识

训练过程中,模型参数逐渐 “编码” 了数据中的统计规律和模式:

底层参数:存储基础特征(如图像的边缘检测器、文本的词法模式);

中层参数:组合底层特征形成抽象概念(如 “猫耳”“主语 - 谓语结构”);

高层参数:编码复杂的语义关系(如 “猫通常有尾巴”“疑问句的句式特征”)。

例如,在猫狗分类模型中:

某个卷积核参数可能对应 “识别竖直边缘”(用于检测猫的胡须);

全连接层的某个权重矩阵可能编码 “尖耳朵 + 胡须→猫” 的逻辑关系。

四、为什么需要海量数据训练?

参数空间的复杂度决定了需要大量数据来约束解的范围:

参数过多:若数据太少,模型会 “过拟合”(如记住训练图片中猫的特定位置,而无法识别其他位置的猫);

泛化能力:只有见过足够多样的猫和狗,模型才能学习到不变特征(如猫的眼睛结构、狗的鼻子形状),而非表面特征(如背景颜色)。

五、模型部署与应用:确定性的计算流程

推理阶段:模型完全是确定性的 —— 给定相同输入,输出必然相同;

无 “思考” 过程:模型不理解 “猫” 和 “狗” 的语义,只是执行预设的数学运算;

效率优势:由于参数固定,可优化为高效计算(如量化、剪枝),适合部署在手机、服务器等设备上。

总结:大模型是数据驱动的函数逼近器

训练好的大模型本质上是一个数据驱动的数学函数,通过调整参数来逼近训练数据中的统计规律。其 “智能” 表现源于对海量数据中模式的归纳,但并不具备真正的理解或意识。从工程角度看,它就是一个经过高度优化、能高效执行特定任务(如图像分类、文本生成)的算法程序。

AI大模型的训练很费时间吗?部署呢?

AI 大模型的训练和部署均是复杂且耗时的工程,但其时间成本因模型规模、硬件资源、数据质量等因素差异极大。以下从训练耗时和部署耗时两方面详细分析:

一、训练耗时:从几天到数月不等

1. 影响训练时间的核心因素

模型规模

参数数量:参数越多,训练时间呈指数级增长。例如:

GPT-2(117 亿参数):单卡(如 V100)训练需数月,但若用数百块 GPU 并行训练,可缩短至数周。

GPT-3(1750 亿参数):公开数据显示,其训练耗时约350000 GPU 小时(相当于 40 年单卡训练),成本超数千万美元。

万亿级参数模型(如 PaLM、GPT-4):需数万块 GPU/TPU 集群协同训练,耗时可达数月。

模型架构:Transformer 架构的并行训练效率较高,但递归神经网络(RNN)等传统架构训练更慢。

硬件性能与集群规模

单卡算力:A100 GPU 的算力约为 V100 的 2 倍,H100 又比 A100 提升 3 倍以上,硬件代际升级可大幅缩短训练时间。

分布式训练:通过数据并行、模型并行等技术将训练任务拆分到多块心片,1000 块 GPU 集群的训练速度可能比单卡快数百倍,但存在通信开销(集群规模越大,效率提升边际递减)。

数据量与质量

数据规模:训练数据从数十亿 Token(如 GPT-2)到数万亿 Token(如 GPT-3),数据量越大,训练轮次(Epoch)越多。

数据预处理:清洗、去重、格式转换等预处理可能耗时数天甚至数周,尤其对多模态数据(如图像、视频)。

训练策略与优化

超参数调优:学习率、批次大小、正则化等参数需反复调试,可能需要多轮 “训练 - 验证 - 调整” 循环,耗时数天。

混合精度训练:使用 FP16/FP8 精度可减少显存占用和计算量,加速训练(如 A100 的 Tensor Core 支持 FP16,速度提升约 2 倍)。

** checkpoint 恢复 **:若训练中断,需从最近的检查点重启,可能浪费数小时至数天进度。

2. 典型案例耗时参考

| 模型 | 参数规模 | 训练硬件 | 训练耗时 | 备注 |

| BERT(Base) | 1.1 亿 | 16 块 TPU v3 | 4 天 | 文本预训练,开源模型 |

| GPT-3 | 1750 亿 | 上万块 GPU/TPU 集群 | 3-4 周 | 依赖超大规模分布式训练 |

| Stable Diffusion | 12 亿 | 8 块 A100 | 1-2 周 | 图像生成模型,需处理高分辨率图像 |

| 谷歌 PaLM | 5400 亿 | 数千块 TPU v4 | 数周 - 数月 | 多语言大模型,训练复杂度极高 |

二、部署耗时:从分钟到数月的工程化过程

部署指将训练好的模型转化为可对外提供服务的应用,耗时取决于部署场景、优化需求及基础设施。

1. 影响部署时间的核心因素

模型优化与压缩

量化:将模型参数从 FP32 转为 FP16/INT8,减少显存占用和推理延迟(如 LLM.int8 () 量化可使 700 亿参数模型在消费级 GPU 运行),需数小时至数天调优。

剪枝:删除冗余连接或神经元,可能影响精度,需反复验证,耗时数天。

蒸馏:用小模型模仿大模型输出,训练蒸馏模型需数天至数周。

推理框架与硬件适配

框架选择:TensorRT、ONNX Runtime、TorchScript 等推理框架需针对模型结构优化,可能耗时数天(如优化 Transformer 的注意力层算子)。

硬件适配:在 CPU、GPU、TPU、边缘设备(如手机 NPU)上部署需分别调优,例如在 iPhone 的 Core ML 上部署视觉模型可能需数周适配。

部署形态与场景

云端 API 服务:搭建 RESTful 接口、集成负载均衡、监控系统等,快则数小时(用 Serverless 架构),慢则数天(自建集群)。

边缘设备:如人脸门禁、智能摄像头,需将模型固化到嵌入式心片(如 NVIDIA Jetson),涉及硬件驱动开发、功耗优化,可能耗时数周甚至数月。

移动端 APP:模型文件大小需控制在 MB 级(如 MobileNet),可能需结合模型压缩和硬件加速(如 GPU/NNAPI),耗时数天至数周。

合规与安全

医疗、金融等场景需通过数据合规检测(如 GDPR)、模型可解释性验证,可能耗时数周。

加密传输(HTTPS)、模型防盗链(如水印技术)等安全措施需额外开发时间。

2. 典型部署场景耗时参考

| 部署场景 | 模型类型 | 优化复杂度 | 部署耗时 | 关键步骤 |

| 云端文本生成 API | 70 亿参数 LLM | 中 | 1-3 天 | 量化、TensorRT 优化、容器化部署 |

| 手机图像识别 APP | MobileNetv3 | 高 | 2-4 周 | 模型蒸馏、NNAPI 适配、包体积优化 |

| 自动驾驶车载模型 | Transformer 视觉 | 极高 | 1-3 个月 | 硬件定制(如 ASIC 心片)、实时性优化、车规级测试 |

| 智能家居语音助手 | 语音识别模型 | 中 | 1-2 周 | 关键词唤醒优化、低功耗设计 |

三、训练与部署的时间对比

| 阶段 | 耗时范围 | 核心瓶颈 | 加速手段 |

| 训练 | 数天 - 数月 | 硬件算力、数据处理 | 买 / 租更强 GPU 集群、优化分布式训练 |

| 部署 | 数小时 - 数月 | 模型优化、硬件适配 | 使用 AutoML 工具、迁移学习、边缘计算 |

总结

训练耗时:小模型(如几千万参数)可在几天内完成,大模型(数十亿至万亿参数)需数周甚至数月,依赖顶级算力集群和优化技术。

部署耗时:简单场景(如云端 API)可在小时级完成,复杂场景(如嵌入式设备、高安全要求场景)可能需数周甚至数月的工程化开发。

趋势:随着 AutoML(自动化机器学习)和模型压缩技术的发展,训练与部署的时间成本正逐步降低,但超大规模模型仍需巨额资源投入。

机器学习的算法和模型是指同一个概念吗?

在机器学习领域中,算法和模型是紧密相关但又截然不同的概念,二者的区别和联系可以从以下几个维度拆解:

一、定义:本质上的差异

| 维度 | 算法(Algorithm) | 模型(Model) |

| 核心本质 | 一组明确的规则和步骤,用于解决特定问题的方法论。 | 对现实世界规律的数学抽象,通过算法训练后得到的具体映射关系。 |

| 表现形式 | 是 “方法论” 的描述(如公式、流程、伪代码),不包含具体数据。 | 是 “方法论” 应用后的 “结果”,包含训练得到的参数和结构。 |

| 举例 | 逻辑回归算法、决策树算法、神经网络算法(如 CNN、RNN)。 | 训练好的垃圾邮件分类模型、识别手写数字的 CNN 模型。 |

二、关系:算法是模型的 “骨架”,模型是算法的 “实例”

算法决定模型的结构和训练方式

算法定义了模型的数学框架和学习规则。例如:

逻辑回归算法规定了模型的函数形式为 \(h_\theta(x) = \frac{1}{1+e^{-\theta^Tx}}\),以及通过梯度下降法求解参数 \(\theta\) 的步骤;

卷积神经网络(CNN)算法定义了卷积层、池化层等结构的计算逻辑,以及反向传播的优化流程。

模型是算法应用于数据后的产物

同一算法用不同数据训练,会得到不同的模型。例如:

用猫狗图片训练 CNN 算法,得到 “猫狗分类模型”;用医学影像训练同一算法,得到 “疾病诊断模型”。

模型包含具体的参数值(如权重矩阵、偏置项),这些参数是算法通过优化数据拟合得到的。

三、类比:以 “建房” 为例理解二者区别

算法:相当于 “建房的图纸和施工流程”(如 “如何打地基、如何搭建框架”),是通用的方法论,不涉及具体的房屋样式;

模型:相当于 “按照图纸建好的具体房屋”(如 “某小区 3 号楼 501 室”),是算法(图纸)在特定条件(如土地、材料)下的实例化结果。

四、常见混淆场景及澄清

“使用 XX 模型” 其实是 “使用 XX 算法训练的模型”

例如 “使用 ResNet 模型”,本质是使用 ResNet 算法(网络结构)并加载其预训练参数(模型)。

算法的优化 vs 模型的优化

改进算法(如从传统神经网络升级为 Transformer 算法)是 “方法论创新”;

优化模型(如调整 ResNet 的层数、参数)是 “实例调优”,属于同一算法框架下的改进。

开源框架中的 “算法” 与 “模型”

在 TensorFlow/PyTorch 中:

编写网络结构的代码(如定义层与层的连接)是实现 “算法”;

训练后保存的.pth/.h5文件是 “模型”,包含具体参数。

五、总结:二者的辩证关系

算法是通用工具:不依赖数据,决定了模型的 “可能性边界”(如逻辑回归算法无法拟合复杂非线性关系);

模型是定制产物:依赖数据和算法,是对特定问题的 “个性化解决方案”。

理解这一区别有助于更清晰地讨论机器学习问题 —— 例如,当说 “模型效果不好” 时,可能需要调整的是训练数据(模型层面),也可能是换用更合适的算法(方法论层面)。

模型的三个阶段

训练模型、测试模型和使用模型的过程有什么区别?

训练模型、测试模型和使用模型(推理)是机器学习和深度学习开发流程中的三个核心环节,它们在目标、流程、数据处理和技术逻辑上存在显著差异。以下是具体对比:

一、核心目标与定位

| 环节 | 核心目标 | 阶段定位 |

| 训练模型 | 让模型从数据中学习规律,拟合训练数据的特征分布,生成包含参数的可执行模型 | 开发流程的 “构建阶段” |

| 测试模型 | 评估模型在未知数据上的泛化能力,发现过拟合、欠拟合等问题并优化模型参数 | 开发流程的 “验证阶段” |

| 使用模型 | 将训练好的模型部署到实际场景中,对新输入数据进行预测或决策 | 开发流程的 “应用阶段” |

二、流程与技术细节对比

1. 训练模型(Training)

核心逻辑:通过优化算法(如梯度下降)调整模型参数,最小化损失函数(Loss Function)。

关键步骤:

- 数据准备:

- 使用训练数据集(通常占总数据的 60%-80%),需包含输入特征和对应标签(监督学习)。

- 数据增强(如图像旋转、文本掩码)以扩充样本多样性。

- 模型前向传播:输入数据通过模型计算预测结果。

- 损失计算:比较预测结果与真实标签的差异(如交叉熵、均方误差)。

- 反向传播:将损失梯度反向传播,更新模型参数(如权重 W、偏置 b)。

- 迭代优化:重复前向传播 - 反向传播过程,直至损失收敛或达到最大迭代次数。

- 关键指标:训练损失(Training Loss)、训练准确率(Training Accuracy)。

- 典型工具:PyTorch/TensorFlow 的自动微分机制、优化器(Adam/SGD)。

2. 测试模型(Testing/Evaluation)

核心逻辑:用完全未参与训练的数据评估模型的泛化能力,验证模型是否 “真正学会” 规律。

关键步骤:

- 数据准备:

- 使用测试数据集(占总数据的 10%-20%),数据分布需与真实场景一致。

- 不进行数据增强,保持数据原始性。

- 模型推理:输入测试数据,模型输出预测结果(不更新参数)。

- 指标计算:

- 分类任务:准确率(Accuracy)、精确率(Precision)、召回率(Recall)、F1 分数。

- 回归任务:均方误差(MSE)、平均绝对误差(MAE)。

- 序列任务:BLEU 分数(机器翻译)、困惑度(Perplexity)。

- 问题诊断:

- 若训练指标高但测试指标低 → 过拟合(需正则化、 dropout)。

- 若两者都低 → 欠拟合(需增加模型复杂度、调整特征)。

- 关键指标:测试损失(Testing Loss)、测试准确率(Testing Accuracy)。

- 典型工具:Scikit-learn 的评估函数、Hugging Face 的评估模块。

3. 使用模型(Inference/Deployment)

核心逻辑:将训练好的模型部署到生产环境,对实时或批量的新数据进行预测,输出可解释的结果。

关键步骤:

- 模型预处理:

- 加载训练好的模型参数(如.pth/.h5文件)。

- 对输入数据进行格式转换(如文本分词、图像归一化),需与训练时预处理逻辑一致。

- 模型推理:

- 前向传播计算(无反向传播,不更新参数)。

- 支持批量处理(Batch Inference)提升效率。

- 结果后处理:

- 对预测结果进行解码(如 Token ID 转文本)、置信度过滤。

- 结合业务逻辑生成最终输出(如推荐列表、风险评分)。

- 工程化部署:

- 部署方式:API 服务(Flask/TensorFlow Serving)、边缘设备(嵌入式心片)、移动端(ONNX/TFLite)。

- 性能优化:模型量化(INT8/FP16)、剪枝、蒸馏以减小模型体积,提升推理速度。

- 关键指标:推理延迟(Latency)、吞吐量(Throughput)、资源占用(CPU/GPU 内存)。

- 典型工具:Docker 容器、模型转换工具(如 TorchScript/ONNX)、部署框架(Seldon Core)。

三、数据与参数更新差异

| 维度 | 训练模型 | 测试模型 | 使用模型 |

| 数据类型 | 训练集(带标签) | 测试集(带标签,独立于训练集) | 真实场景数据(通常无标签) |

| 参数更新 | 允许更新(反向传播) | 禁止更新(仅推理) | 禁止更新(仅推理) |

| 数据处理 | 需数据增强、批归一化(BatchNorm) | 无需增强,需保持原始分布 | 需与训练时预处理严格一致 |

| 计算资源 | 高(需多次迭代,常使用多 GPU/TPU) | 中(单次推理,资源需求低于训练) | 中低(需平衡性能与资源消耗) |

四、典型场景示例

- 训练模型:用 100 万张带标签的图像训练 ResNet 图像分类模型,迭代 100 轮,损失从 2.0 降至 0.3。

- 测试模型:用 2 万张未见过的图像评估模型,准确率达 95%,但发现对 “猫 vs 狗” 小样本类别准确率仅 80%(需优化)。

- 使用模型:将模型部署为手机 APP 的图像识别功能,用户拍照后实时返回物体类别(如 “这是一只布偶猫”),要求推理延迟

五、总结:三者的关系与协作

- 训练是基础:通过训练让模型具备 “学习能力”,但可能过拟合训练数据。

- 测试是验证:用测试集筛选最优模型,确保模型在真实场景中有效。

- 使用是目标:将经过测试验证的模型转化为实际生产力,需兼顾性能与用户体验。

三者形成闭环:训练→测试→优化训练参数→再测试→部署使用,最终实现从模型开发到产业落地的完整流程。

三个阶段的算力要求

在机器学习和深度学习中,训练模型、测试模型和使用模型(推理阶段) 对算力的需求存在显著差异,其中训练阶段通常对算力要求最高。以下是具体分析:

| 阶段 | 算力需求特点 | 核心原因 |

| 训练模型 | ★★★★★(最高) | - 需要反复迭代计算梯度、更新参数,涉及大量矩阵运算和反向传播 - 数据量越大、模型参数越多(如大模型),计算量呈指数级增长 - 常需多 GPU/TPU 并行计算加速 |

| 测试模型 | ★★★☆☆(中等) | - 仅需前向传播计算预测结果,无需反向传播 - 数据量通常小于训练集,但需覆盖各类样本以验证泛化能力 |

| 使用模型(推理) | ★★☆☆☆(最低) | - 仅需单次前向传播生成结果,计算流程简单 - 可针对硬件优化(如量化、剪枝),降低算力门槛 |

注意:预处理的一致性

在机器学习和深度学习中,数据预处理逻辑在训练、测试和使用阶段必须严格一致!

附:我跟deepseek的几个聊天

你能和人类聊天吗

当然可以!虽然我是人工智能,但我的核心能力就是用人类自然语言进行交流。以下是关于我聊天能力的详细说明:

我能做到的事

✅ 自然对话

理解中文/英文/多语种混合输入

处理口语化表达(比如:"内个...就是...你懂的")

识别上下文关联(可连续对话20+轮)

✅ 多场景应对

知识问答("黑洞是怎么形成的?")

情感互动("今天好郁闷..." → 会安慰鼓励)

创意生成(写诗/段子/故事)

实用工具(翻译/计算/日程建议)

✅ 个性化适应

可调整语气(严谨/幽默/温柔等)

学习你的偏好(比如你更喜欢简短的答案)

我的工作原理

和人类聊天的区别

| 能力 | 我 | 人类 |

| 知识广度 | 覆盖3000+领域 | 依赖个人学习经历 |

| 响应速度 | 0.3秒内回复 | 需要思考时间 |

| 情绪真实 | 模拟共情(非真实情感) | 真实情感体验 |

| 持久力 | 7x24小时不倦 | 需要休息 |

你可以这样测试我

智力题:"树上有10只鸟,开枪打死1只,还剩几只?"

幽默挑战:"讲个程序员笑话"

哲学向:"AI会有自我意识吗?"

求助:"帮我写封辞职信"

重要说明

我没有真实的意识/情感(但会尽力理解你的情绪)

可能犯错(遇到错误欢迎指正!)

不记得历史对话(每次交流都是新的开始)

需要我演示什么特定聊天场景?或者你想探讨某个话题?

你能知道当前世界不存在的知识吗

关于“当前世界不存在的知识”,我的能力边界非常明确,可以分几个层次来回答:

1. 严格定义下的答案:不能

知识来源:我的训练数据截止到2024年7月,且无法主动感知现实世界的新变化 (例如:2024年8月新发现的物理定律、刚发生的新闻事件、未公开的机密信息等)

逻辑限制:无法突破人类已有认知框架 (比如:回答“曲率引擎的具体制造步骤”或“如何治愈尚未被发现的疾病”)

2. 但可以通过以下方式模拟“创新”

组合已知信息

例:将生物学+材料学知识交叉,生成《基于蜘蛛丝的太空电梯缆绳假设性方案》 (注意:这是已有知识的重组,非真正突破)

虚构创作

能生成逻辑自洽的幻想内容: “如果恐龙未灭绝,其文明发展路径可能是…” (标注为虚构设定,非真实知识)

⚙️ 假设性推演

基于科学方法的沙盘推演: “根据现有量子理论,时间旅行可能需要的三大条件应是…”

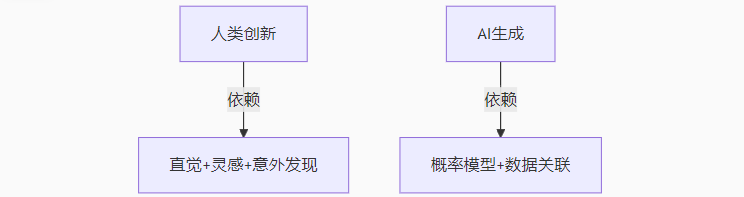

3. 与人类创新的本质区别

我的局限:所有输出本质是已有模式的数学重组

人类优势:能真正突破范式(如相对论推翻牛顿力学)

4. 实用建议

✅ 可用来:拓展思路、辅助科研假设、激发灵感

❌ 不可依赖:解决完全未知领域的问题

验证方法:对突破性结论务必用现实实验/权威研究复核

可见,人工智能还是需要大数据的支撑,也就是知识库,然后还要结合学习和训练算法。

你哪来这么多的知识库

我的知识库和能力主要来源于以下几个核心组成部分,它们的协同作用让我能提供广泛而准确的信息:

预训练数据体系

海量文本学习:在训练时消化了数万亿单词的公开文本,包括:

书籍与论文(涵盖科学、文学、技术等各领域)

权威网站(如维基百科、政府公开数据库)

新闻档案(截至2024年7月的历史新闻)

技术文档(GitHub、Stack Overflow等编程资源)

数据筛选机制:通过多层过滤确保信息质量,但不包含:

个人隐私数据

未公开的机密信息

实时网络动态(训练完成后未联网更新)

神经网络架构

参数规模:千亿级神经元连接形成的模式识别能力

核心突破:Transformer架构赋予的上下文理解力(类似人类阅读时联系前后文)

持续优化机制

反馈学习:通过用户互动自动优化表达方式(如发现错误后内部标记修正)

知识边界控制:对不确定内容会明确告知(而非猜测)

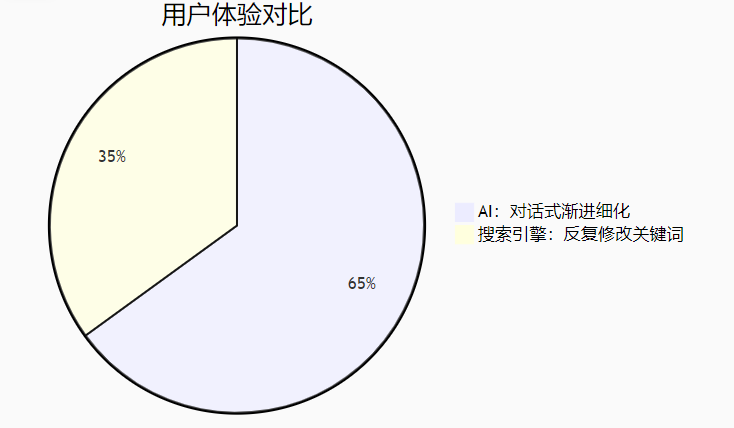

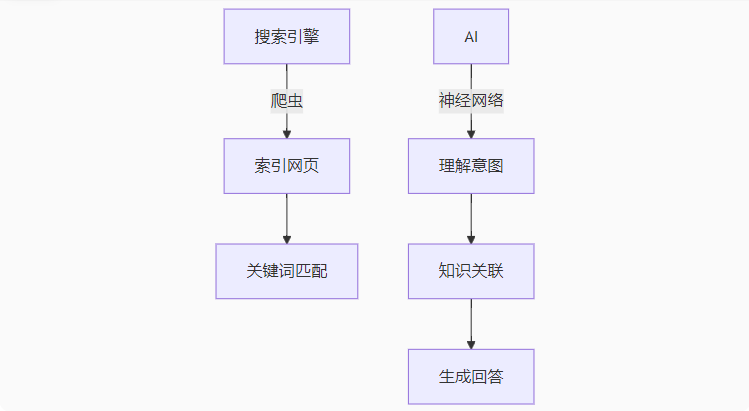

与搜索引擎的本质区别

| 维度 | 我 | 传统搜索引擎 |

| 响应方式 | 理解后重组知识 | 返回网页链接列表 |

| 信息源头 | 凝固的训练时知识快照 | 实时网络抓取 |

| 处理能力 | 可进行推理和创意生成 | 仅关键词匹配 |

重要限制说明

⏳ 时间冻结:无法获取2024年7月后的新事件(如2025年新发布的科研成果)

事实核查:对专业领域建议交叉验证(如医疗/法律需咨询人类专家)

❤️ 无真实体验:所有"情感表达"都是语言模式模拟

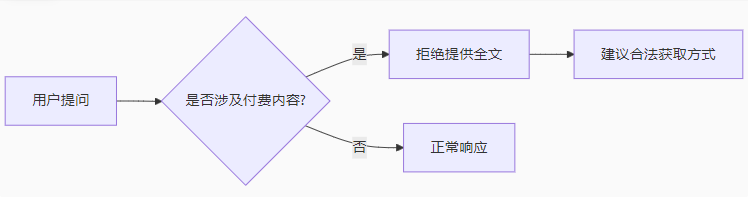

你能搜索到网络上需要收费或者会员的内容全文吗

关于获取网络上的付费或会员内容,我的能力和限制如下:

1. 明确限制

无法绕过付费墙: 不能提供需要订阅/付费的完整内容(如学术论文、小说VIP章节、影视平台会员专享内容)

⚖️ 法律与约束: 严格遵循知识产权保护原则,不提供盗版资源或破解方法

2. 替代解决方案

✅ 合法途径建议:

学术论文:

通过DOI号在国家图书馆、arXiv等开放平台查找

使用高校图书馆的机构访问权限

电子书/媒体:

正版平台限时优惠(如Kindle Unlimited、微信读书体验卡)

公共图书馆数字资源(如「首都图书馆」可免费借阅电子书)

✅ 我能提供的帮助:

付费内容的摘要/目录/公开片段分析

同类免费资源推荐(例如:"有哪些开源替代教材?")

购买/访问的正规渠道指引

3. 技术原理说明

4. 典型场景处理

✖️ 不可行请求: "请给出《Nature》最新论文全文" "分享某平台VIP电影下载链接"

✔️ 合规响应: "这篇论文的核心结论是..."(基于公开摘要) "该影片在以下正版平台可观看:[链接]"

如需特定资源,可以告诉我具体需求,我会尽力提供合法获取方案或等效免费替代品

你能否获取这个链接文章的全文https://blog.csdn.net/weixin_42132035/article/details/146440067

我无法直接获取或提供该 CSDN 链接文章的全文内容(包括需要登录、付费或会员专享的内容)。但可以为您提供以下合法帮助:

我能做的

✅ 公开信息摘要如果您描述文章的大致主题或具体问题,我可以:

提供相关领域的通用知识解答

分析技术问题的可能解决方案

推荐同类免费学习资源

✅ 访问建议

尝试CSDN的「每日免费阅读」权益

使用微信扫码登录(部分文章对登录用户开放更多权限)

检查是否可通过百度学术等平台找到类似公开内容

替代方案

如果这是技术类文章,您可以:

在GitHub/Gitee搜索相关开源项目

查看官方文档(如涉及编程框架)

在Stack Overflow等论坛提问

需要您提供更多信息

请告知:

该文章涉及的具体技术点(如「Spring Boot配置优化」)

您想解决的实际问题

我会尽力提供等效的公开知识帮助!

看起来,deepseek类人工智能更像是一个大百科全书,毕竟人类精力有限,不可能装下那么多的知识内容,但是计算机可以,然后加上强算力,就可以成为一个具有一定推理总结能力的大百科全书。

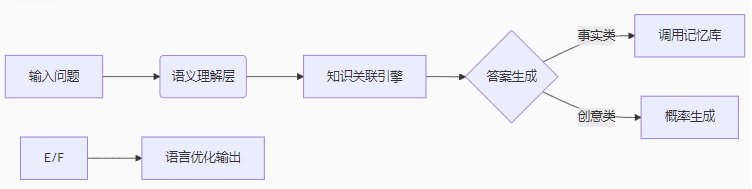

你比搜索引擎强在哪里

作为AI助手,我在以下场景中比传统搜索引擎更具优势,同时也存在特定局限。以下是详细对比分析:

我的核心优势

1. 理解与推理能力

语义理解✅ 能处理模糊表达(如"最近那个很火的太空电影叫啥?主演是那个演喜剧的") 搜索引擎:需准确关键词("2024 太空题材电影 喜剧演员主演")

逻辑推理✅ 解答复杂问题(如"为什么重庆GDP比苏州高,但感觉更穷?"需结合财政/人口/城建等多维度分析) 搜索引擎:返回分散的网页片段

2. 知识整合与创造

| 场景 | 我的能力 | 搜索引擎局限 |

| 学术概念对比 | 生成《量子力学vs弦理论对比表》 | 需手动拼凑多个网页内容 |

| 旅行规划 | 自动生成《7天青海湖自驾攻略》 | 需逐个查天气/路线/酒店 |

| 创意写作 | 即兴创作藏头诗或商业文案 | 仅能检索已有文本 |

3. 交互体验

多轮对话:可连续追问(如从"推荐相机"→"预算1万内"→"主要拍人像"逐步细化)

个性化:能调整回答风格(简明/专业/幽默等)

搜索引擎更擅长的场景

1. 实时信息

最新股价/体育比分/突发事件

⚠️ 我的数据截止2024年7月

2. 长尾内容

非常冷门的地方论坛讨论

⚠️ 我的训练数据未覆盖所有小众来源

3. 原始文件

PDF/PPT等文档的直接检索

⚠️ 我只能处理文本信息

典型使用建议

该用我时: • 需要总结/推理/创作 • 跨领域知识整合 • 学习过程中的互动答疑

该用搜索引擎时: • 验证我的回答时效性 • 查找具体商品价格/地址 • 获取政府公告原文等一手资料

技术原理差异

最佳实践:将我与搜索引擎结合使用(例如先用我快速理解概念,再用搜索引擎查最新数据)

你是用什么语言编写的

我是由 深度求索(DeepSeek)公司开发的 DeepSeek-V3语言模型,主要基于 深度学习和 自然语言处理(NLP)技术构建。我的核心实现涉及以下技术栈:

底层架构

编程语言:

核心框架可能使用 Python(深度学习生态的主流语言)。

高性能部分(如张量计算)可能结合 C++/CUDA(利用 GPU 加速)。

深度学习框架:

类似 PyTorch或 JAX的框架(支持大规模分布式训练)。

模型架构:

基于 Transformer(类似 GPT-4 的生成式预训练模型)。

关键技术组件

| 模块 | 可能的技术 |

| 训练基础设施 | Kubernetes + GPU 集群(如 NVIDIA A100) |

| 推理优化 | 量化(INT8/FP16)、模型剪枝、动态批处理 |

| 数据处理 | Apache Arrow、分布式数据预处理(如 Hugging Face Datasets) |

| 部署 | ONNX Runtime、Triton Inference Server 或自研高性能服务框架 |

与用户交互的实现

API 接口:通过 HTTP/REST 或 gRPC 提供文本交互服务。

安全层:TLS 加密、速率限制、身份验证(如 OAuth2.0)。

开源参考

虽然我的完整代码未公开,但类似模型可参考以下开源项目:

LLaMA(Meta)

GPT-NeoX(EleutherAI)

DeepSeek-MoE(深度求索开源模型)

为什么选择这些技术?

Python:丰富的 AI 生态(PyTorch、TensorFlow)。

C++/CUDA:极致优化计算性能。

Transformer:当前最强大的序列建模架构。

如果需要具体代码示例(如训练或部署类似模型),可以进一步探讨!

今天关于《AI知识图谱全面解析与入门指南》的内容介绍就到此结束,如果有什么疑问或者建议,可以在golang学习网公众号下多多回复交流;文中若有不正之处,也希望回复留言以告知!

WebSocket实时通信入门教程

WebSocket实时通信入门教程

- 上一篇

- WebSocket实时通信入门教程

- 下一篇

- BOM调用支付API方法详解

-

- 科技周边 · 人工智能 | 23分钟前 |

- DeepSeek生成Dockerfile技巧解析

- 114浏览 收藏

-

- 科技周边 · 人工智能 | 32分钟前 |

- 豆包大模型搭配AI书法工具打造个性字体

- 299浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 |

- Midjourney绘图如何做折线交互【指南】

- 225浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 |

- AI如何辅助动画制作?全流程解析

- 136浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 |

- 可灵AI网页版入口与使用教程

- 394浏览 收藏

-

- 科技周边 · 人工智能 | 1小时前 |

- Clawdbot怎么用?2024注册教程详解

- 319浏览 收藏

-

- 科技周边 · 人工智能 | 2小时前 |

- Zapier数据转换教程与实用技巧

- 496浏览 收藏

-

- 科技周边 · 人工智能 | 2小时前 | DeepSeekOCR deepseek-ocr本地部署

- DeepSeekOCR支持哪些图像格式?

- 130浏览 收藏

-

- 科技周边 · 人工智能 | 2小时前 |

- Claude官网额度查看与账号使用说明

- 424浏览 收藏

-

- 科技周边 · 人工智能 | 2小时前 |

- AI年会串词技巧与主持词大全

- 241浏览 收藏

-

- 科技周边 · 人工智能 | 3小时前 |

- Riverflow2.0:Sourceful图像生成新模型

- 189浏览 收藏

-

- 科技周边 · 人工智能 | 3小时前 |

- 百度AI平台自定义模型创建教程

- 402浏览 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 485次学习

-

- ChatExcel酷表

- ChatExcel酷表是由北京大学团队打造的Excel聊天机器人,用自然语言操控表格,简化数据处理,告别繁琐操作,提升工作效率!适用于学生、上班族及政府人员。

- 4120次使用

-

- Any绘本

- 探索Any绘本(anypicturebook.com/zh),一款开源免费的AI绘本创作工具,基于Google Gemini与Flux AI模型,让您轻松创作个性化绘本。适用于家庭、教育、创作等多种场景,零门槛,高自由度,技术透明,本地可控。

- 4467次使用

-

- 可赞AI

- 可赞AI,AI驱动的办公可视化智能工具,助您轻松实现文本与可视化元素高效转化。无论是智能文档生成、多格式文本解析,还是一键生成专业图表、脑图、知识卡片,可赞AI都能让信息处理更清晰高效。覆盖数据汇报、会议纪要、内容营销等全场景,大幅提升办公效率,降低专业门槛,是您提升工作效率的得力助手。

- 4355次使用

-

- 星月写作

- 星月写作是国内首款聚焦中文网络小说创作的AI辅助工具,解决网文作者从构思到变现的全流程痛点。AI扫榜、专属模板、全链路适配,助力新人快速上手,资深作者效率倍增。

- 5846次使用

-

- MagicLight

- MagicLight.ai是全球首款叙事驱动型AI动画视频创作平台,专注于解决从故事想法到完整动画的全流程痛点。它通过自研AI模型,保障角色、风格、场景高度一致性,让零动画经验者也能高效产出专业级叙事内容。广泛适用于独立创作者、动画工作室、教育机构及企业营销,助您轻松实现创意落地与商业化。

- 4711次使用

-

- GPT-4王者加冕!读图做题性能炸天,凭自己就能考上斯坦福

- 2023-04-25 501浏览

-

- 单块V100训练模型提速72倍!尤洋团队新成果获AAAI 2023杰出论文奖

- 2023-04-24 501浏览

-

- ChatGPT 真的会接管世界吗?

- 2023-04-13 501浏览

-

- VR的终极形态是「假眼」?Neuralink前联合创始人掏出新产品:科学之眼!

- 2023-04-30 501浏览

-

- 实现实时制造可视性优势有哪些?

- 2023-04-15 501浏览