Apache Hive-2.3.0 快速搭建与使用

数据库小白一枚,正在不断学习积累知识,现将学习到的知识记录一下,也是将我的所得分享给大家!而今天这篇文章《Apache Hive-2.3.0 快速搭建与使用》带大家来了解一下Apache Hive-2.3.0 快速搭建与使用,希望对大家的知识积累有所帮助,从而弥补自己的不足,助力实战开发!

Hive 简介

Hive 是一个基于 hadoop 的开源数据仓库工具,用于存储和处理海量结构化数据。它把海量数据存储于 hadoop 文件系统,而不是数据库,但提供了一套类数据库的数据存储和处理机制,并采用 HQL (类 SQL )语言对这些数据进行自动化管理和处理。我们可以把 Hive 中海量结构化数据看成一个个的表,而实际上这些数据是分布式存储在 HDFS 中的。 Hive 经过对语句进行解析和转换,最终生成一系列基于 hadoop 的 map/reduce 任务,通过执行这些任务完成数据处理。

Hive 诞生于 facebook 的日志分析需求,面对海量的结构化数据, Hive 以较低的成本完成了以往需要大规模数据库才能完成的任务,并且学习门槛相对较低,应用开发灵活而高效。

Hive 自 2009.4.29 发布第一个官方稳定版 0.3.0 至今,不过一年的时间,正在慢慢完善,网上能找到的相关资料相当少,尤其中文资料更少,本文结合业务对 Hive 的应用做了一些探索,并把这些经验做一个总结,所谓前车之鉴,希望读者能少走一些弯路。

准备工作

环境

JDK:1.8 Hadoop Release:2.7.4 centos:7.3 node1(master) 主机: 192.168.252.121 node2(slave1) 从机: 192.168.252.122 node3(slave2) 从机: 192.168.252.123 node4(mysql) 从机: 192.168.252.124

依赖环境

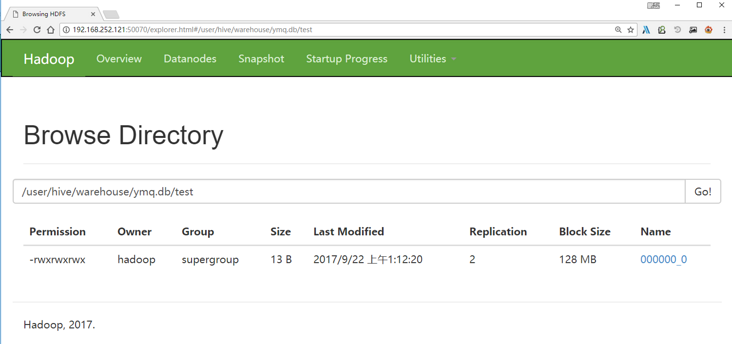

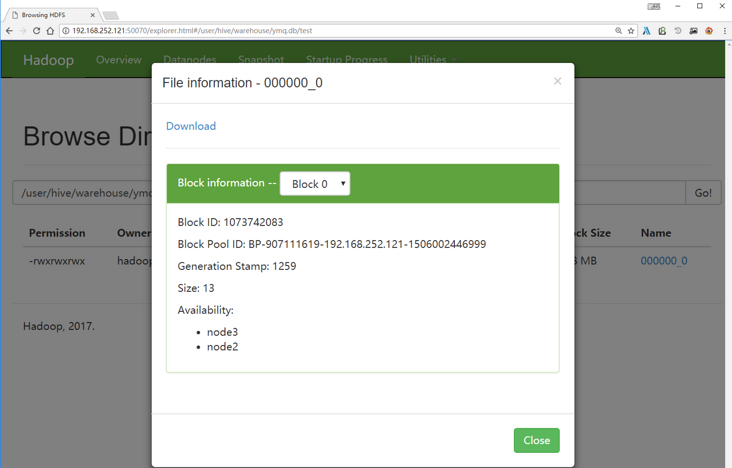

安装 如果是对所有的用户都生效就修改 使环境变量生效,运行 使用 hadoop 新建 hdfs 目录,因为在 hive-site.xml 中有默认如下配置: 进入 hadoop 安装目录 执行hadoop命令新建/user/hive/warehouse目录,并授权,用于存储文件 用以下命令检查目录是否创建成功 搜索hive.exec.scratchdir,将该name对应的value修改为/user/hive/tmp 搜索hive.querylog.location,将该name对应的value修改为/user/hive/log/hadoop 搜索javax.jdo.option.connectionURL,将该name对应的value修改为MySQL的地址 搜索javax.jdo.option.ConnectionDriverName,将该name对应的value修改为MySQL驱动类路径 搜索javax.jdo.option.ConnectionUserName,将对应的value修改为MySQL数据库登录名 搜索javax.jdo.option.ConnectionPassword,将对应的value修改为MySQL数据库的登录密码 并在 首先确保 mysql 中已经创建 如果看到如下,表示初始化成功 启动Hive 创建 hive 库 选择库 创建表 插入数据 查询数据 在界面上查看刚刚写入的hdfs数据su hadoop

cd /home/hadoop/

wget https://mirrors.tuna.tsinghua.edu.cn/apache/hive/hive-2.3.0/apache-hive-2.3.0-bin.tar.gz

tar -zxvf apache-hive-2.3.0-bin.tar.gz

mv apache-hive-2.3.0-bin hive-2.3.0

环境变量

sudo vi /etc/profile

#hive

export PATH=${HIVE_HOME}/bin:$PATH

export HIVE_HOME=/home/hadoop/hive-2.3.0/

cd /home/hadoop/hive-2.3.0/conf

cp hive-default.xml.template hive-site.xml

新建 hdfs 目录

<property><name>hive.metastore.warehouse.dir</name><value>/user/hive/warehouse</value><description>location of default database for the warehouse</description></property><property></property>

cd /home/hadoop/hadoop-2.7.4

bin/hadoop fs -mkdir -p /user/hive/warehouse

bin/hadoop fs -mkdir -p /user/hive/tmp

bin/hadoop fs -mkdir -p /user/hive/log

bin/hadoop fs -chmod -R 777 /user/hive/warehouse

bin/hadoop fs -chmod -R 777 /user/hive/tmp

bin/hadoop fs -chmod -R 777 /user/hive/log

bin/hadoop fs -ls /user/hive

修改 hive-site.xml

<property><name>hive.exec.scratchdir</name><value>/user/hive/tmp</value></property>

<property><name>hive.querylog.location</name><value>/user/hive/log/hadoop</value><description>Location of Hive run time structured log file</description></property>

<property><name>javax.jdo.option.ConnectionURL</name><value>jdbc:mysql://192.168.252.124:3306/hive?createDatabaseIfNotExist=true</value><description>

JDBC connect string for a JDBC metastore.

To use SSL to encrypt/authenticate the connection, provide database-specific SSL flag in the connection URL.

For example, jdbc:postgresql://myhost/db?ssl=true for postgres database.

</description></property>

<property><name>javax.jdo.option.ConnectionDriverName</name><value>com.mysql.jdbc.Driver</value><description>Driver class name for a JDBC metastore</description></property>

<property><name>javax.jdo.option.ConnectionUserName</name><value>root</value><description>Username to use against metastore database</description></property>

<property><name>javax.jdo.option.ConnectionPassword</name><value>mima</value><description>password to use against metastore database</description></property>

创建 tmp 文件

mkdir /home/hadoop/hive-2.3.0/tmp

cp hive-env.sh.template hive-env.sh

vi hive-env.sh

HADOOP_HOME=/home/hadoop/hadoop-2.7.4/

export HIVE_CONF_DIR=/home/hadoop/hive-2.3.0/conf

export HIVE_AUX_JARS_PATH=/home/hadoop/hive-2.3.0/lib

下载 mysql 驱动包

cd /home/hadoop/hive-2.3.0/lib

wget http://central.maven.org/maven2/mysql/mysql-connector-java/5.1.38/mysql-connector-java-5.1.38.jar

初始化 mysql

MySQL数据库进行初始化

cd /home/hadoop/hive-2.3.0/bin

./schematool -initSchema -dbType mysql

Starting metastore schema initialization to 2.3.0

Initialization script hive-schema-2.3.0.mysql.sql

Initialization script completed

schemaTool completed

查看 mysql 数据库

/usr/local/mysql/bin/mysql -uroot -p

mysql> show databases;

+--------------------+

| Database |

+--------------------+

| information_schema |

| hive |

| mysql |

| performance_schema |

| sys |

+--------------------+

5 rows in set (0.00 sec)

mysql> use hive;

Reading table information for completion of table and column names

You can turn off this feature to get a quicker startup with -A

Database changed

mysql> show tables;

+---------------------------+

| Tables_in_hive |

+---------------------------+

| AUX_TABLE |

| BUCKETING_COLS |

| CDS |

| COLUMNS_V2 |

| COMPACTION_QUEUE |

| COMPLETED_COMPACTIONS |

| COMPLETED_TXN_COMPONENTS |

| DATABASE_PARAMS |

| DBS |

| DB_PRIVS |

| DELEGATION_TOKENS |

| FUNCS |

| FUNC_RU |

| GLOBAL_PRIVS |

| HIVE_LOCKS |

| IDXS |

| INDEX_PARAMS |

| KEY_CONSTRAINTS |

| MASTER_KEYS |

| NEXT_COMPACTION_QUEUE_ID |

| NEXT_LOCK_ID |

| NEXT_TXN_ID |

| NOTIFICATION_LOG |

| NOTIFICATION_SEQUENCE |

| NUCLEUS_TABLES |

| PARTITIONS |

| PARTITION_EVENTS |

| PARTITION_KEYS |

| PARTITION_KEY_VALS |

| PARTITION_PARAMS |

| PART_COL_PRIVS |

| PART_COL_STATS |

| PART_PRIVS |

| ROLES |

| ROLE_MAP |

| SDS |

| SD_PARAMS |

| SEQUENCE_TABLE |

| SERDES |

| SERDE_PARAMS |

| SKEWED_COL_NAMES |

| SKEWED_COL_VALUE_LOC_MAP |

| SKEWED_STRING_LIST |

| SKEWED_STRING_LIST_VALUES |

| SKEWED_VALUES |

| SORT_COLS |

| TABLE_PARAMS |

| TAB_COL_STATS |

| TBLS |

| TBL_COL_PRIVS |

| TBL_PRIVS |

| TXNS |

| TXN_COMPONENTS |

| TYPES |

| TYPE_FIELDS |

| VERSION |

| WRITE_SET |

+---------------------------+

57 rows in set (0.00 sec)

启动 Hive

简单测试

cd /home/hadoop/hive-2.3.0/bin

./hive

hive> create database ymq;

OK

Time taken: 0.742 seconds

hive> use ymq;

OK

Time taken: 0.036 seconds

hive> create table test (mykey string,myval string);

OK

Time taken: 0.569 seconds

hive> insert into test values("1","www.ymq.io");

WARNING: Hive-on-MR is deprecated in Hive 2 and may not be available in the future versions. Consider using a different execution engine (i.e. spark, tez) or using Hive 1.X releases.

Query ID = hadoop_20170922011126_abadfa44-8ebe-4ffc-9615-4241707b3c03

Total jobs = 3

Launching Job 1 out of 3

Number of reduce tasks is set to 0 since there's no reduce operator

Starting Job = job_1506006892375_0001, Tracking URL = http://node1:8088/proxy/application_1506006892375_0001/

Kill Command = /home/hadoop/hadoop-2.7.4//bin/hadoop job -kill job_1506006892375_0001

Hadoop job information for Stage-1: number of mappers: 1; number of reducers: 0

2017-09-22 01:12:12,763 Stage-1 map = 0%, reduce = 0%

2017-09-22 01:12:20,751 Stage-1 map = 100%, reduce = 0%, Cumulative CPU 1.24 sec

MapReduce Total cumulative CPU time: 1 seconds 240 msec

Ended Job = job_1506006892375_0001

Stage-4 is selected by condition resolver.

Stage-3 is filtered out by condition resolver.

Stage-5 is filtered out by condition resolver.

Moving data to directory hdfs://node1:9000/user/hive/warehouse/ymq.db/test/.hive-staging_hive_2017-09-22_01-11-26_242_8022847052615616955-1/-ext-10000

Loading data to table ymq.test

MapReduce Jobs Launched:

Stage-Stage-1: Map: 1 Cumulative CPU: 1.24 sec HDFS Read: 4056 HDFS Write: 77 SUCCESS

Total MapReduce CPU Time Spent: 1 seconds 240 msec

OK

Time taken: 56.642 seconds

hive> select * from test;

OK

1 www.ymq.io

Time taken: 0.253 seconds, Fetched: 1 row(s)

页面数据

Contact

- 作者:鹏磊

- 出处:http://www.ymq.io

- Email:admin@souyunku.com

- 版权归作者所有,转载请注明出处

- Wechat:关注公众号,搜云库,专注于开发技术的研究与知识分享

到这里,我们也就讲完了《Apache Hive-2.3.0 快速搭建与使用》的内容了。个人认为,基础知识的学习和巩固,是为了更好的将其运用到项目中,欢迎关注golang学习网公众号,带你了解更多关于mysql的知识点!

innodb 日志机制及优化

innodb 日志机制及优化

- 上一篇

- innodb 日志机制及优化

- 下一篇

- 缓存更新(同步)

-

- 数据库 · MySQL | 19小时前 |

- MySQL增删改查语法速查表大全

- 174浏览 收藏

-

- 数据库 · MySQL | 5天前 |

- MySQLupdate语句使用详解

- 120浏览 收藏

-

- 数据库 · MySQL | 1星期前 |

- MySQL数据库创建与字符集设置教程

- 404浏览 收藏

-

- 数据库 · MySQL | 1星期前 |

- MySQL基础命令速查:增删改查全攻略

- 427浏览 收藏

-

- 数据库 · MySQL | 2星期前 |

- MySQL优化Join查询的技巧与策略解析

- 351浏览 收藏

-

- 数据库 · MySQL | 2星期前 |

- MySQL常用数据类型有哪些及如何选择

- 156浏览 收藏

-

- 数据库 · MySQL | 3星期前 |

- MySQL增删改查语法速查手册

- 405浏览 收藏

-

- 数据库 · MySQL | 3星期前 |

- MySQLgroupby优化技巧与性能提升

- 497浏览 收藏

-

- 数据库 · MySQL | 3星期前 |

- MySQL读写分离方案与中间件解析

- 133浏览 收藏

-

- 数据库 · MySQL | 3星期前 |

- MySQL多方法批量插入数据技巧

- 319浏览 收藏

-

- 数据库 · MySQL | 3星期前 |

- MySQL排序优化与性能提升技巧

- 141浏览 收藏

-

- 数据库 · MySQL | 3星期前 |

- MySQL触发器应用场景及使用教程

- 256浏览 收藏

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 485次学习

-

- ChatExcel酷表

- ChatExcel酷表是由北京大学团队打造的Excel聊天机器人,用自然语言操控表格,简化数据处理,告别繁琐操作,提升工作效率!适用于学生、上班族及政府人员。

- 4113次使用

-

- Any绘本

- 探索Any绘本(anypicturebook.com/zh),一款开源免费的AI绘本创作工具,基于Google Gemini与Flux AI模型,让您轻松创作个性化绘本。适用于家庭、教育、创作等多种场景,零门槛,高自由度,技术透明,本地可控。

- 4455次使用

-

- 可赞AI

- 可赞AI,AI驱动的办公可视化智能工具,助您轻松实现文本与可视化元素高效转化。无论是智能文档生成、多格式文本解析,还是一键生成专业图表、脑图、知识卡片,可赞AI都能让信息处理更清晰高效。覆盖数据汇报、会议纪要、内容营销等全场景,大幅提升办公效率,降低专业门槛,是您提升工作效率的得力助手。

- 4346次使用

-

- 星月写作

- 星月写作是国内首款聚焦中文网络小说创作的AI辅助工具,解决网文作者从构思到变现的全流程痛点。AI扫榜、专属模板、全链路适配,助力新人快速上手,资深作者效率倍增。

- 5816次使用

-

- MagicLight

- MagicLight.ai是全球首款叙事驱动型AI动画视频创作平台,专注于解决从故事想法到完整动画的全流程痛点。它通过自研AI模型,保障角色、风格、场景高度一致性,让零动画经验者也能高效产出专业级叙事内容。广泛适用于独立创作者、动画工作室、教育机构及企业营销,助您轻松实现创意落地与商业化。

- 4703次使用

-

- golang MySQL实现对数据库表存储获取操作示例

- 2022-12-22 499浏览

-

- 搞一个自娱自乐的博客(二) 架构搭建

- 2023-02-16 244浏览

-

- B-Tree、B+Tree以及B-link Tree

- 2023-01-19 235浏览

-

- mysql面试题

- 2023-01-17 157浏览

-

- MySQL数据表简单查询

- 2023-01-10 101浏览