学术研究:单卡训练仅需1天的长视频中噪声关联学习

来源:机器之心

2024-03-07 13:00:08

0浏览

收藏

从现在开始,努力学习吧!本文《学术研究:单卡训练仅需1天的长视频中噪声关联学习》主要讲解了等等相关知识点,我会在golang学习网中持续更新相关的系列文章,欢迎大家关注并积极留言建议。下面就先一起来看一下本篇正文内容吧,希望能帮到你!

论文题目:Multi-granularity Correspondence Learning from Long-term Noisy Videos 论文地址:https://openreview.net/pdf?id=9Cu8MRmhq2 项目地址:https://lin-yijie.github.io/projects/Norton 代码地址:https://github.com/XLearning-SCU/2024-ICLR-Norton

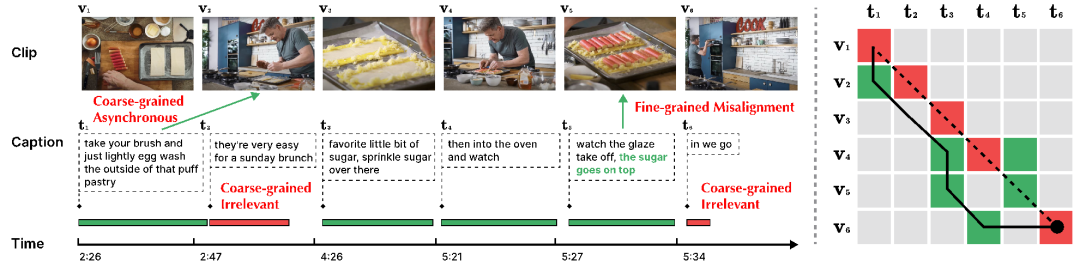

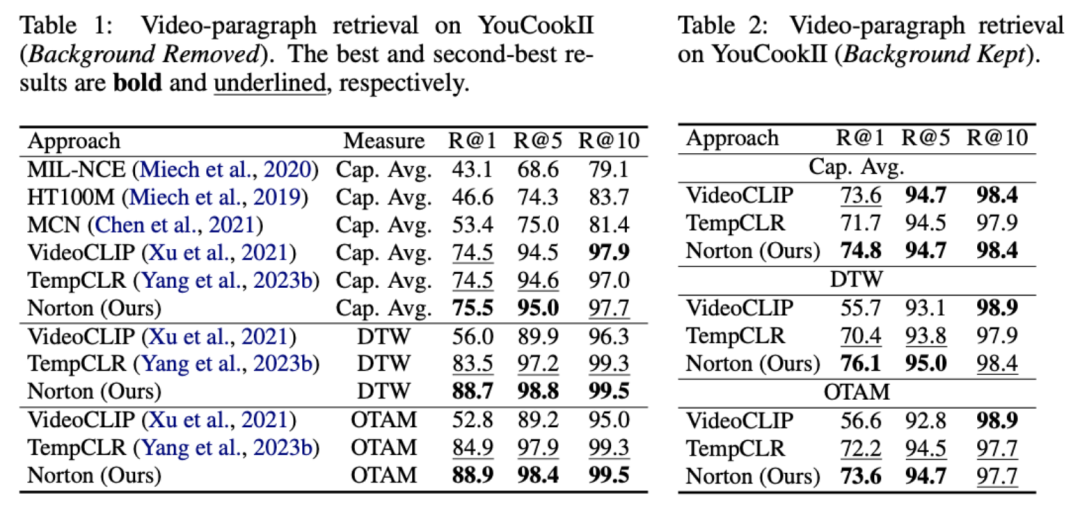

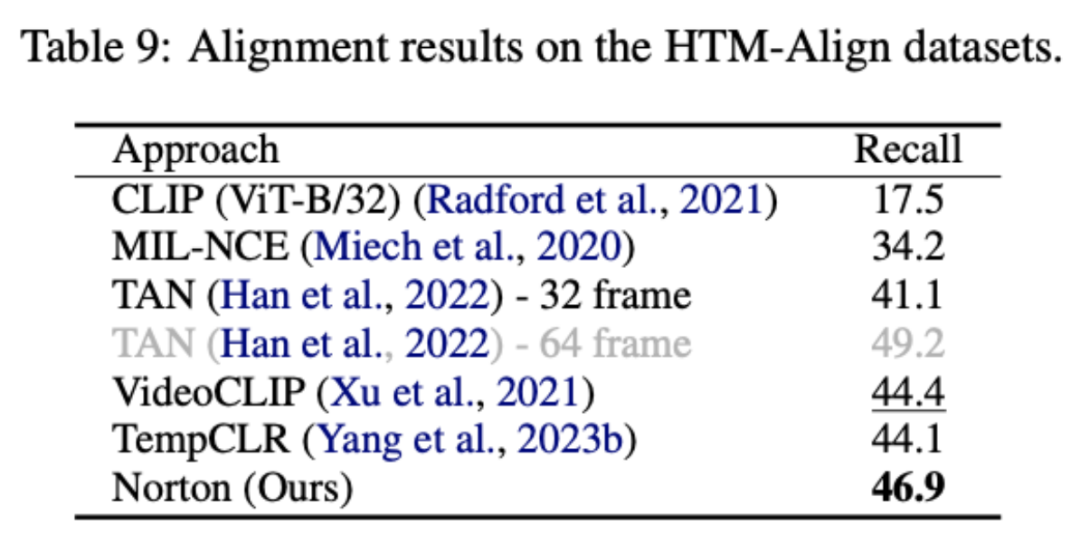

粗粒度 NC(Clip-Caption 间)。粗粒度 NC 包括异步(Asynchronous)和不相关(Irrelevant)两类,区别在于该视频片段或标题能否与现有标题或视频片段相对应。其中「异步」指视频片段与标题间存在时序上的错位,例如图 2 中 t1。由于讲述者在实际执行动作的前后进行解释,导致陈述与行动的顺序不匹配。「不相关」则指无法与视频片段对齐的无意义标题(例如 t2 和 t6),或是无关的视频片段。根据牛津 Visual Geometry Group 的相关研究 [5],HowTo100M 数据集中只有约 30% 的视频片段与标题在视觉上是可对齐的,而仅有 15% 是原本就对齐的; 细粒度 NC(Frame-Word 间)。针对一个视频片段,可能一句文本描述中只有部分文字与其相关。在图 2 中,标题 t5 中「糖撒在上面」与视觉内容 v5 强相关,但动作「观察釉面脱落」则与视觉内容并不相关。无关的单词或视频帧可能会阻碍关键信息提取,从而影响片段与标题间的对齐。

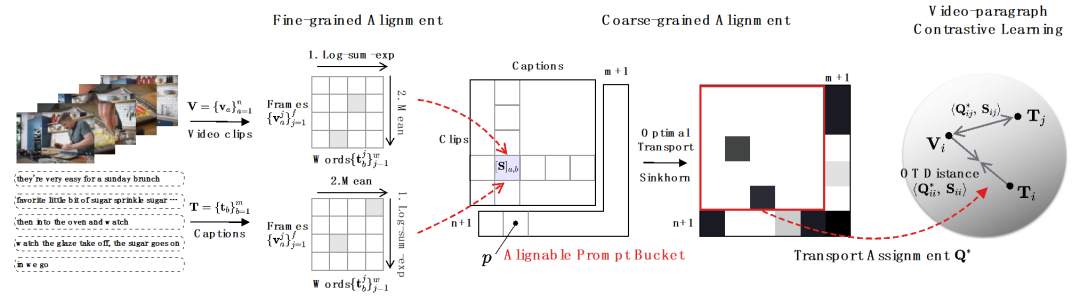

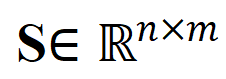

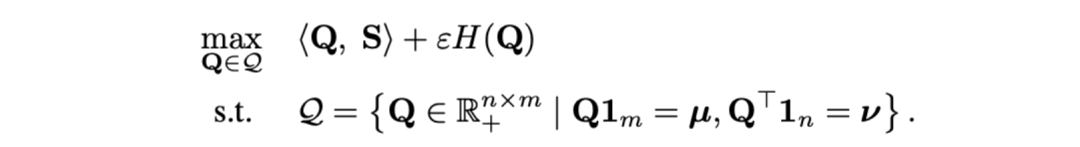

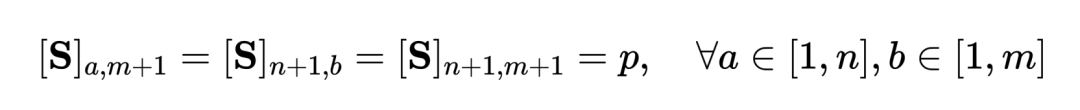

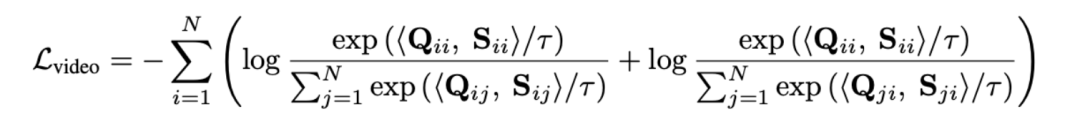

面向细粒度 NC。研究者采用 log-sum-exp 近似作为 Soft-maximum 算子去识别帧 - 词和词 - 帧对齐中的关键词和关键帧,以细粒度的交互方式实现重要信息抽取,累计得到片段 - 标题相似性。 面向粗粒度异步 NC。研究者采用最优传输距离作为视频片段和标题之间的距离度量。给定视频片段 - 文本标题间相似性矩阵  ,其中

,其中 表示片段与标题个数,最优传输目标为最大化整体对齐相似性,可天然处理时序异步或一对多(如 t3 与 v4,v5 对应)的复杂对齐情况。

表示片段与标题个数,最优传输目标为最大化整体对齐相似性,可天然处理时序异步或一对多(如 t3 与 v4,v5 对应)的复杂对齐情况。

为均匀分布给予每个片段、标题同等权重,

为均匀分布给予每个片段、标题同等权重, 为传输指派或重对齐矩,可通过 Sinkhorn 算法求解。

为传输指派或重对齐矩,可通过 Sinkhorn 算法求解。面向粗粒度不相关 NC。受特征匹配中 SuperGlue [6] 启发,我们设计了自适应的可对齐提示桶去尝试过滤不相关的片段与标题。提示桶是一行一列的相同值向量,拼接于相似性矩阵  上,其数值代表是否可对齐的相似度阈值。提示桶可无缝融入最优传输 Sinkhorn 求解中。

上,其数值代表是否可对齐的相似度阈值。提示桶可无缝融入最优传输 Sinkhorn 求解中。

表示第

表示第 个长视频与第

个长视频与第 个文本段落间的相似性矩阵。

个文本段落间的相似性矩阵。

代表训练批次中的所有视频片段和标题个数,单位矩阵

代表训练批次中的所有视频片段和标题个数,单位矩阵 代表对比学习交叉熵损失中的标准对齐目标,

代表对比学习交叉熵损失中的标准对齐目标, 代表融入最优传输矫正目标

代表融入最优传输矫正目标 后的重对齐目标,

后的重对齐目标, 为权重系数。

为权重系数。

以上就是《学术研究:单卡训练仅需1天的长视频中噪声关联学习》的详细内容,更多关于产业,视频表征学习的资料请关注golang学习网公众号!

版本声明

本文转载于:机器之心 如有侵犯,请联系study_golang@163.com删除

写入文件时是否安全,使用 os.O_APPEND|os.O_WRONLY 模式?

写入文件时是否安全,使用 os.O_APPEND|os.O_WRONLY 模式?

- 上一篇

- 写入文件时是否安全,使用 os.O_APPEND|os.O_WRONLY 模式?

- 下一篇

- 安装了 Go 并配置了路径,但仍然遇到错误

查看更多

最新文章

-

- 科技周边 · 人工智能 | 5小时前 |

- OpenArt热点技巧:实时转提示词方法

- 362浏览 收藏

-

- 科技周边 · 人工智能 | 6小时前 |

- 可灵AI缩放转场怎么用_大小变化操作教程

- 283浏览 收藏

-

- 科技周边 · 人工智能 | 6小时前 |

- Depseek客户反馈分析与优化技巧

- 149浏览 收藏

-

- 科技周边 · 人工智能 | 6小时前 |

- DeepSeek优化SQL查询技巧解析

- 221浏览 收藏

-

- 科技周边 · 人工智能 | 7小时前 |

- DeepSeek处理CSV数据的实用技巧

- 449浏览 收藏

-

- 科技周边 · 人工智能 | 7小时前 |

- 千问AI如何根据照片写诗?

- 464浏览 收藏

-

- 科技周边 · 人工智能 | 7小时前 | 智谱清言

- 智谱清言官网入口与使用教程

- 210浏览 收藏

-

- 科技周边 · 人工智能 | 7小时前 | AI智能写作

- AI写作官网链接与在线创作入口

- 143浏览 收藏

-

- 科技周边 · 人工智能 | 7小时前 |

- DeepSeek图表生成技巧与使用建议

- 226浏览 收藏

-

- 科技周边 · 人工智能 | 7小时前 |

- 雷鸟X2实时翻译怎么开?

- 328浏览 收藏

-

- 科技周边 · 人工智能 | 8小时前 |

- EO3.1添加背景音乐详细教程

- 135浏览 收藏

-

- 科技周边 · 人工智能 | 8小时前 |

- Claude提示词怎么写?实用技巧分享

- 292浏览 收藏

查看更多

课程推荐

-

- 前端进阶之JavaScript设计模式

- 设计模式是开发人员在软件开发过程中面临一般问题时的解决方案,代表了最佳的实践。本课程的主打内容包括JS常见设计模式以及具体应用场景,打造一站式知识长龙服务,适合有JS基础的同学学习。

- 543次学习

-

- GO语言核心编程课程

- 本课程采用真实案例,全面具体可落地,从理论到实践,一步一步将GO核心编程技术、编程思想、底层实现融会贯通,使学习者贴近时代脉搏,做IT互联网时代的弄潮儿。

- 516次学习

-

- 简单聊聊mysql8与网络通信

- 如有问题加微信:Le-studyg;在课程中,我们将首先介绍MySQL8的新特性,包括性能优化、安全增强、新数据类型等,帮助学生快速熟悉MySQL8的最新功能。接着,我们将深入解析MySQL的网络通信机制,包括协议、连接管理、数据传输等,让

- 500次学习

-

- JavaScript正则表达式基础与实战

- 在任何一门编程语言中,正则表达式,都是一项重要的知识,它提供了高效的字符串匹配与捕获机制,可以极大的简化程序设计。

- 487次学习

-

- 从零制作响应式网站—Grid布局

- 本系列教程将展示从零制作一个假想的网络科技公司官网,分为导航,轮播,关于我们,成功案例,服务流程,团队介绍,数据部分,公司动态,底部信息等内容区块。网站整体采用CSSGrid布局,支持响应式,有流畅过渡和展现动画。

- 485次学习

查看更多

AI推荐

-

- ChatExcel酷表

- ChatExcel酷表是由北京大学团队打造的Excel聊天机器人,用自然语言操控表格,简化数据处理,告别繁琐操作,提升工作效率!适用于学生、上班族及政府人员。

- 4119次使用

-

- Any绘本

- 探索Any绘本(anypicturebook.com/zh),一款开源免费的AI绘本创作工具,基于Google Gemini与Flux AI模型,让您轻松创作个性化绘本。适用于家庭、教育、创作等多种场景,零门槛,高自由度,技术透明,本地可控。

- 4466次使用

-

- 可赞AI

- 可赞AI,AI驱动的办公可视化智能工具,助您轻松实现文本与可视化元素高效转化。无论是智能文档生成、多格式文本解析,还是一键生成专业图表、脑图、知识卡片,可赞AI都能让信息处理更清晰高效。覆盖数据汇报、会议纪要、内容营销等全场景,大幅提升办公效率,降低专业门槛,是您提升工作效率的得力助手。

- 4354次使用

-

- 星月写作

- 星月写作是国内首款聚焦中文网络小说创作的AI辅助工具,解决网文作者从构思到变现的全流程痛点。AI扫榜、专属模板、全链路适配,助力新人快速上手,资深作者效率倍增。

- 5842次使用

-

- MagicLight

- MagicLight.ai是全球首款叙事驱动型AI动画视频创作平台,专注于解决从故事想法到完整动画的全流程痛点。它通过自研AI模型,保障角色、风格、场景高度一致性,让零动画经验者也能高效产出专业级叙事内容。广泛适用于独立创作者、动画工作室、教育机构及企业营销,助您轻松实现创意落地与商业化。

- 4710次使用

查看更多

相关文章

-

- GPT-4王者加冕!读图做题性能炸天,凭自己就能考上斯坦福

- 2023-04-25 501浏览

-

- 单块V100训练模型提速72倍!尤洋团队新成果获AAAI 2023杰出论文奖

- 2023-04-24 501浏览

-

- ChatGPT 真的会接管世界吗?

- 2023-04-13 501浏览

-

- VR的终极形态是「假眼」?Neuralink前联合创始人掏出新产品:科学之眼!

- 2023-04-30 501浏览

-

- 实现实时制造可视性优势有哪些?

- 2023-04-15 501浏览